NVIDIA H100 Tensor Core GPU ile, yüksek performans, ölçeklenebilirlik ve güvenlik elde edebilirsiniz. NVIDIA NVLink Switch System ile 256 H100 GPU bir araya getirilebilir ve bu sayede exascale iş yüklerini hızlandırmak mümkün olabilir. H100 GPU, trilyon parametreli dil modellerini çözmek için özel bir transformer motoru da içermektedir. H100’ün bir araya getirdiği teknolojik yenilikler, büyük dil modellerini önceki nesile göre %30 daha hızlı hale getirebilir.

Büyük Dil Modelleri(LLM) Çıkarımını Hızlandırın

175 milyar parametreye kadar olan büyük dil modelleri için, PCIe tabanlı H100 NVL, NVLink köprüsüyle Transformer Engine, NVLink ve 188 GB HBM3 belleği kullanarak optimum performans ve kolay ölçeklenebilirlik sağlar. H100 NVL GPU’larla donatılmış sunucular, güç sınırlı veri merkezi ortamlarında düşük gecikme süresini korurken NVIDIA DGX A100 sistemlerine göre GPT-175B model performansını 12 kat artırır.

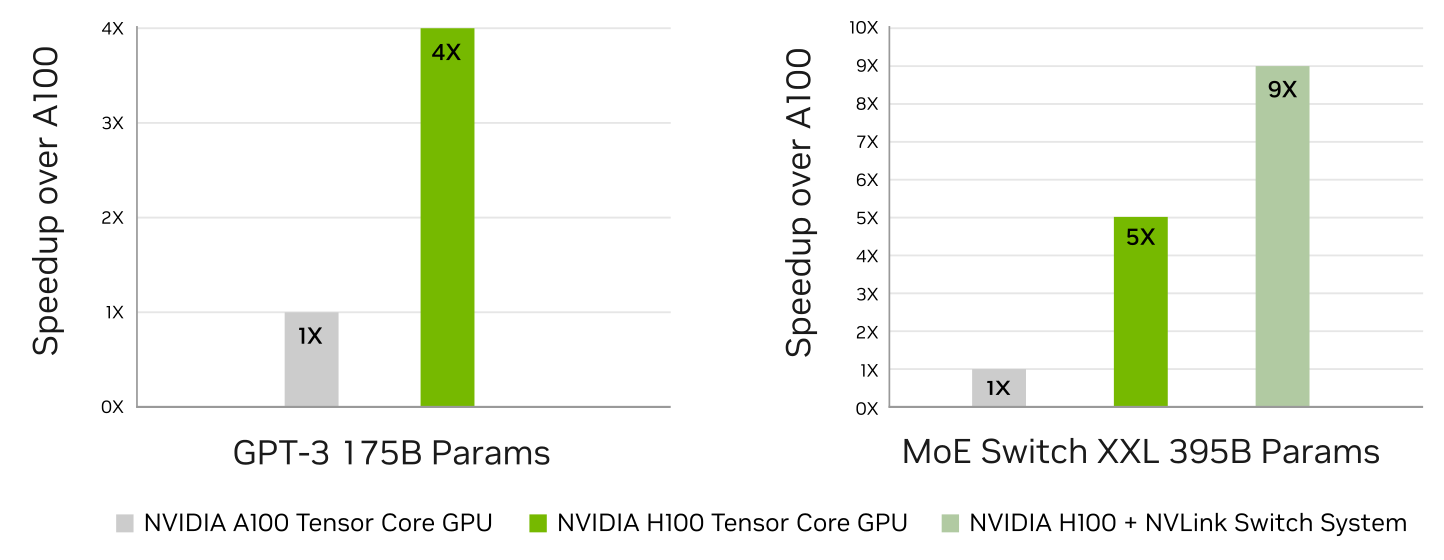

GPT-3 Üzerinde AI Eğitiminde %4’e kadar Daha Yüksek Performans

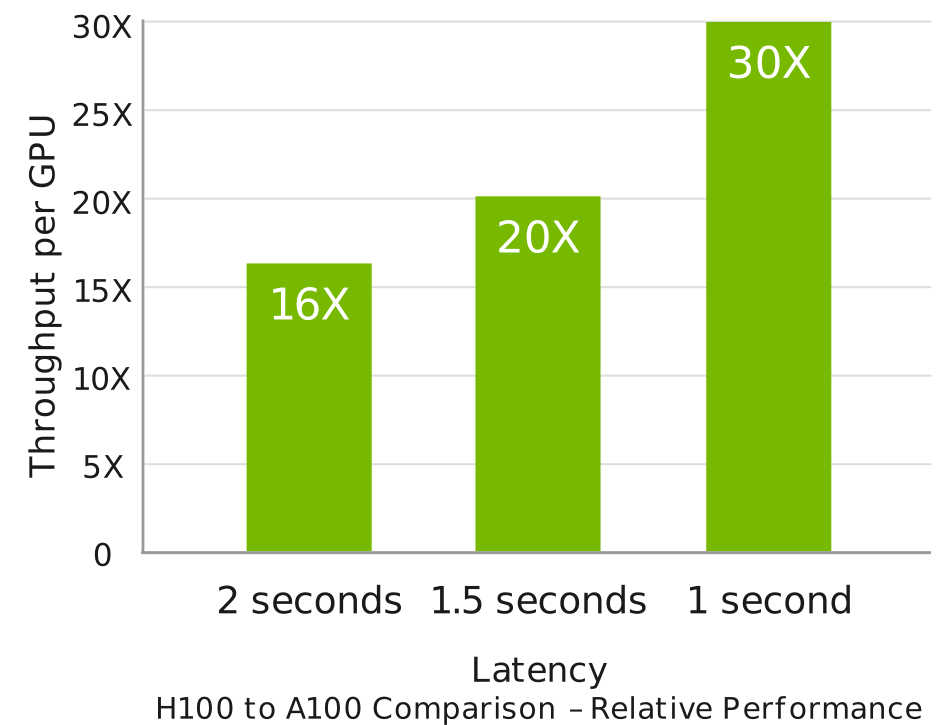

Beklenen performans değişebilir. Giriş dizisi uzunluğu=128, çıkış dizisi uzunluğu=20 olan Megatron 530B parametreli modelin çıkarımı için | A100 kümesi: HDR IB ağı | H100 kümesi: 16 H100 yapılandırması için NDR IB ağı | 32 A100 ile 16 H100 için 1 ve 1.5 saniye süresinde | 16 A100 ile 8 H100 için.

Yapay Zeka Eğitimindeki Dönüşümsel Gelişmeler

H100, dördüncü nesil Tensor Cores ve FP8 hassasiyetinde bir Transformer Motoru içeriyor, bu da GPT-3 (175B) modelleri için önceki nesile göre 4 kat daha hızlı eğitim sağlıyor. Dördüncü nesil NVLink’in sunduğu 900 gigabayt/saniye GPU-GPU bağlantısı, NDR Quantum-2 InfiniBand ağının her GPU arasındaki iletişimi hızlandırması, PCIe Gen5 ve NVIDIA Magnum IO™ yazılımı; küçük işletme sistemlerinden büyük, birleşik GPU küme sistemlerine kadar verimli ölçeklenebilirlik sağlıyor.

Veri merkezi ölçeğinde H100 GPU’ların kullanımı olağanüstü performans sağlıyor ve exascale yüksek performanslı hesaplama (HPC) ve trilyon-parametreli yapay zeka gibi bir sonraki nesil teknolojileri tüm araştırmacıların erişimine sunuyor.

Büyük Modeller Üzerinde AI Çıkarımında %30’a kadar Daha Yüksek Performans

H100, gerçek zamanlı çıkarımı %30’a kadar hızlandırıp en düşük gecikmeyi sunuyor. Dördüncü nesil Tensor Cores, FP64, TF32, FP32, FP16, INT8 ve şimdi FP8 dahil olmak üzere tüm hassasiyetleri hızlandırarak bellek kullanımını azaltıp performansı arttırıyor.

Gerçek Zamanlı Derin Öğrenme Çıkarımı

Beklenen performans değişiklik gösterebilir. GPT-3 175B eğitimi için A100 kümesi: HDR IB ağı, H100 kümesi: NDR IB ağı | 1T token veri setinde 395B parametreye sahip Mixture of Experts (MoE) Eğitim Transformer Switch-XXL varyantı için, belirtilen yerlerde NVLink Anahtar Sistemi ile A100 kümesi: HDR IB ağı, H100 kümesi: NDR IB ağıyla.

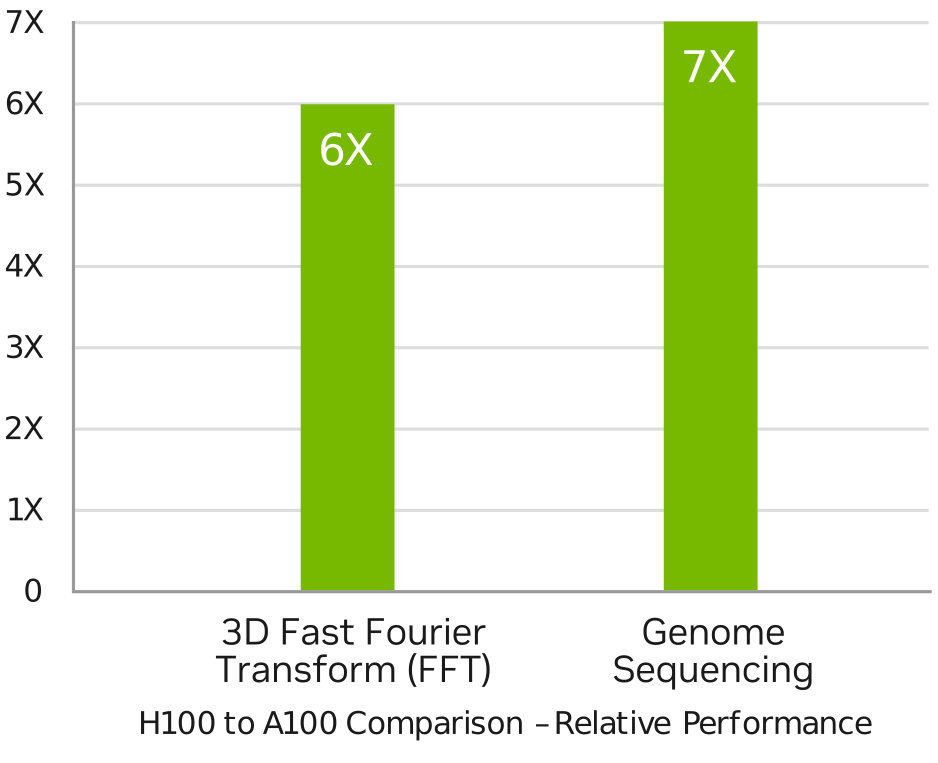

HPC Uygulamaları için %7’ye Kadar Daha Yüksek Performans

Beklenen performans değişebilir. 3D FFT (4K^3) verimliliği | A100 kümesi: HDR IB ağı | H100 kümesi: NVLink Anahtar Sistemi, NDR IB | Genom Sıralama (Smith-Waterman) | 1 A100 | 1 H100

Büyük Modeller Üzerinde AI Çıkarımında %30’a kadar Daha Yüksek Performans

H100, çift hassasiyetli Tensor Cores’un işlem başına saniyede (FLOPS) işlem gücünü üçe katlayarak HPC için 60 teraflop FP64 hesaplama gücü sağlar. AI entegre HPC uygulamaları H100’ün TF32 hassasiyetini kullanarak kod değişikliği olmadan tek hassasiyetli matris çarpımı işlemleri için bir petaflopluk verimlilik elde edebilir.

H100 ayrıca, DNA dizilimi için Smith-Waterman ve protein yapı tahmini için protein hizalaması gibi dinamik programlama algoritmalarında A100’e göre %7 daha yüksek ve CPU’lar üzerinde %40 hızlandırma sağlayan yeni DPX talimatlarını içerir.

| Form Faktör | H100 SXM | H100 PCIe | H100 NVL |

|---|---|---|---|

| FP64 | 34 teraFLOPS | 26 teraFLOPS | 68 teraFLOPs |

| FP64 Tensor Core | 67 teraFLOPS | 51 teraFLOPS | 134 teraFLOPs |

| FP32 | 67 teraFLOPS | 51 teraFLOPS | 134 teraFLOPs |

| TF32 Tensor Core | 989 teraFLOPS | 756 teraFLOPS | 1,979 teraFLOPs |

| BFLOAT16 Tensor Core | 1,979 teraFLOPS | 1,513 teraFLOPS | 3,958 teraFLOPs |

| FP16 Tensor Core | 1,979 teraFLOPS | 1,513 teraFLOPS | 3,958 teraFLOPs |

| FP8 Tensor Core | 3,958 teraFLOPS | 3,026 TOPS | 7,966 teraFLOPs |

| INT8 Tensor Core | 3,958 TOPS | 3,026 TOPS | 7,916 TOPS |

| GPU Belleği | 80GB | 80GB | 188GB |

| GPU Bellek bantgenişliği | 3.35TB/s | 2TB/s | 7.8TB/s3 |

| Decoder | 7 NVDEC 7 JPEG |

7 NVDEC 7 JPEG |

14 NVDEC 14 JPEG |

| Maksimum TDP | 700 W(özelleştirilebilir.) | 300-350W(özelleştirebilir.) | 2x 350-400W(özelleştirilebilir.) |

| Multi-Instance GPU | 7 adet MIG’in her biri 10GB’lık | 7 adet MIG’in her biri 10GB’lık | 14 adet MIG’in her biri 12GB’lık |

| Form Faktör | SXM | PCIe çift yuvalı hava soğutmalı |

2x PCIe çift yuvalı hava soğutmalı |

| Ara Bağlantı | NVLink: 900GB/s PCIe Gen5: 128GB/s | NVLink: 600GB/s PCIe Gen5: 128GB/s |

NVLink: 600GB/s PCIe Gen5: 128GB/s |

| Sunucu Opsiyonları | NVIDIA HGX H100 Partner and NVIDIA-Certified Systems™ with 4 or 8 GPUs NVIDIA DGX H100 with 8 GPUs | Partner and NVIDIA-Certified Systems with 1–8 GPUs |

Partner and NVIDIA-Certified Systems with 2-4 pairs |

| NVIDIA AI Enterprise | Eklenebilir | Dahili | Eklenebilir |