NVIDIA HGX AI SÜPER BİLGİSAYARI

Dünyanın en güçlü uçtan uca AI hesaplama platformu

NVIDIA HGX AI SÜPER BİLGİSAYARI

En güçlü uçtan uca AI hesaplama platformu

Yapay Zeka ve Yüksek Performanslı Hesaplama için Tasarlandı

Yapay zeka, karmaşık simülasyonlar ve büyük veri kümeleri, son derece hızlı bağlantılara sahip birden fazla GPU ve tamamen hızlandırılmış bir yazılım yığını gerektirir. NVIDIA HGX AI süper bilgisayar platformu, NVIDIA GPU’larının, NVIDIA NVLink’in, NVIDIA ağlarının ve tamamen optimize edilmiş AI ve yüksek performanslı hesaplama (HPC) yazılım yığınlarının tüm gücünü bir araya getirerek en yüksek uygulama performansını sağlar ve içgörülere en hızlı şekilde ulaşmayı sağlar.

HIZLANDIRILMIŞ UÇTAN UCA HESAPLAMA PLATFORMU

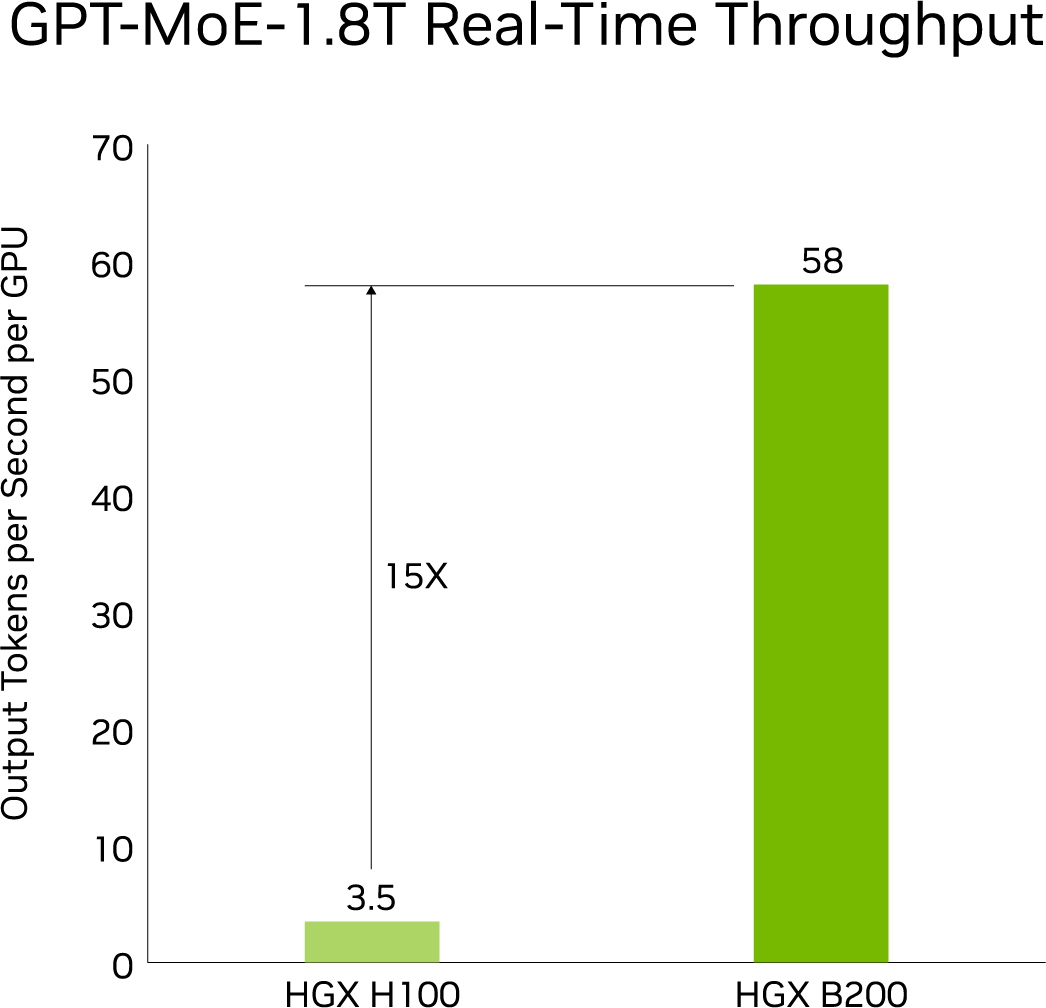

NVIDIA HGX B200 ve HGX B100, veri merkezini hızlandırılmış hesaplama ve üretken yapay zekanın yeni bir dönemine taşımak için NVIDIA Blackwell Tensor Core GPU’larını yüksek hızlı ara bağlantılarla entegre eder. Önceki nesilden 15 kata kadar daha fazla çıkarım performansına sahip birinci sınıf hızlandırılmış ölçeklendirme platformu olarak, Blackwell tabanlı HGX sistemleri en zorlu üretken yapay zeka, veri analitiği ve HPC iş yükleri için tasarlanmıştır.

NVIDIA HGX, en yüksek yapay zeka performansı için NVIDIA Quantum-2 InfiniBand ve Spectrum™-X Ethernet kullanarak saniyede 400 gigabite (Gb/s) kadar hızlarda gelişmiş ağ seçenekleri içerir. HGX ayrıca, hiper ölçekli yapay zeka bulutlarında bulut ağ oluşturma, birleştirilebilir depolama, sıfır güven güvenliği ve GPU hesaplama esnekliğini etkinleştirmek için NVIDIA® BlueField®-3 veri işleme birimlerini (DPU’lar) içerir.

DERİN ÖĞRENME PERFORMANSI

HugeCTR kütüphanesiyle DLRM, precision = FP16 | NVIDIA A100 80GB batch size = 48 | NVIDIA A100 40GB batch size = 32 | NVIDIA V100 32GB batch size = 32.

Yeni Nesil Büyük Dil Modelleri ile Gerçek Zamanlı Çıkarım

NVIDIA HGX B200 ve HGX B100, veri merkezini hızlandırılmış hesaplama ve üretken yapay zekanın yeni bir dönemine taşımak için NVIDIA Blackwell Tensor Core GPU’larını yüksek hızlı ara bağlantılarla entegre eder. Önceki nesilden 15 kata kadar daha fazla çıkarım performansına sahip birinci sınıf hızlandırılmış ölçeklendirme platformu olarak, Blackwell tabanlı HGX sistemleri en zorlu üretken yapay zeka, veri analitiği ve HPC iş yükleri için tasarlanmıştır.

NVIDIA HGX, en yüksek yapay zeka performansı için NVIDIA Quantum-2 InfiniBand ve Spectrum™-X Ethernet kullanarak saniyede 400 gigabite (Gb/s) kadar hızlarda gelişmiş ağ seçenekleri içerir. HGX ayrıca, hiper ölçekli yapay zeka bulutlarında bulut ağ oluşturma, birleştirilebilir depolama, sıfır güven güvenliği ve GPU hesaplama esnekliğini etkinleştirmek için NVIDIA® BlueField®-3 veri işleme birimlerini (DPU’lar) içerir.

MAKİNE ÖĞRENİMİ PERFORMANSI

Büyük Veri Analiz Karşılaştırması | 30 perakende sorguları, ETL, ML, NLP 10TB dataset | V100 32GB, RAPIDS/Dask | A100 40GB ve A100 80GB, RAPIDS/Dask/BlazingSQL

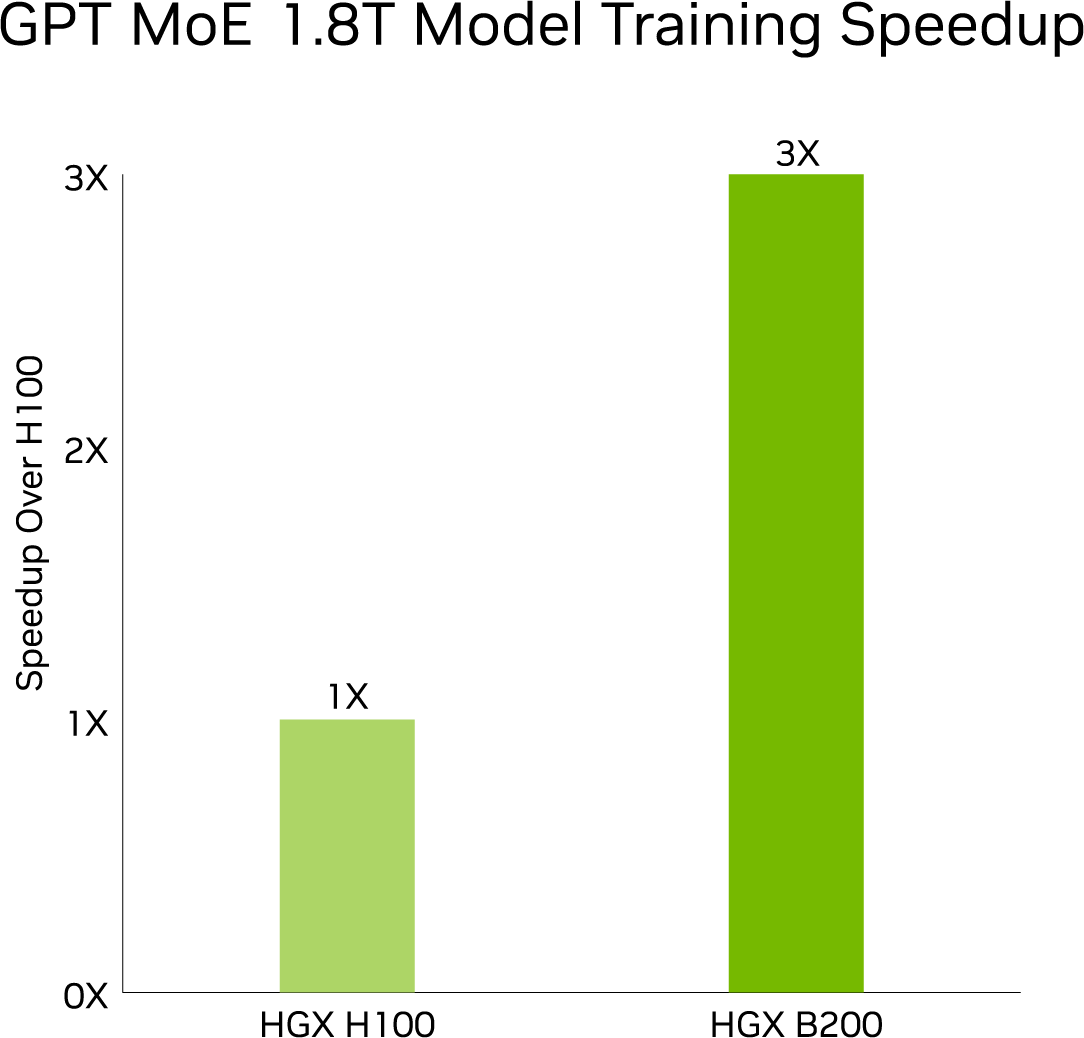

Sonraki Seviye Eğitim Performansı

8 bit kayan nokta (FP8) ve yeni hassasiyetlere sahip ikinci nesil Transformer Engine, GPT-MoE-1.8T gibi büyük dil modelleri için dikkate değer 3 kat daha hızlı eğitim sağlıyor. Bu atılım, 1.8TB/sn GPU-GPU ara bağlantısına sahip beşinci nesil NVLink, InfiniBand ağ oluşturma ve NVIDIA Magnum IO™ yazılımıyla tamamlanıyor. Bunlar birlikte, işletmeler ve kapsamlı GPU hesaplama kümeleri için verimli ölçeklenebilirlik sağlıyor.

NVIDIA HGX ÖZELLİKLERİ

NVIDIA HGX, dört veya sekiz H200 veya H100 GPU’lu veya sekiz Blackwell GPU’lu tekli anakartlarda mevcuttur. Donanım ve yazılımın bu güçlü kombinasyonları, benzeri görülmemiş AI süper bilgisayar performansının temelini oluşturur.

| HGX B200 | |

|---|---|

| Form Faktör | 8x NVIDIA Blackwell GPU |

| FP4 Tensor Çekirdeği | 144 PFLOPS |

| FP8/FP6 Tensor Çekirdeği | 72 PFLOPS |

| INT8 Tensor Çekirdeği | 72 POPS |

| FP16/ BF16 Tensor Çekirdeği | 36 PFLOPS |

| TF32 Tensor Çekirdeği | 18 PFLOPS |

| FP32 | 600 |

| FP64 | 296 TFLOPS |

| FP64 Tensor Çekirdeği | 296 TFLOPS |

| Bellek | 1.4TB'a kadar |

| NVLink | 5.Nesil |

| NVIDIA NVSwitch | 4.Nesil |

| NVSwitch GPU-to-GPU Bandwidth | 1.8TB/s |

| Toplam Bant Genişliği | 14.4 TB/s |

| HGX H200 | ||

|---|---|---|

| 4-GPU | 8-GPU | |

| Form Faktör | 4x NVIDIA H200 SXM | 8x NVIDIA H200 SXM |

| FP8 Tensor Çekirdeği | 16 PFLOPS | 32 PFLOPS |

| INT8 Tensor Çekirdeği | 16 POPS | 32 POPS |

| FP16/BF16 Tensor Çekirdeği | 8 PFLOPS | 16 PFLOPS |

| TF32 Tensor Çekirdeği | 4 PFLOPS | 8 PFLOPS |

| FP32 | 270 TFLOPS | 540 TFLOPS |

| FP64 | 140 TFLOPS | 270 TFLOPS |

| FP64 Tensor Çekirdeği | 270 TFLOPS | 540 TFLOPS |

| Bellek | 564GB HBM3 | 1.1TB HBM3 |

| GPU Bant Genişliği | 19GB/s | 38 GB/s |

| NVLink | 4. Nesil | 4. Nesil |

| NVIDIA NVSwitch | - | 3. Nesil |

| NVSwitch GPU-to-GPU Bandwidth | - | 900GB/s |

| Toplam Bant Genişliği | 3.6TB/s | 7.2TB/s |

| HGX H100 | ||

|---|---|---|

| 4-GPU | 8-GPU | |

| Form Faktör | 4x NVIDIA H100 SXM | 8x NVIDIA H100 SXM |

| FP8 Tensor Çekirdeği | 16 PFLOPS | 32 PFLOPS |

| INT8 Tensor Çekirdeği | 16 POPS | 32 POPS |

| FP16/BF16 Tensor Çekirdeği | 8 PFLOPS | 16 PFLOPS |

| TF32 Tensor Çekirdeği | 4 PFLOPS | 8 PFLOPS |

| FP32 | 270 TFLOPS | 540 TFLOPS |

| FP64 | 140 TFLOPS | 270 TFLOPS |

| FP64 Tensor Çekirdeği | 270 TFLOPS | 540 TFLOPS |

| Bellek | 320GB HBM3 | 640GB HBM3 |

| GPU Bant Genişliği | 13GB/s | 27GB/s |

| NVLink | 4. Nesil | 4. Nesil |

| NVIDIA NVSwitch | - | 3. Nesil |

| NVSwitch GPU-to-GPU Bandwidth | - | 900GB/s |

| Toplam Bant Genişliği | 3.6TB/s | 7.2TB/s |