NVIDIA MAGNUM IO

Modern GPU Hızlandırmalı Veri Merkezleri İçin IO Alt sistemleri

NVIDIA MAGNUM IO

Modern GPU Hızlandırmalı Veri Merkezleri İçin IO Alt sistemleri

NVIDIA MAGNUM IO

Modern GPU Hızlandırmalı Veri Merkezleri İçin IO Alt sistemleri

VERİ MERKEZİ DEPOLAMANIZI VE NETWORK IO PERFORMANSINIZI EN ÜST SEVİYEYE ÇIKARIN

Günümüzün yeni hesaplama birimleri, çekirdeğinde NVIDIA GPU’ları ve NVIDIA Network olan veri merkezleridir. Hızlandırılmış giriş/çıkış(IO) birimleri, hızlandırılmış hesaplamadan maksimum performans almayı sağlar. NVIDIA Magnum IO™, modern veri merkezlerinin IO alt sistemleridir. Çoklu GPU ve çok düğümlü hızlandırma için depolama ve ağ IO performansını en yüksek seviyeye çıkaran, paralel ve asenkron akıllı veri merkezi IO mimarisidir.

Magnum IO Önemli Avantajları

Optimize IO Performansı

GPU belleği, ağ ve depolama arasında doğrudan IO’yu etkinleştirmek için CPU’yu baypas ederek 10 kat daha yüksek bant genişliği sağlar.

Sistem Dengesi ve Kullanım

En yüksek IO bant genişliği sağlayan daha dengeli, GPU hızlandırmalı bir sistem oluşturmak için CPU çekişmesini hafifletir. Bu sayede 10 kata kadar daha az CPU çekirdeği ve 30 kat daha düşük CPU kullanımı sağlar.

Sorunsuz Entegrasyon

Veri aktarımlarının küçük taneli – gecikmeye duyarlı, iri taneli – bant genişliğine duyarlı veya toplu olmasına bakılmaksızın, mevcut ve gelecekteki platformlar için optimize edilmiş uygulama sağlar.

Magnum IO Önemli Avantajları

Optimize IO Performansı

GPU belleği, ağ ve depolama arasında doğrudan IO’yu etkinleştirmek için CPU’yu baypas ederek 10 kat daha yüksek bant genişliği sağlar.

Sistem Dengesi ve Kullanım

En yüksek IO bant genişliği sağlayan daha dengeli, GPU hızlandırmalı bir sistem oluşturmak için CPU çekişmesini hafifletir. Bu sayede 10 kata kadar daha az CPU çekirdeği ve 30 kat daha düşük CPU kullanımı sağlar.

Sorunsuz Entegrasyon

Veri aktarımlarının küçük taneli – gecikmeye duyarlı, iri taneli – bant genişliğine duyarlı veya toplu olmasına bakılmaksızın, mevcut ve gelecekteki platformlar için optimize edilmiş uygulama sağlar.

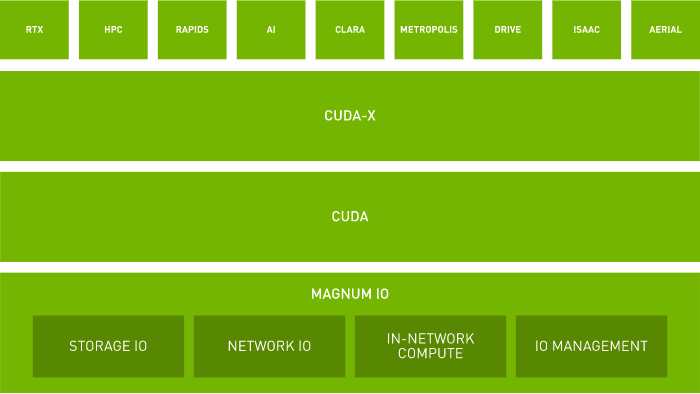

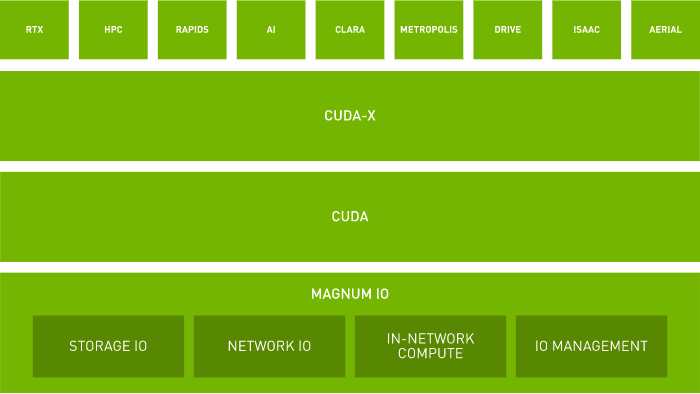

MAGNUM IO OPTİMİZASYON YIĞINI

Magnum IO, çoklu GPU, çok düğümlü sistemler için veri hareketini, erişimini ve yönetimini basitleştirmek ve hızlandırmak için depolama IO, ağ IO, ağ içi hesaplama ve IO yönetimini kullanır. Magnum IO, NVIDIA CUDA-X™ kütüphanelerini destekler. Düşük gecikme süresiyle optimum verim elde etmek için bir dizi NVIDIA GPU ve NVIDIA ağ donanımı topolojisini en yüksek performans alacak şekilde kullanır.

Depolama IO

Çok düğümlü, çok GPU’lu sistemlerde, tek iş parçacıklı CPU performansının, yerel veya uzak depolama aygıtlarından veri erişimine kritik bir etkisi vardır. GPU Depolama IO hızlandırması ile CPU ve sistem belleğini baypas eder. 8X 200 Gb/sn NIC’ler aracılığıyla uzak depolamaya erişerek 1,6 Terabit/sn’ye kadar ham depolama bant genişliği elde eder.

İçindeki Teknolojiler:

Ağ IO

NVIDIA NVLink® yapısı ve RDMA tabanlı ağ IO hızlandırması, IO yükünü azaltarak CPU’yu bypass eder ve doğrudan GPU’dan GPU’ya veri aktarımına olanak tanır.

İçindeki Teknolojiler:

NVIDIA Collective Communication Library >

Ağ İçi Hesaplama

Ağ içi hesaplama, uç noktalara geçişin neden olduğu gecikmeyi ve aktarım esnasındaki tüm atlamaları ortadan kaldırarak ağ içinde hesaplama yapıyor. Veri İşleme birimleri(DPU), önceden konfigüre edilmiş veri işleme motorları ve programlanabilir motorların da dahil olduğu yazılım tanımlı, ağ donanımı ile hızlandırılmış hesaplama çözümü sunuyor.

İçindeki Teknolojiler:

IO Yönetimi

Kullanıcıların, hesaplama, ağ ve depolamada IO optimizasyonu yapabilmesi için, ileri telemetri ve sorun giderme teknikleri kullanması gerekir. Magnum IO yönetim platformları, modern veri merkezi yapısını verimli bir şekilde tedarik etmek, izlemek, yönetmek ve önleyici olarak korumak için araştırma ve endüstriyel veri merkezi operatörlerini güçlendirir.

İçindeki Teknolojiler:

MAGNUM IO OPTİMİZASYON YIĞINI

Magnum IO, çoklu GPU, çok düğümlü sistemler için veri hareketini, erişimini ve yönetimini basitleştirmek ve hızlandırmak için depolama IO, ağ IO, ağ içi hesaplama ve IO yönetimini kullanır. Magnum IO, NVIDIA CUDA-X™ kütüphanelerini destekler. Düşük gecikme süresiyle optimum verim elde etmek için bir dizi NVIDIA GPU ve NVIDIA ağ donanımı topolojisini en yüksek performans alacak şekilde kullanır.

Depolama IO

Çok düğümlü, çok GPU’lu sistemlerde, tek iş parçacıklı CPU performansının, yerel veya uzak depolama aygıtlarından veri erişimine kritik bir etkisi vardır. GPU Depolama IO hızlandırması ile CPU ve sistem belleğini baypas eder. 8X 200 Gb/sn NIC’ler aracılığıyla uzak depolamaya erişerek 1,6 Terabit/sn’ye kadar ham depolama bant genişliği elde eder.

İçindeki Teknolojiler:

Ağ IO

NVIDIA NVLink® yapısı ve RDMA tabanlı ağ IO hızlandırması, IO yükünü azaltarak CPU’yu bypass eder ve doğrudan GPU’dan GPU’ya veri aktarımına olanak tanır.

İçindeki Teknolojiler:

NVIDIA Collective Communication Library >

Ağ İçi Hesaplama

Ağ içi hesaplama, uç noktalara geçişin neden olduğu gecikmeyi ve aktarım esnasındaki tüm atlamaları ortadan kaldırarak ağ içinde hesaplama yapıyor. Veri İşleme birimleri(DPU), önceden konfigüre edilmiş veri işleme motorları ve programlanabilir motorların da dahil olduğu yazılım tanımlı, ağ donanımı ile hızlandırılmış hesaplama çözümü sunuyor.

İçindeki Teknolojiler:

IO Yönetimi

Kullanıcıların, hesaplama, ağ ve depolamada IO optimizasyonu yapabilmesi için, ileri telemetri ve sorun giderme teknikleri kullanması gerekir. Magnum IO yönetim platformları, modern veri merkezi yapısını verimli bir şekilde tedarik etmek, izlemek, yönetmek ve önleyici olarak korumak için araştırma ve endüstriyel veri merkezi operatörlerini güçlendirir.

İçindeki Teknolojiler:

Uygulamalar Arası IO Hızlandırma

Magnum IO, AI’dan bilimsel görselleştirmeye kadar çok çeşitli kullanım durumları için IO hızlandırmak üzere NVIDIA CUDA-X yüksek başarımlı hesaplama (HPC) ve AI kütüphaneleriyle arabirim oluşturur.

Günümüzde en fazla hesaplama kullanılan alanlar veri bilimi ve makine öğrenmesidir. Tahmine dayalı ML modellerinin doğruluğundaki gelişmeler, yazılan kodları milyarlarca dolara dönüştürebilir. Doğruluğu artırmak için RAPIDS™ Accelerator kütüphanesinde, GPU’dan GPU’ya iletişim ve RDMA özelliklerinden yararlanacak şekilde yapılandırılabilen UCX tabanlı, yerleşik hızlandırılmış Apache Spark shuffle bulunur. NVIDIA ağ iletişimi, Magnum IO yazılımı, GPU hızlandırmalı Spark 3.0 ve RAPIDS ile birlikte NVIDIA veri merkezi platformu, bu devasa iş yüklerini benzeri görülmemiş performans ve verimlilik ile hızlandırır.

Adobe, Databricks’te Spark 3.0 ile Model Eğitiminde 7X Hızlanma Sayesinde Maliyetten 90 tasarruf etti >

Bilim insanları, ilaç keşfi için karmaşık molekülleri, yeni enerji kaynakları için fiziği ve anormal hava modellerini daha iyi tahmin etmek için simülasyon yöntemlerinden yararlanıyorlar. Magnum IO, NVIDIA Quantum 2 InfiniBand ağının 400 Gb/sn yüksek bant genişliğini ve ultra düşük gecikme süresini desteklerken, RDMA, GPUDirect ve NVIDIA SHARP gibi donanım düzeyinde hızlandırma motorlarını ve akıllı yükleri ortaya çıkarır.

Kullanıcı uygulamaları çoklu kiracılık ile komşu uygulama trafiğinden gelen rastgele müdahalenin farkında olmayabilir. En yeni NVIDIA Quantum 2 InfiniBand platformundaki Magnum IO, bir kullanıcının performansı üzerindeki olumsuz etkiyi azaltmak için yeni ve geliştirilmiş özelliklere sahiptir. Her ölçekte en verimli yüksek başarımlı hesaplama (HPC) ve makine öğrenimi dağıtımlarının yanı sıra en doğru sonuçları sağlar.

Dünyanın En Büyük İnteraktif Hacim Görselleştirme – 150TB NASA Mars Lander Simülasyonu >

Diyalog tabanlı AI ve derin öneri sistemleri gibi yeni nesil meydan okumalardan dolayı AI modelleri gittikçe kompleksleşiyor. NVIDIA Megatron-BERT gibi diyalog tabanlı AI modelleri, ResNet-50 gibi görüntü sınıflandırma modellerine göre eğitim için 3000 kat daha fazla hesaplama gücü kullanıyor. HDR 200 Gb/sn InfiniBand ağ iletişimi ve Magnum IO yazılım yığınının birleşimi, tek bir kümede binlerce GPU’ya verimli ölçeklenebilirlik sağlıyor. Araştırmacılar, güçlü performans ve ölçeklenebilirlik sayesinde AI sınırlarını zorlamaya devam edebiliyor.