Dünyanın en Güçlü Grafik Kartı

NVIDIA Ampere mimarisi Tensör Çekirdekleri ve Multi-Instance GPU (MIG) ile, geniş ölçekte yapay zeka çıkarımı ve yüksek performanslı hesaplama(HPC) uygulamaları dahil olmak üzere çeşitli iş yüklerinde güvenli bir şekilde hızlanma sağlar. Hızlı bellek bant genişliği ve düşük güç tüketimini ana akım sunucular için ideal olan PCIe form faktöründe bir araya getiren A30, elastik bir veri merkezi sağlar ve işletmeler için maksimum değer sunar.

Modern IT için Veri Merkezi Çözümü

NVIDIA Ampere mimarisi; donanım, ağ, yazılım, kütüphaneler ve NVIDIA NGC™ kataloğundaki optimize edilmiş yapay zeka modelleri ve uygulamaları genelinde yapı taşlarını içeren birleşik NVIDIA EGX™ platformunun bir parçasıdır. Veri merkezleri için en güçlü uçtan uca yapay zeka ve HPC platformunu temsil eden bu platform, araştırmacıların hızla gerçek dünya sonuçları sunmasına ve çözümleri büyük ölçekte üretime dağıtmasına olanak tanır.

Derin Öğrenme Eğitimi

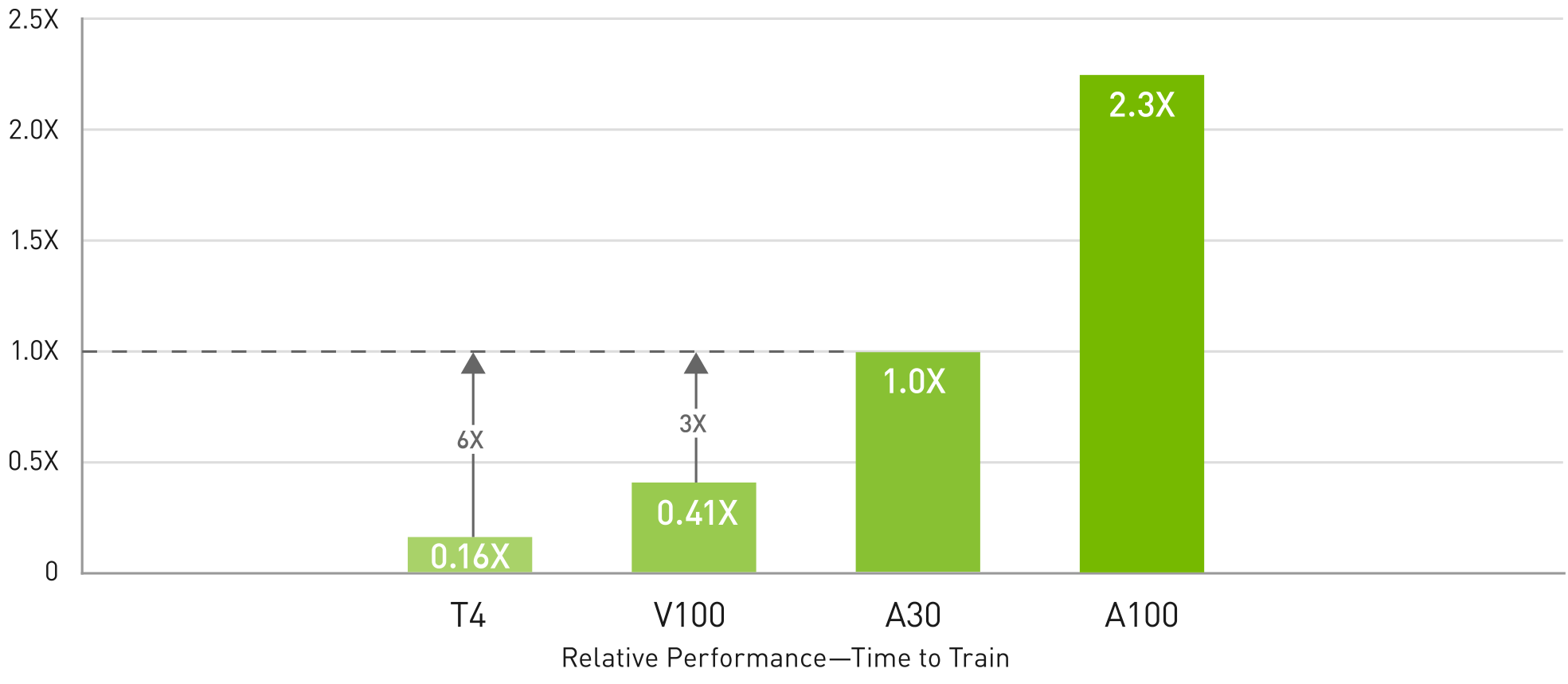

Yapay Zeka Eğitimi – v100’den 3 kata kadar ve T4’ten 6 kata kadar daha yüksek verim

ERT-Large Pre-Training (9/10 epochs) Phase 1 and (1/10 epochs) Phase 2, Sequence Length for Phase 1 = 128 and Phase 2 = 512, dataset = real, NGC™ container = 21.03,

8x GPU: T4 (FP32, BS=8, 2) | V100 PCIE 16GB (FP32, BS=8, 2) | A30 (TF32, BS=8, 2) | A100 PCIE 40GB (TF32, BS=54, 8) | batch sizes indicated are for Phase 1 and Phase 2 respectively

Dile dayalı yapay zeka modellerinin eğitilmesi, muazzam işlem gücü ve ölçeklenebilirlik gerektirir.

Tensor Float (TF32) özellikli NVIDIA A30 Tensor Çekirdekleri, sıfır kod değişikliği ile NVIDIA T4’e göre 10 kata kadar daha yüksek performans ve otomatik karma hassasiyet ve FP16 ile ek 2 kat artış sağlayarak toplamda 20 kat verim artışı sunar. NVIDIA® NVLink®, PCIe Gen4, NVIDIA ağ iletişimi ve NVIDIA Magnum IO™ SDK ile birleştirildiğinde binlerce GPU’ya kadar ölçeklendirmek mümkündür.

Tensör Çekirdekleri ve MIG, A30’un gün boyunca dinamik olarak iş yükleri için kullanılmasını sağlar. Talebin en yoğun olduğu saatlerde üretim çıkarımı için kullanılabilir ve GPU’nun bir kısmı, yoğun olmayan saatlerde aynı modelleri hızla yeniden eğitmek için yeniden kullanılabilir.

Derin Öğrenme Çıkarımı

A30 çıkarım iş yüklerini optimize etmek için çığır açan özelliklerden yararlanır. FP64’ten TF32 ve INT4’e kadar tüm hassaslık aralıklarını hızlandırır. GPU başına dört adede kadar MIG’yi destekleyen A30, garantili hizmet kalitesi (QoS) ile güvenli donanım bölümlerinde birden fazla ağın aynı anda çalışmasını sağlar. Yapısal seyreklik desteği, A30’un diğer çıkarım performansı kazanımlarına ek olarak 2 kata kadar daha fazla performans sunar.

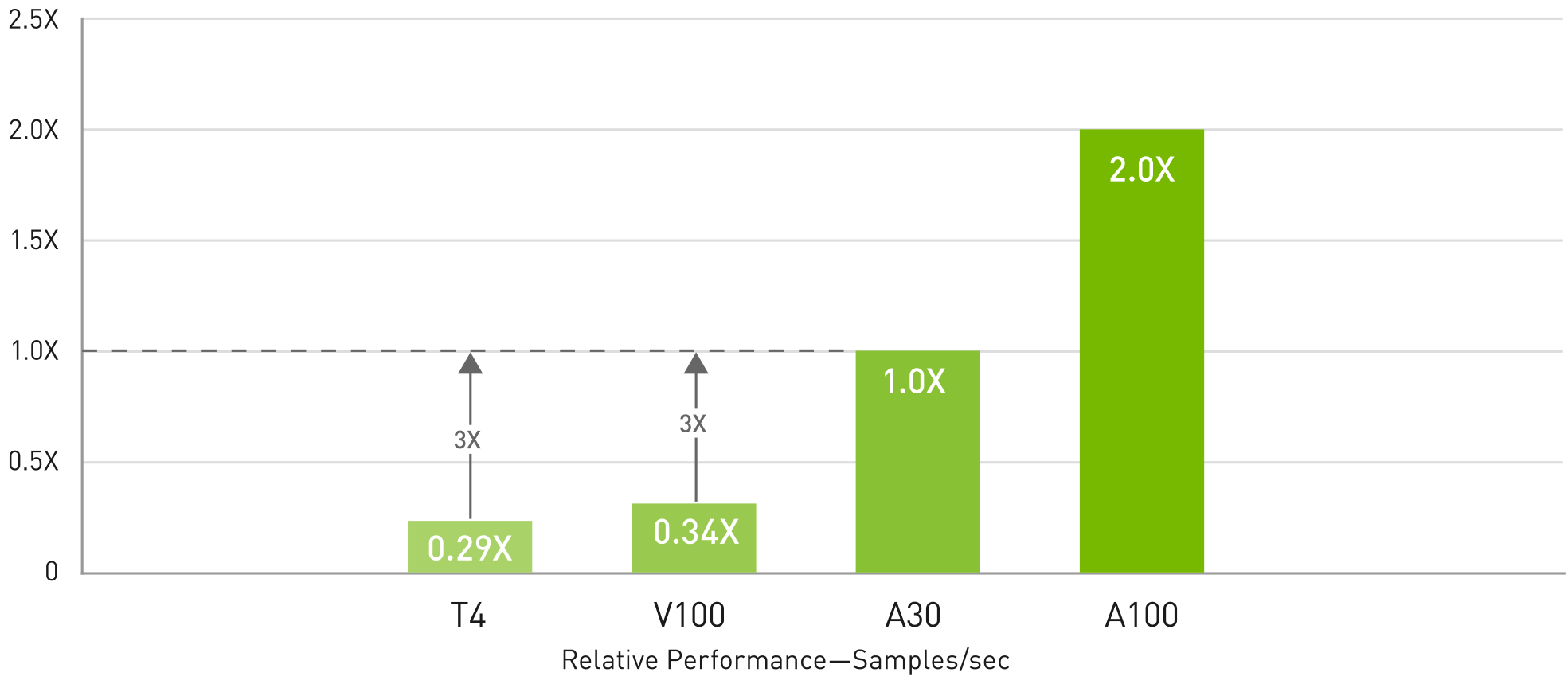

Yapay Zeka Çıkarımı—Gerçek zamanlı diyalog tabanlı yapay zekada V100’den 3 kata kadar daha yüksek verim

NVIDIA® TensorRT®, Precision = INT8, Sequence Length = 384, NGC Container 20.12, Latency <10ms, Dataset = Synthetic 1x GPU: A100 PCIe 40GB (BS=8) | A30 (BS=4) | V100 SXM2 16GB (BS=1) | T4 (BS=1)

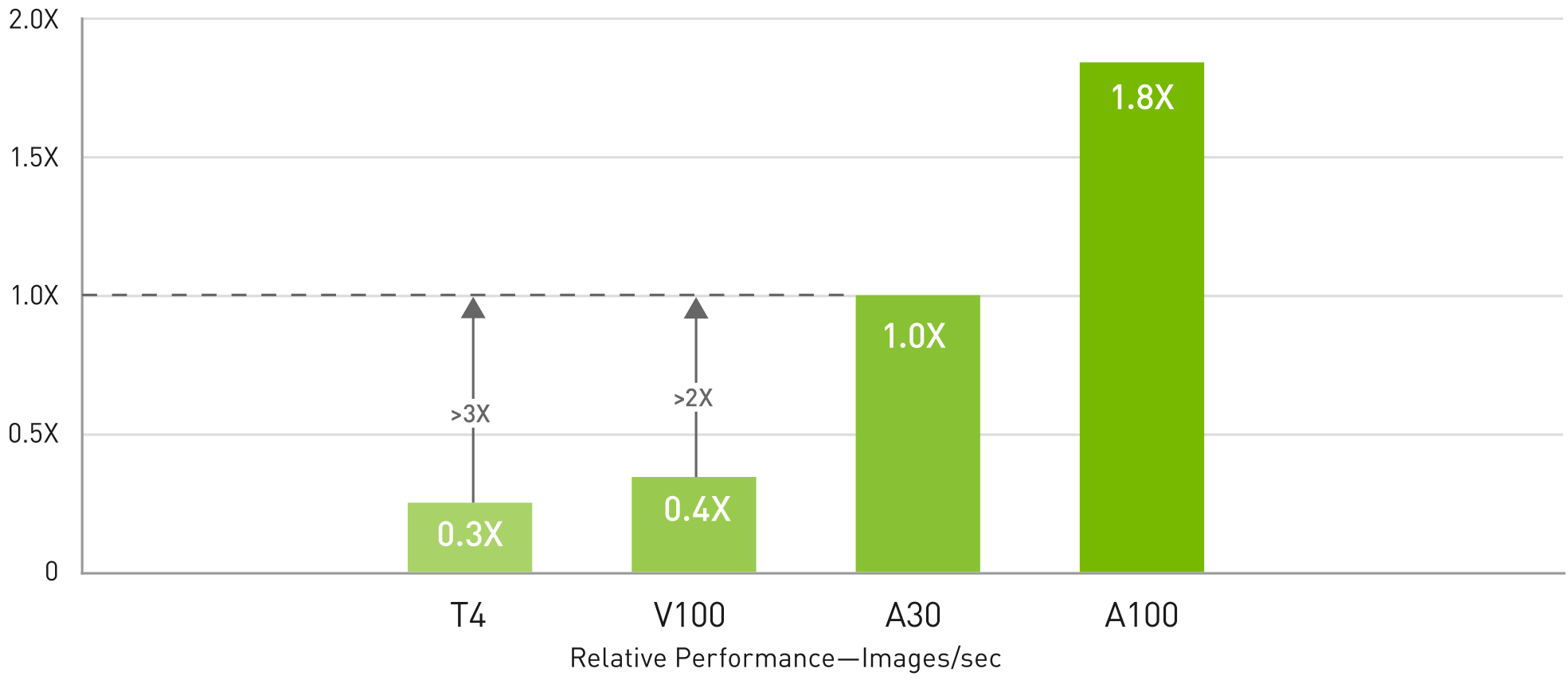

AI Inference—Gerçek zamanlı görüntü sınıflandırmasında T4’ten 3 kat daha yüksek verim

TensorRT, NGC Container 20.12, Latency <7ms, Dataset=Synthetic, 1x GPU: T4 (BS=31, INT8) | V100 (BS=43, Mixed precision) | A30 (BS=96, INT8) | A100 (BS=174, INT8)

Yüksek Performanslı Hesaplama

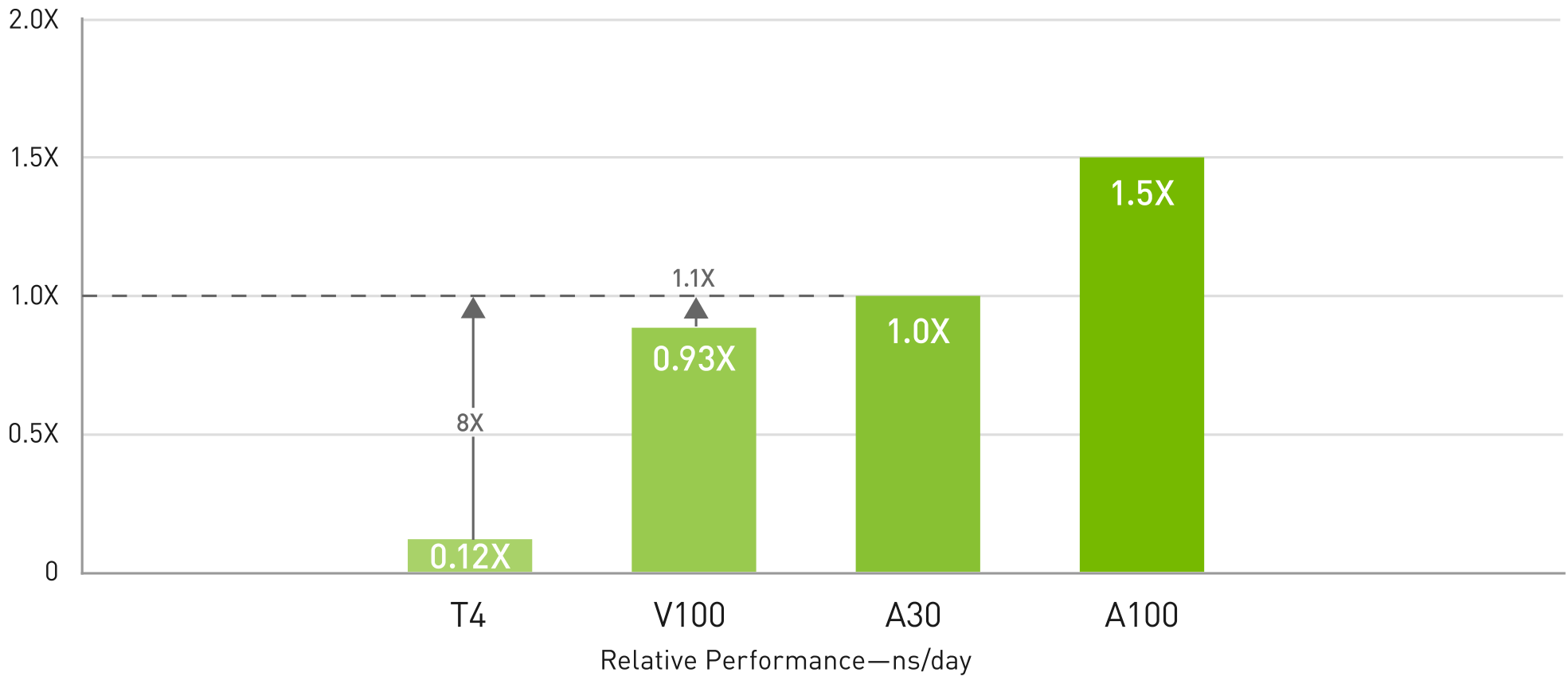

HPC—V100’e göre 1,1 kata kadar ve T4’e göre 8 kata kadar daha yüksek verim

Değerlerde değişiklik olabilir.

Llama2 70B: ISL 2K, OSL 128 | Verim | H100 1x GPU BS 8 | H200 1x GPU BS 32

Bilim insanları çevremizdeki dünyayı daha iyi anlamak amacıyla simülasyonları kullanıyor.

NVIDIA A30, GPU’ların piyasaya sürülmesinden bu yana HPC performansında en büyük sıçramayı sağlayan FP64 NVIDIA Ampere mimarisi Tensor Çekirdeklerine sahiptir. Saniyede 933 gigabayt (GB/s) bant genişliğine sahip 24 gigabayt (GB) GPU belleği ile birlikte araştırmacılar çift hassasiyetli hesaplamaları hızla çözebilir. HPC uygulamaları ayrıca tek hassasiyetli, yoğun matris çarpma işlemlerinde daha yüksek verim elde etmek için TF32’den yararlanabilir.

FP64 Tensör Çekirdekleri ve MIG kombinasyonu, araştırma kurumlarının GPU’yu güvenli bir şekilde bölümlere ayırarak birden fazla araştırmacının garantili QoS ve maksimum GPU kullanımı ile bilgi işlem kaynaklarına erişmesini sağlar. Yapay zeka kullanan kurumlar, talebin en yoğun olduğu dönemlerde A30’un çıkarım yeteneklerini kullanabilir ve ardından yoğun olmayan dönemlerde aynı bilgi işlem sunucularını HPC ve yapay zeka eğitim iş yükleri için yeniden kullanabilir.

Özellikler

| Form Faktör | A30 |

|---|---|

| FP64 | 5.2 teraFLOPS |

| FP64 Tensor Çekirdeği | 10.3 teraFLOPS |

| FP32 | 10.3 teraFLOPS |

| TF32 Tensor Çekirdeği | 82 teraFLOPS | 165 teraFLOPS |

| BFLOAT16 Tensor Çekirdeği | 165 teraFLOPS | 330 teraTFLOPS |

| FP16 Tensor Çekirdeği | 165 teraFLOPS | 330 teraTFLOPS |

| INT8 Tensor Çekirdeği | 330 TOPS | 661 TOPS |

| GPU Belleği | 24GB HBM2 |

| GPU Bellek Bant Genişliği | 933 GB/s |

| INT8 Tensor Çekirdeği | 330 TOPS | 661 TOPS |

| INT Tensor Çekirdeği | 661 TOPS | 1321 TOPS |

| Multi-Instance GPU(MIG) | 4 GPU instances @ 6GB each 2 GPU instances @ 12GB each 1 GPU instance @ 24GB |

| Form Faktörü | Çift yuvalı, tam yükseklikte, tam uzunlukta |

| Ara Bağlantı | PCIe Gen4: 64GB/s Third-gen NVLINK: 200GB/s |

| Sanal GPU Yazılım Desteği | NVIDIA AI Enterprise NVIDIA Virtual Compute Server |