En Önemli İş Yüklerinizi Hızlandırın

NVIDIA A100 Tensor Core GPU, yapay zeka, veri analitiği ve HPC için dünyanın en yüksek performanslı elastik veri merkezlerine güç sağlamak için her ölçekte benzeri görülmemiş bir hızlanma sunar. NVIDIA Ampere mimari destekli A100, NVIDIA veri merkezi platformunun itici gücüdür. A100, önceki nesle göre 20 kata kadar daha yüksek performans sağlamasının yanında değişen taleplere dinamik olarak uyum sağlamak için yedi GPU örneğine bölünebilir. 40GB ve 80GB bellek olmak üzere iki versiyonu bulunmaktadır. A100 80GB, saniyede 2 terabaytlık dünyanın en hızlı bellek bant genişliğiyle, en büyük modellerin ve veri setlerinin kolayca üstesinden gelebilir.

AI İçin Enterprise-Ready Yazılım

NVIDIA EGX™ platformu, altyapı genelinde hızlandırılmış hesaplama sağlayan optimize edilmiş bir yazılım içerir. Firmalar, NVIDIA AI Enterprise ile NVIDIA Sertifikalı Sistemlerle VMware vSphere üzerinde çalışmak üzere NVIDIA tarafından optimize edilmiş ve uçtan uca desteklenen, bulutta yerel bir AI ve veri analizi yazılımı paketine erişebilir. NVIDIA AI Enterprise, modern hibrit bulutta AI iş yüklerinin hızlı dağıtımı, yönetimi ve ölçeklenmesi için NVIDIA’nın temel etkinleştirme teknolojilerini içerir.

AI İçin Enterprise-Ready Yazılım

NVIDIA EGX™ platformu, altyapı genelinde hızlandırılmış hesaplama sağlayan optimize edilmiş bir yazılım içerir. Firmalar, NVIDIA AI Enterprise ile NVIDIA Sertifikalı Sistemlerle VMware vSphere üzerinde çalışmak üzere NVIDIA tarafından optimize edilmiş ve uçtan uca desteklenen, bulutta yerel bir AI ve veri analizi yazılımı paketine erişebilir. NVIDIA AI Enterprise, modern hibrit bulutta AI iş yüklerinin hızlı dağıtımı, yönetimi ve ölçeklenmesi için NVIDIA’nın temel etkinleştirme teknolojilerini içerir.

AI İçin Enterprise-Ready Yazılım

NVIDIA EGX™ platformu, altyapı genelinde hızlandırılmış hesaplama sağlayan optimize edilmiş bir yazılım içerir. Firmalar, NVIDIA AI Enterprise ile NVIDIA Sertifikalı Sistemlerle VMware vSphere üzerinde çalışmak üzere NVIDIA tarafından optimize edilmiş ve uçtan uca desteklenen, bulutta yerel bir AI ve veri analizi yazılımı paketine erişebilir. NVIDIA AI Enterprise, modern hibrit bulutta AI iş yüklerinin hızlı dağıtımı, yönetimi ve ölçeklenmesi için NVIDIA’nın temel etkinleştirme teknolojilerini içerir.

En Güçlü Uçtan Uca AI ve HPC Veri Merkezi Platformu

A100, donanım, ağ, yazılım, kütüphaneler ve NGC™‘nin optimize edilmiş yapay zeka modelleri ve uygulamaları genelinde yapı taşlarını bir araya getiren eksiksiz NVIDIA veri merkezi çözümünün bir parçasıdır. Veri merkezleri için en güçlü uçtan uca AI ve HPC platformununun itici gücü olarak, araştırmacıların hızlı bir şekilde sonuç elde etmesine ve çözümlerini üretime uygun ölçeklerde dağıtmasını sağlar.

DERİN ÖĞRENME EĞİTİMİ

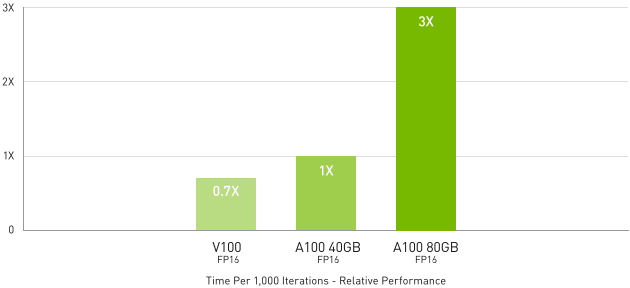

En Kompleks Modellerde 3 Kat Daha Performanslı AI Eğitimi

DLRM on HugeCTR framework, precision = FP16 | NVIDIA A100 80GB batch size = 48 | NVIDIA A100 40GB batch size = 32 | NVIDIA V100 32GB batch size = 32.

Yapay zeka modelleri, konuşma tabanlı yapay zeka gibi ileri seviye meydan okumaları çözmeye çalışırken, modellerin karmaşıklığı da giderek artıyor. Böyle ileri modellerin eğitilmesi muazzam miktarda hesaplama ve ölçeklenme kapasitesine ihtiyaç duyuyor.

Tensor Float’lı (TF32) NVIDIA A100 Tensör Çekirdekleri, kod değişikliği yapmadan, otomatik karışık hassasiyet ve FP16’ya ek 2 kat artırma ile NVIDIA Volta’ya göre 20 kata kadar daha yüksek performans sağlar. NVIDIA® NVLink®, NVIDIA NVSwitch™, PCI Gen4, NVIDIA® InfiniBand® ve NVIDIA Magnum IO™ SDK ile birleştirildiğinde, binlerce A100 GPU’ya ölçeklendirmek mümkündür.

BERT gibi bir eğitim iş yükü, 2.048 adet A100 GPU ile ölçeklendirilerek bir dakikadan daha kısa bir sürede çözülerek dünya rekoru kırıldı.

Derin öğrenme öneri modelleri (DLRM) gibi devasa veri tablolarına sahip en büyük modeller için A100 80GB, düğüm başına 1,3 TB’a kadar birleşik belleğe ulaşır ve A100 40GB’a göre 3 kata kadar verim artışı sağlar.

NVIDIA MLPerf’teki sektör genelindeki yapay zeka eğitimi için karşılaştırmalı değerlendirmede birden fazla performans rekoru kırdı.

DERİN ÖĞRENME ÇIKARIMI

A100, çıkarım iş yüklerini optimize etmek için çığır açan özelliklere sahiptir. FP32’den INT4’e kadar precision aralığını hızlandırır. Multi-Instance GPU (MIG) teknolojisi, hesaplama kaynaklarının optimum kullanımı için birden fazla ağın tek bir A100 üzerinde aynı anda çalışmasına izin verir. Yapısal seyreklik desteği, A100’ün diğer çıkarım performansı özelliklerine ek olarak 2 kata kadar daha fazla performans sunar.

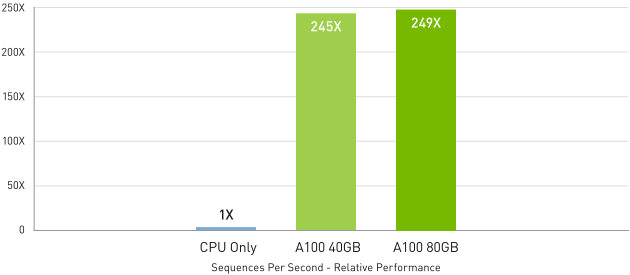

BERT gibi son teknoloji konuşma tabanlı yapay zeka modellerinde A100, çıkarım verimini CPU’lara göre 249 kata kadar hızlandırır.

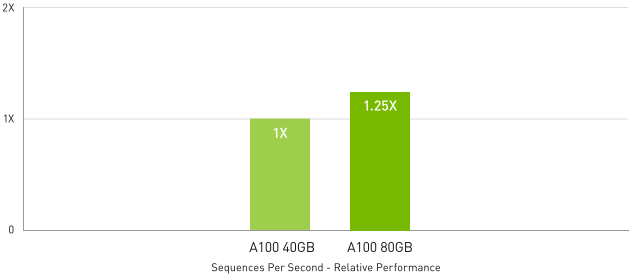

Otomatik konuşma tanıma için constrained batch size RNN-T gibi en karmaşık modellerde, artırılmış bellek kapasiteli A100 80GB’ın , her MIG parçasının boyutunu iki katına çıkarır. A100 40GB’a göre 1,25 kat daha yüksek verim sağlar.

NVIDIA’nın pazar lideri performansı MLPerf Inference‘da gösterildi. A100, bu liderliğini ileriye taşımak için 20 kat daha fazla performans getiriyor.

CPU’lara Göre 249 Kata Kadar Daha Yüksek AI Çıkarım Performansı

BERT-LARGE Çıkarımı

BERT-Large Inference | CPU only: Dual Xeon Gold 6240 @ 2.60 GHz, precision = FP32, batch size = 128 | V100: NVIDIA TensorRT™ (TRT) 7.2, precision = INT8, batch size = 256 | A100 40GB and 80GB, batch size = 256, precision = INT8 with sparsity.

A100 40GB’a göre 1,25 Kat’a Kadar Daha Yüksek AI Çıkarım Performansı

RNN-T Çıkarımı: Single Stream

MLPerf 0.7 RNN-T measured with (1/7) MIG slices. Framework: TensorRT 7.2, dataset = LibriSpeech, precision = FP16.

YÜKSEK BAŞARIMLI HESAPLAMA

Bilim insanları yeni keşifleri yapabilmek için simülasyonlar ile üstünde yaşadığımız dünyayı anlamaya çalışıyorlar.

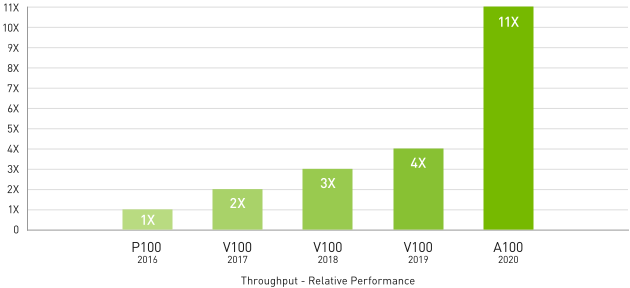

NVIDIA A100, GPU’ların piyasaya sürülmesinden bu yana HPC performansında en büyük sıçramayı sağlamak için çift hassasiyetli(double precision) Tensör Çekirdeklerini sunar. Araştırmacılar, A100 80 GB’lık en hızlı GPU belleğiyle 10 saatlik, çift duyarlıklı(double precision) simülasyonu dört saatin altına indirebilir. HPC uygulamaları, tek duyarlıklı, yoğun matris çarpma işlemleri için 11 kata kadar daha yüksek verim elde etmek için TF32’yi de kullanabilir.

En büyük veri kümelerine sahip HPC uygulamaları için, A100 80GB’nin ek belleği, Quantum Espresso simülasyonu ile 2 kata kadar çıktı artışı sağlar. Bu muazzam bellek ve benzersiz bellek bant genişliği, A100 80GB’yi yeni nesil iş yükleri için ideal platform haline getiriyor.

4 YILDA 11 KAT DAHA FAZLA HPC PERFORMANSI

En İyi HPC Uygulamaları

Geometric mean of application speedups vs. P100: Benchmark application: Amber [PME-Cellulose_NVE], Chroma [szscl21_24_128], GROMACS [ADH Dodec], MILC [Apex Medium], NAMD [stmv_nve_cuda], PyTorch (BERT-Large Fine Tuner], Quantum Espresso [AUSURF112-jR]; Random Forest FP32 [make_blobs (160000 x 64 : 10)], TensorFlow [ResNet-50], VASP 6 [Si Huge] | GPU node with dual-socket CPUs with 4x NVIDIA P100, V100, or A100 GPUs.

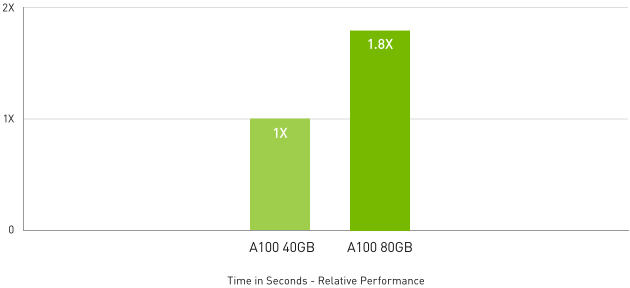

HPC Uygulamaları İçin 1.8 Kata Daha Fazla Performans

Quantum Espresso

Quantum Espresso measured using CNT10POR8 dataset, precision = FP64.

YÜKSEK PERFORMANSLI VERİ ANALİZİ

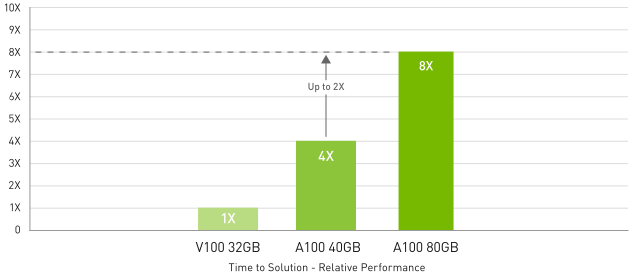

Büyük Veri Analitiği Karşılaştırmasında A100 40GB’tan 2 Kat Daha Hızlı

Big data analytics benchmark | 30 analytical retail queries, ETL, ML, NLP on 10TB dataset | V100 32GB, RAPIDS/Dask | A100 40GB and A100 80GB, RAPIDS/Dask/BlazingSQL

Veri bilimcilerinin büyük veri kümelerini, analiz edebilmesi, görselleştirebilmesi ve içgörülere dönüştürebilmelidir. Ancak ölçeği artış çözümleri genellikle birden çok sunucuya dağılmış veri kümeleri tarafından tıkanır.

A100’e sahip hızlandırılmış sunucular, bu iş yüklerinin üstesinden gelmek için yüksek bellek, 2 TB/sn’nin üzerinde bellek bant genişliği, NVIDIA® NVLink® ve NVSwitch™ ile ölçeklenebilirlik için gerekli hesaplama gücünü sağlar. NVIDIA veri merkezi platformu InfiniBand, NVIDIA Magnum IO™ ve GPU hızlandırmalı veri analizi için RAPIDS Accelerator for Apache Spark dahil olmak üzere RAPIDS™ açık kaynaklı kitaplıklar paketi ile birlikte bu iş yüklerinin benzeri görülmemiş performans ve verimle üstesinden gelir.

A100 80GB büyük veri analitiği karşılaştırmasında, A100 40GB’a göre 2 kat artışla içgörüler sunarak, veri kümesi boyutlarının inanılmaz boyutlara ulaştığı modern iş yükleri için ideal hale geldi.

ENTERPRISE-READY KULLANIMI

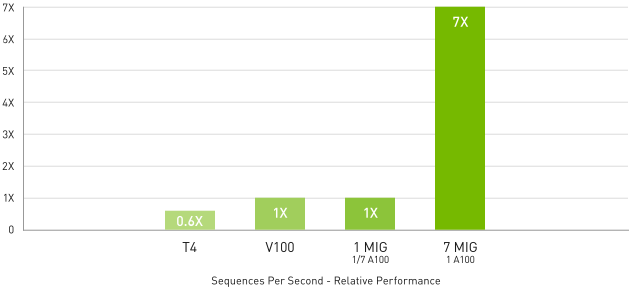

Çok Örnekli GPU (MIG) ile 7 Kat Daha Yüksek Çıkarım İşlemi

BERT Large Çıkarımı

BERT Large Inference | NVIDIA TensorRT™ (TRT) 7.1 | NVIDIA T4 Tensor Core GPU: TRT 7.1, precision = INT8, batch size = 256 | V100: TRT 7.1, precision = FP16, batch size = 256 | A100 with 1 or 7 MIG instances of 1g.5gb: batch size = 94, precision = INT8 with sparsity.

MIG destekli A100, GPU hızlandırmalı altyapının kullanımını en üst düzeye çıkarır. Bir A100 GPU, MIG ile yedi adede kadar bağımsız örneğe bölünerek birden fazla kullanıcının GPU hızlandırmasına erişmesini sağlar. Bir A100 40GB GPU’da her bir MIG örneği 5GB’a kadar, bir A100 80GB GPU’da bellek kapasitesi 2 kat artışla 10GB’a kadar tahsis edilebilir.

MIG, Kubernetes, konteynerlar ve hiper yönetici tabanlı sunucu sanallaştırma ile çalışır. MIG, altyapı yöneticilerinin her iş için garantili hizmet kalitesi (QoS) ile doğru boyutta bir GPU sunmasını sağlayarak, hızlandırılmış hesaplama kaynaklarının erişimini her kullanıcıya genişletir.

VERİ MERKEZİ GPU’LARI

HGX İçin A100

Tüm iş yükleri için maksimum performans.

HGX İçin A100

Tüm iş yükleri için maksimum performans.

PCIe İçin NVIDIA A100

Tüm iş yükleri için en yüksek çok yönlülük.

PCIe İçin NVIDIA A100

Tüm iş yükleri için en yüksek çok yönlülük.

| A100 40GB PCIe | A100 80GB PCIe | A100 40GB SXM | A100 80GB SXM | |

|---|---|---|---|---|

| FP64 | 9.7 TFLOPS | 9.7 TFLOPS | 9.7 TFLOPS | 9.7 TFLOPS |

| FP64 Tensor Core | 19.5 TFLOPS | 19.5 TFLOPS | 19.5 TFLOPS | 19.5 TFLOPS |

| Tensor Float 32 (TF32) | 156 TFLOPS | 312 TFLOPS* | 156 TFLOPS | 312 TFLOPS* | 156 TFLOPS | 312 TFLOPS* | 156 TFLOPS | 312 TFLOPS* |

| BFLOAT16 Tensor Core | 312 TFLOPS | 624 TFLOPS* | 312 TFLOPS | 624 TFLOPS* | 312 TFLOPS | 624 TFLOPS* | 312 TFLOPS | 624 TFLOPS* |

| FP16 Tensor Core | 312 TFLOPS | 624 TFLOPS* | 312 TFLOPS | 624 TFLOPS* | 312 TFLOPS | 624 TFLOPS* | 312 TFLOPS | 624 TFLOPS* |

| INT8 Tensor Core | 624 TOPS | 1248 TOPS* | 624 TOPS | 1248 TOPS* | 624 TOPS | 1248 TOPS* | 624 TOPS | 1248 TOPS* |

| GPU Memory | 40GB HBM2 | 80GB HBM2e | 40GB HBM2 | 80GB HBM2e |

| GPU Memory Bandwidth | 1,555GB/s | 1,935GB/s | 1,555GB/s | 2,039GB/s |

| Max Thermal Design Power (TDP) | 250W | 300W | 400W | 400W |

| Multi-Instance GPU | Up to 7 MIGs @ 5GB | Up to 7 MIGs @ 10GB | Up to 7 MIGs @ 5GB | Up to 7 MIGs @ 10GB |

| Form Factor | PCIe | PCIe | SXM | SXM |

| Interconnect | NVIDIA® NVLink® Bridge for 2 GPUs: 600GB/s ** PCIe Gen4: 64GB/s |

NVIDIA® NVLink® Bridge for 2 GPUs: 600GB/s ** PCIe Gen4: 64GB/s |

NVLink: 600GB/s PCIe Gen4: 64GB/s |

NVLink: 600GB/s PCIe Gen4: 64GB/s |

| Server Options | Partner and NVIDIA-Certified Systems™ with 1-8 GPUs | Partner and NVIDIA-Certified Systems™ with 1-8 GPUs | NVIDIA HGX™ A100-Partner and NVIDIA-Certified Systems with 4,8, or 16 GPUs NVIDIA DGX™ A100 with 8 GPUs |

NVIDIA HGX™ A100-Partner and NVIDIA-Certified Systems with 4,8, or 16 GPUs NVIDIA DGX™ A100 with 8 GPUs |

* With sparsity

** SXM4 GPUs via HGX A100 server boards; PCIe GPUs via NVLink Bridge for up to two GPUs