NVIDIA AMPERE MİMARİSİ

Dünyanın En Yüksek Performanslı, Elastik Veri Merkezlerinin Kalbi

NVIDIA AMPERE MİMARİSİ

Dünyanın En Yüksek Performanslı, Elastik Veri Merkezlerinin Kalbi

NVIDIA AMPERE MİMARİSİ

Dünyanın En Yüksek Performanslı, Elastik Veri Merkezlerinin Kalbi

MODERN VERİ MERKEZİNDE AI VE HPC’NİN ÇEKİRDEĞİ

Bilim insanları, araştırmacılar ve mühendisler, dünyanın en zorlu bilimsel, endüstriyel ve büyük veri meydan okumalarını, AI ve yüksek başarımlı hesaplama(HPC) ile çözmeye çalışıyor. Tasarımcıların, mühendislerin ve sanatçıların giderek karmaşıklaşan içerikleri görselleştirmeleri, son teknoloji ürünler yaratmaları, sürükleyici hikayeler anlatmaları veya geleceğin şehirlerini yeniden tasarlamaları gerekiyor. Bununla beraber şirketler de hem şirket içi hem de buluttaki devasa veri kümelerinden yeni içgörüler elde etmek için yapay zekanın gücünden yararlanmaya çalışıyor. Elastik hesaplama çağı için tasarlanan NVIDIA Ampere mimarisi, her ölçekte benzersiz hızlanma sağlayarak bir sonraki dev sıçramayı sağlıyor.

DEVRİM YARATAN YENİLİKLER

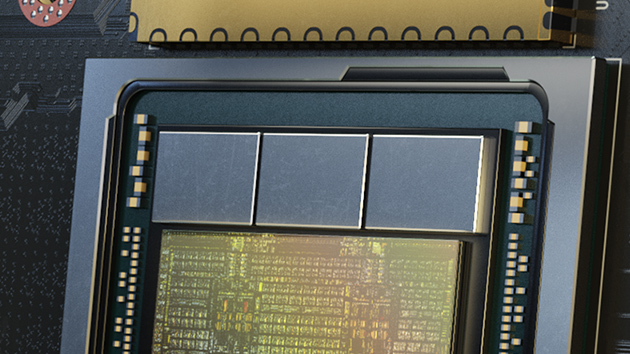

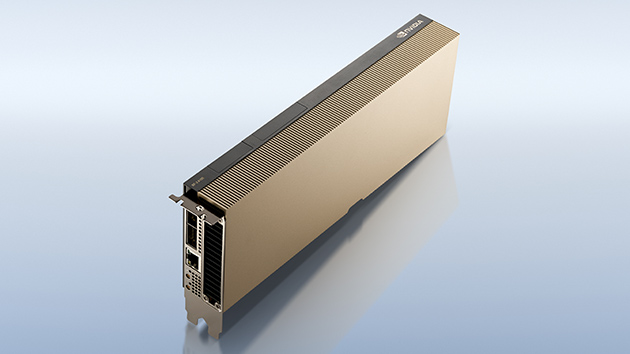

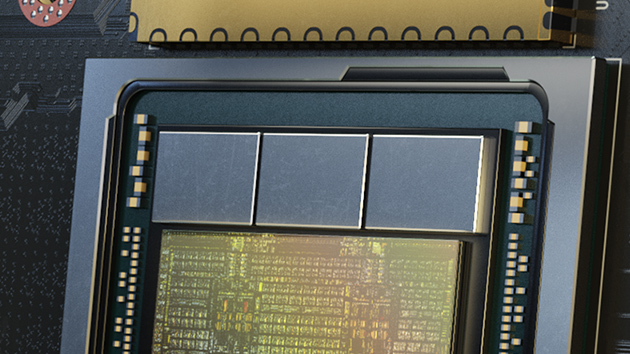

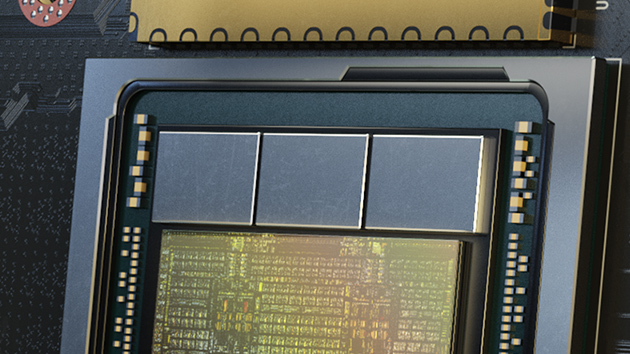

54 milyar transistörle hazırlanmış NVIDIA Ampere mimarisi, bu zamana kadar yapılmış en büyük 7 nanometrelik yongadır ve devrim yaratan altı önemli yeniliğe sahiptir.

3.Nesil Tensor Çekirdekleri

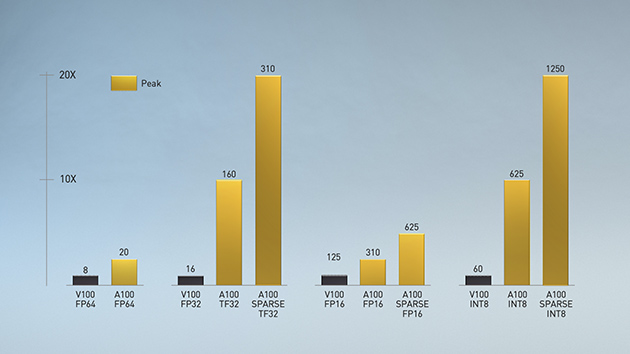

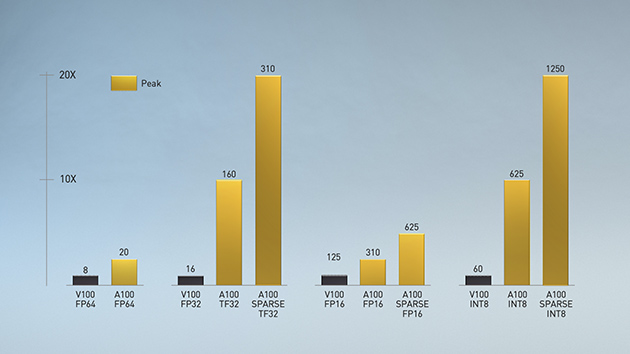

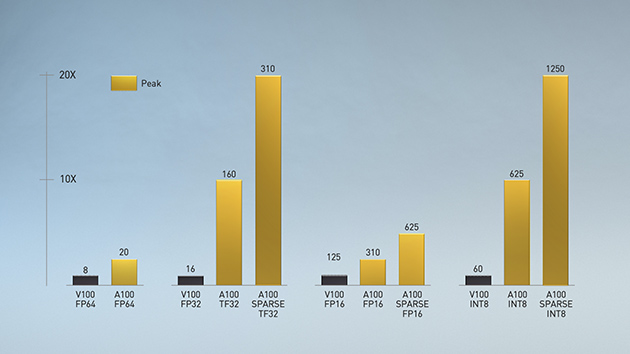

İlk olarak NVIDIA Volta™ mimarisinde tanıtılan NVIDIA Tensor Core teknolojisi, yapay zekaya önemli miktarda hızlanma sağlayarak eğitim sürelerini haftalardan saatlere indirirken çıkarım için muazzam bir performans sağladı. NVIDIA Ampere mimarisi, yapay zekanın fark edilmesini sağlamak, basitleştirmek ve Tensor Çekirdeklerinin gücünü HPC’ye genişletmek için Tensor Float 32 (TF32) ve floating point 64 (FP64) gibi yeni yaklaşımlar getirerek bu yeniliklerin üzerine inşa edilmiştir.

TF32, herhangi bir kod değişikliği gerektirmeden AI için 20 kata kadar hızlanma sağlarken, FP32 gibi çalışır. Araştırmacılar, yalnızca birkaç satır kod ekleyerek NVIDIA Automatic Mixed Precision kullanarak ve FP16 ile ek 2 kat performans elde edebilirler. NVIDIA Ampere mimarili ve Tensor Çekirdekleri Tensor Core GPU’ları, Bfloat16, INT8 ve INT4 desteği ile hem AI eğitimi hem de çıkarım için çok yönlü bir hızlandırıcı oluşturur. Tensör Çekirdeklerinin gücünü HPC, A100 ve A30 GPU’lara getirmek, matris işlemlerini IEEE sertifikalı, FP64 hassasiyetiyle yapmasına olanak tanır.

Multi-Instance GPU(MIG)

Her AI ve HPC uygulaması, hızlandırmanın avantajlarını kullanabilir fakat her uygulama çalışmak için GPU’nun bütün gücüne ihtiyaç duymaz. Multi-Instance GPU(MIG), A100 ve A30 GPU’larında desteklenen, iş yüklerinin GPU’yu paylaşabilme özelliğidir. MIG ile her bir GPU, kendi yüksek bant genişliğine sahip bellek, önbellek ve hesaplama çekirdekleriyle donanım düzeyinde tamamen izole edilmiş ve güvence altına alınmış birden çok GPU örneğine bölünebilir. Geliştiriciler, uygulamalarının ihtiyacına göre devrimsel boyutta hızlandırmayı kullanabilir ve garantili hizmet kalitesi elde edebilir. BT yöneticileri, gücün optimum kullanımı için uygulamaya ihtiyacı kadar GPU hızlandırması sunarak hem yalın hem de sanallaştırılmış ortamlarda her kullanıcıya ve uygulamaya erişimi genişletebilir.

YAPISAL SEYREKLİK

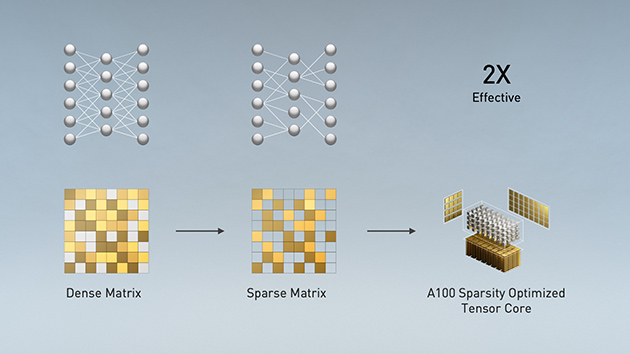

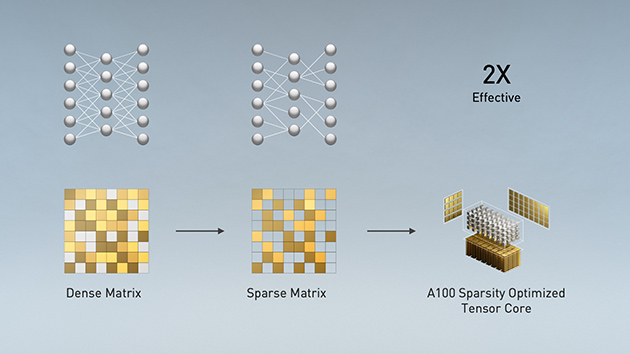

Modern AI ağları, milyonlarca hatta milyarca parametreyle büyümeye devam ediyor. Doğru tahminler ve çıkarım için bu parametrelerin tümü gerekli değildir. Bu yüzden gerekli olmayan parametreler, modelleri doğruluktan ödün vermeden seyrek hale getirmek için sıfırlara dönüştürülebilir.

Tensor çekirdekleri, model seyrekleştirmede 2 kat daha yüksek performans gösterir. Seyreklik özelliği AI çıkarımını kolaylaştırmasıyla beraber, model eğitiminin performansını artırmak için de kullanılabilir.

3.Nesil NVLink

Çoklu GPU’lu kullanılan sistemlerde uygulama ölçeklendirmek için GPU’lar arası veri aktarımının çok yüksek hızda olması gerekir. NVIDIA Ampere mimarisindeki üçüncü nesil NVIDIA® NVLink®, GPU’dan GPU’ya doğrudan bant genişliğini ikiye katlayarak saniyede 600 gigabyte’a (GB/sn) ulaştırdı. PCIe Gen4’ten neredeyse 10 kat daha yüksek bir değer. Sunucudaki tüm GPU’lar yeni nesil NVIDIA NVSwitch™ ile eşleştirildiğinde, tam NVLink hızında veri aktarımı yapabilir.

NVIDIA DGX™A100 ve diğer önde gelen bilgisayar üreticilerinin sunucuları, HPC ve AI iş yüklerinde daha fazla ölçeklenebilirlik sağlamak için NVIDIA HGX™ A100 temel kartları aracılığıyla NVLink ve NVSwitch teknolojisinden yararlanıyor.

2.Nesil RT Çekirdekleri

NVIDIA A40 ve A10 GPU’lardaki NVIDIA Ampere mimarisinin ikinci nesil RT Çekirdekleri, film içeriklerinin fotogerçekçi render alınması, mimari tasarım değerlendirmeleri ve ürün tasarımlarının sanal prototiplenmesi gibi iş yükleri için muazzam hızlanmalar sağlar. RT Çekirdekleri ayrıca daha yüksek görsel doğrulukla daha hızlı sonuçlar için ışın izlemeli hareket bulanıklığının oluşturulmasını hızlandırır ve aynı anda hem gölgeleme hem de gürültü giderme yetenekleriyle ışın izlemeyi çalıştırır.

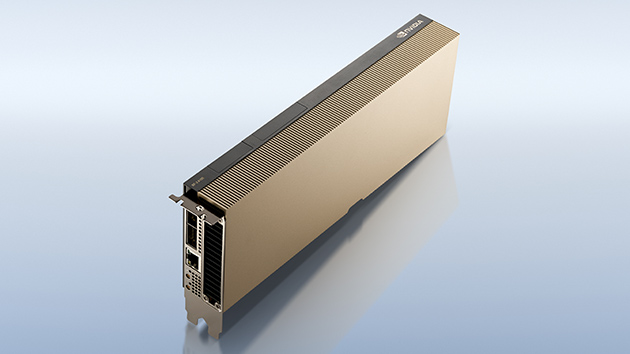

Daha Akıllı ve Hızlı Bellek

A100, veri merkezlerine devasa hesaplama kabiliyeti sunar. Bu hesaplama motorlarının tam olarak kullanılabilmesi için sınfının lideri 2 terabayt/saniye (TB/sn) bellek bant genişliğine sahiptir. Bu önceki neslin iki katından fazla bir değer. Bununla beraber A100, işlem performansını en üst düzeye çıkarmak için önceki nesilden 7 kat daha fazla olan 40 megabayt (MB) düzey 2 önbellek dahil olmak üzere önemli ölçüde daha fazla çip üzerinde belleğe sahiptir.

Uçta Yakınsanmış Hızlandırma

NVIDIA yakınsanmış hızlandırıcılarda NVIDIA Ampere mimarisi ve NVIDIA BlueField®-2 veri işleme biriminin (DPU) birleşimi, veri merkezinde ve uçta üretilen devasa miktarda veriyi işlemek için benzeri görülmemiş hesaplama gücü ve ağ hızlandırma sağlar. BlueField-2, yazılım tanımlı depolama, ağ oluşturma, güvenlik ve yönetim iş yükleri için NVIDIA ConnectX®-6 Dx’in gücünü programlanabilir Arm çekirdekleri ve donanım offload ile birleştirir. Kullanıcılar, NVIDIA yakınsanmış hızlandırıcılar ile yoğun verili uç ve veri merkezi iş yüklerini maksimum güvenlik ve performansta kullanabilir.

Yoğunluk Optimizasyonlu Tasarım

NVIDIA A16 GPU, kullanıcı yoğunluğu için optimize edilmiş ve NVIDIA Virtual PC (vPC) yazılımıyla birlikte, grafik açısından zengin sanal bilgisayarların her yerden erişilebilir olmasını sağlayan dörtlü GPU kartı tasarımıyla gelir. NVIDIA A16 ile artırılmış kare hızı ve sadece CPU ile çalışan VDI’ye kıyasla daha düşük son kullanıcı gecikmesi sunarak daha hızlı yanıt veren uygulamalar ve yerel bir bilgisayardan ayırt edilemeyen bir kullanıcı deneyimi elde edin.

DEVRİM YARATAN YENİLİKLER

54 milyar transistörle hazırlanmış NVIDIA Ampere mimarisi, bu zamana kadar yapılmış en büyük 7 nanometrelik yongadır ve devrim yaratan altı önemli yeniliğe sahiptir.

3.Nesil Tensor Çekirdekleri

İlk olarak NVIDIA Volta™ mimarisinde tanıtılan NVIDIA Tensor Core teknolojisi, yapay zekaya önemli miktarda hızlanma sağlayarak eğitim sürelerini haftalardan saatlere indirirken çıkarım için muazzam bir performans sağladı. NVIDIA Ampere mimarisi, yapay zekanın fark edilmesini sağlamak, basitleştirmek ve Tensor Çekirdeklerinin gücünü HPC’ye genişletmek için Tensor Float 32 (TF32) ve floating point 64 (FP64) gibi yeni yaklaşımlar getirerek bu yeniliklerin üzerine inşa edilmiştir.

TF32, herhangi bir kod değişikliği gerektirmeden AI için 20 kata kadar hızlanma sağlarken, FP32 gibi çalışır. Araştırmacılar, yalnızca birkaç satır kod ekleyerek NVIDIA Automatic Mixed Precision kullanarak ve FP16 ile ek 2 kat performans elde edebilirler. NVIDIA Ampere mimarili ve Tensor Çekirdekleri Tensor Core GPU’ları, Bfloat16, INT8 ve INT4 desteği ile hem AI eğitimi hem de çıkarım için çok yönlü bir hızlandırıcı oluşturur. Tensör Çekirdeklerinin gücünü HPC, A100 ve A30 GPU’lara getirmek, matris işlemlerini IEEE sertifikalı, FP64 hassasiyetiyle yapmasına olanak tanır.

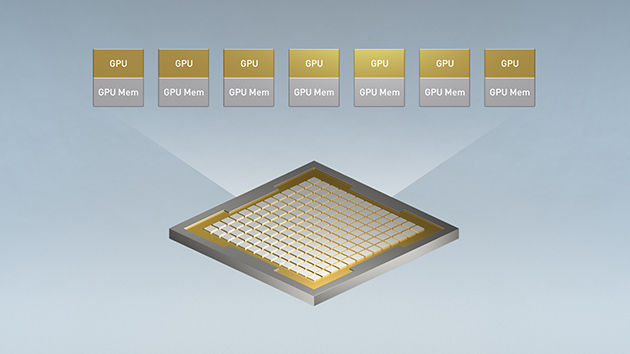

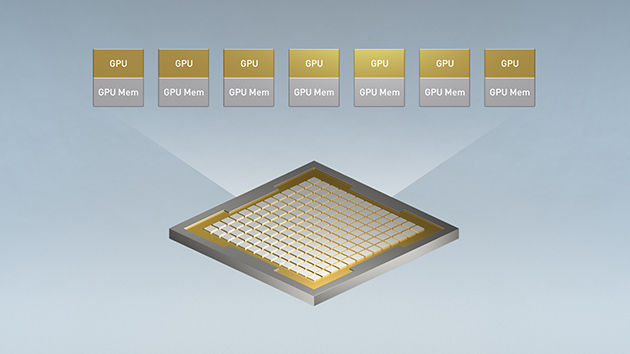

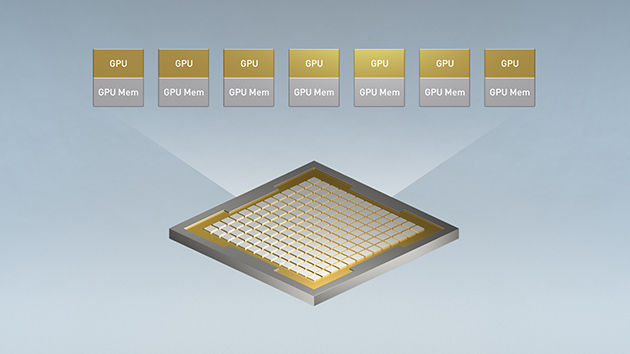

Multi-Instance GPU(MIG)

Her AI ve HPC uygulaması, hızlandırmanın avantajlarını kullanabilir fakat her uygulama çalışmak için GPU’nun bütün gücüne ihtiyaç duymaz. Multi-Instance GPU(MIG), A100 ve A30 GPU’larında desteklenen, iş yüklerinin GPU’yu paylaşabilme özelliğidir. MIG ile her bir GPU, kendi yüksek bant genişliğine sahip bellek, önbellek ve hesaplama çekirdekleriyle donanım düzeyinde tamamen izole edilmiş ve güvence altına alınmış birden çok GPU örneğine bölünebilir. Geliştiriciler, uygulamalarının ihtiyacına göre devrimsel boyutta hızlandırmayı kullanabilir ve garantili hizmet kalitesi elde edebilir. BT yöneticileri, gücün optimum kullanımı için uygulamaya ihtiyacı kadar GPU hızlandırması sunarak hem yalın hem de sanallaştırılmış ortamlarda her kullanıcıya ve uygulamaya erişimi genişletebilir.

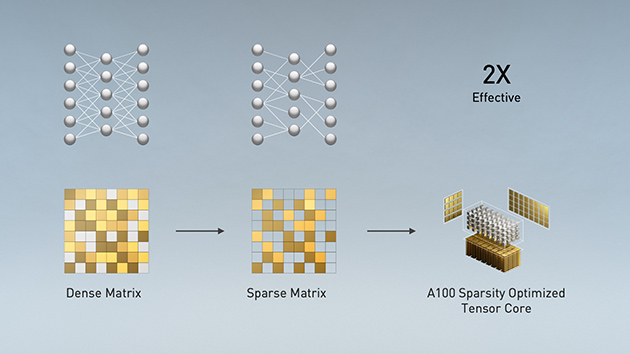

YAPISAL SEYREKLİK

Modern AI ağları, milyonlarca hatta milyarca parametreyle büyümeye devam ediyor. Doğru tahminler ve çıkarım için bu parametrelerin tümü gerekli değildir. Bu yüzden gerekli olmayan parametreler, modelleri doğruluktan ödün vermeden seyrek hale getirmek için sıfırlara dönüştürülebilir.

Tensor çekirdekleri, model seyrekleştirmede 2 kat daha yüksek performans gösterir. Seyreklik özelliği AI çıkarımını kolaylaştırmasıyla beraber, model eğitiminin performansını artırmak için de kullanılabilir.

3.Nesil NVLink

Çoklu GPU’lu kullanılan sistemlerde uygulama ölçeklendirmek için GPU’lar arası veri aktarımının çok yüksek hızda olması gerekir. NVIDIA Ampere mimarisindeki üçüncü nesil NVIDIA® NVLink®, GPU’dan GPU’ya doğrudan bant genişliğini ikiye katlayarak saniyede 600 gigabyte’a (GB/sn) ulaştırdı. PCIe Gen4’ten neredeyse 10 kat daha yüksek bir değer. Sunucudaki tüm GPU’lar yeni nesil NVIDIA NVSwitch™ ile eşleştirildiğinde, tam NVLink hızında veri aktarımı yapabilir.

NVIDIA DGX™A100 ve diğer önde gelen bilgisayar üreticilerinin sunucuları, HPC ve AI iş yüklerinde daha fazla ölçeklenebilirlik sağlamak için NVIDIA HGX™ A100 temel kartları aracılığıyla NVLink ve NVSwitch teknolojisinden yararlanıyor.

2.Nesil RT Çekirdekleri

NVIDIA A40 ve A10 GPU’lardaki NVIDIA Ampere mimarisinin ikinci nesil RT Çekirdekleri, film içeriklerinin fotogerçekçi render alınması, mimari tasarım değerlendirmeleri ve ürün tasarımlarının sanal prototiplenmesi gibi iş yükleri için muazzam hızlanmalar sağlar. RT Çekirdekleri ayrıca daha yüksek görsel doğrulukla daha hızlı sonuçlar için ışın izlemeli hareket bulanıklığının oluşturulmasını hızlandırır ve aynı anda hem gölgeleme hem de gürültü giderme yetenekleriyle ışın izlemeyi çalıştırır.

Daha Akıllı ve Hızlı Bellek

A100, veri merkezlerine devasa hesaplama kabiliyeti sunar. Bu hesaplama motorlarının tam olarak kullanılabilmesi için sınfının lideri 2 terabayt/saniye (TB/sn) bellek bant genişliğine sahiptir. Bu önceki neslin iki katından fazla bir değer. Bununla beraber A100, işlem performansını en üst düzeye çıkarmak için önceki nesilden 7 kat daha fazla olan 40 megabayt (MB) düzey 2 önbellek dahil olmak üzere önemli ölçüde daha fazla çip üzerinde belleğe sahiptir.

Uçta Yakınsanmış Hızlandırma

NVIDIA yakınsanmış hızlandırıcılarda NVIDIA Ampere mimarisi ve NVIDIA BlueField®-2 veri işleme biriminin (DPU) birleşimi, veri merkezinde ve uçta üretilen devasa miktarda veriyi işlemek için benzeri görülmemiş hesaplama gücü ve ağ hızlandırma sağlar. BlueField-2, yazılım tanımlı depolama, ağ oluşturma, güvenlik ve yönetim iş yükleri için NVIDIA ConnectX®-6 Dx’in gücünü programlanabilir Arm çekirdekleri ve donanım offload ile birleştirir. Kullanıcılar, NVIDIA yakınsanmış hızlandırıcılar ile yoğun verili uç ve veri merkezi iş yüklerini maksimum güvenlik ve performansta kullanabilir.

Yoğunluk Optimizasyonlu Tasarım

NVIDIA A16 GPU, kullanıcı yoğunluğu için optimize edilmiş ve NVIDIA Virtual PC (vPC) yazılımıyla birlikte, grafik açısından zengin sanal bilgisayarların her yerden erişilebilir olmasını sağlayan dörtlü GPU kartı tasarımıyla gelir. NVIDIA A16 ile artırılmış kare hızı ve sadece CPU ile çalışan VDI’ye kıyasla daha düşük son kullanıcı gecikmesi sunarak daha hızlı yanıt veren uygulamalar ve yerel bir bilgisayardan ayırt edilemeyen bir kullanıcı deneyimi elde edin.

DEVRİM YARATAN YENİLİKLER

54 milyar transistörle hazırlanmış NVIDIA Ampere mimarisi, bu zamana kadar yapılmış en büyük 7 nanometrelik yongadır ve devrim yaratan altı önemli yeniliğe sahiptir.

3.Nesil Tensor Çekirdekleri

İlk olarak NVIDIA Volta™ mimarisinde tanıtılan NVIDIA Tensor Core teknolojisi, yapay zekaya önemli miktarda hızlanma sağlayarak eğitim sürelerini haftalardan saatlere indirirken çıkarım için muazzam bir performans sağladı. NVIDIA Ampere mimarisi, yapay zekanın fark edilmesini sağlamak, basitleştirmek ve Tensor Çekirdeklerinin gücünü HPC’ye genişletmek için Tensor Float 32 (TF32) ve floating point 64 (FP64) gibi yeni yaklaşımlar getirerek bu yeniliklerin üzerine inşa edilmiştir.

TF32, herhangi bir kod değişikliği gerektirmeden AI için 20 kata kadar hızlanma sağlarken, FP32 gibi çalışır. Araştırmacılar, yalnızca birkaç satır kod ekleyerek NVIDIA Automatic Mixed Precision kullanarak ve FP16 ile ek 2 kat performans elde edebilirler. NVIDIA Ampere mimarili ve Tensor Çekirdekleri Tensor Core GPU’ları, Bfloat16, INT8 ve INT4 desteği ile hem AI eğitimi hem de çıkarım için çok yönlü bir hızlandırıcı oluşturur. Tensör Çekirdeklerinin gücünü HPC, A100 ve A30 GPU’lara getirmek, matris işlemlerini IEEE sertifikalı, FP64 hassasiyetiyle yapmasına olanak tanır.

Multi-Instance GPU(MIG)

Her AI ve HPC uygulaması, hızlandırmanın avantajlarını kullanabilir fakat her uygulama çalışmak için GPU’nun bütün gücüne ihtiyaç duymaz. Multi-Instance GPU(MIG), A100 ve A30 GPU’larında desteklenen, iş yüklerinin GPU’yu paylaşabilme özelliğidir. MIG ile her bir GPU, kendi yüksek bant genişliğine sahip bellek, önbellek ve hesaplama çekirdekleriyle donanım düzeyinde tamamen izole edilmiş ve güvence altına alınmış birden çok GPU örneğine bölünebilir. Geliştiriciler, uygulamalarının ihtiyacına göre devrimsel boyutta hızlandırmayı kullanabilir ve garantili hizmet kalitesi elde edebilir. BT yöneticileri, gücün optimum kullanımı için uygulamaya ihtiyacı kadar GPU hızlandırması sunarak hem yalın hem de sanallaştırılmış ortamlarda her kullanıcıya ve uygulamaya erişimi genişletebilir.

YAPISAL SEYREKLİK

Modern AI ağları, milyonlarca hatta milyarca parametreyle büyümeye devam ediyor. Doğru tahminler ve çıkarım için bu parametrelerin tümü gerekli değildir. Bu yüzden gerekli olmayan parametreler, modelleri doğruluktan ödün vermeden seyrek hale getirmek için sıfırlara dönüştürülebilir.

Tensor çekirdekleri, model seyrekleştirmede 2 kat daha yüksek performans gösterir. Seyreklik özelliği AI çıkarımını kolaylaştırmasıyla beraber, model eğitiminin performansını artırmak için de kullanılabilir.

3.Nesil NVLink

Çoklu GPU’lu kullanılan sistemlerde uygulama ölçeklendirmek için GPU’lar arası veri aktarımının çok yüksek hızda olması gerekir. NVIDIA Ampere mimarisindeki üçüncü nesil NVIDIA® NVLink®, GPU’dan GPU’ya doğrudan bant genişliğini ikiye katlayarak saniyede 600 gigabyte’a (GB/sn) ulaştırdı. PCIe Gen4’ten neredeyse 10 kat daha yüksek bir değer. Sunucudaki tüm GPU’lar yeni nesil NVIDIA NVSwitch™ ile eşleştirildiğinde, tam NVLink hızında veri aktarımı yapabilir.

NVIDIA DGX™A100 ve diğer önde gelen bilgisayar üreticilerinin sunucuları, HPC ve AI iş yüklerinde daha fazla ölçeklenebilirlik sağlamak için NVIDIA HGX™ A100 temel kartları aracılığıyla NVLink ve NVSwitch teknolojisinden yararlanıyor.

2.Nesil RT Çekirdekleri

NVIDIA A40 ve A10 GPU’lardaki NVIDIA Ampere mimarisinin ikinci nesil RT Çekirdekleri, film içeriklerinin fotogerçekçi render alınması, mimari tasarım değerlendirmeleri ve ürün tasarımlarının sanal prototiplenmesi gibi iş yükleri için muazzam hızlanmalar sağlar. RT Çekirdekleri ayrıca daha yüksek görsel doğrulukla daha hızlı sonuçlar için ışın izlemeli hareket bulanıklığının oluşturulmasını hızlandırır ve aynı anda hem gölgeleme hem de gürültü giderme yetenekleriyle ışın izlemeyi çalıştırır.

Daha Akıllı ve Hızlı Bellek

A100, veri merkezlerine devasa hesaplama kabiliyeti sunar. Bu hesaplama motorlarının tam olarak kullanılabilmesi için sınfının lideri 2 terabayt/saniye (TB/sn) bellek bant genişliğine sahiptir. Bu önceki neslin iki katından fazla bir değer. Bununla beraber A100, işlem performansını en üst düzeye çıkarmak için önceki nesilden 7 kat daha fazla olan 40 megabayt (MB) düzey 2 önbellek dahil olmak üzere önemli ölçüde daha fazla çip üzerinde belleğe sahiptir.

Uçta Yakınsanmış Hızlandırma

NVIDIA yakınsanmış hızlandırıcılarda NVIDIA Ampere mimarisi ve NVIDIA BlueField®-2 veri işleme biriminin (DPU) birleşimi, veri merkezinde ve uçta üretilen devasa miktarda veriyi işlemek için benzeri görülmemiş hesaplama gücü ve ağ hızlandırma sağlar. BlueField-2, yazılım tanımlı depolama, ağ oluşturma, güvenlik ve yönetim iş yükleri için NVIDIA ConnectX®-6 Dx’in gücünü programlanabilir Arm çekirdekleri ve donanım offload ile birleştirir. Kullanıcılar, NVIDIA yakınsanmış hızlandırıcılar ile yoğun verili uç ve veri merkezi iş yüklerini maksimum güvenlik ve performansta kullanabilir.

Yoğunluk Optimizasyonlu Tasarım

NVIDIA A16 GPU, kullanıcı yoğunluğu için optimize edilmiş ve NVIDIA Virtual PC (vPC) yazılımıyla birlikte, grafik açısından zengin sanal bilgisayarların her yerden erişilebilir olmasını sağlayan dörtlü GPU kartı tasarımıyla gelir. NVIDIA A16 ile artırılmış kare hızı ve sadece CPU ile çalışan VDI’ye kıyasla daha düşük son kullanıcı gecikmesi sunarak daha hızlı yanıt veren uygulamalar ve yerel bir bilgisayardan ayırt edilemeyen bir kullanıcı deneyimi elde edin.