Gerçek Zamanlı Trilyon Parametreli Modellerin Kilidini Açma

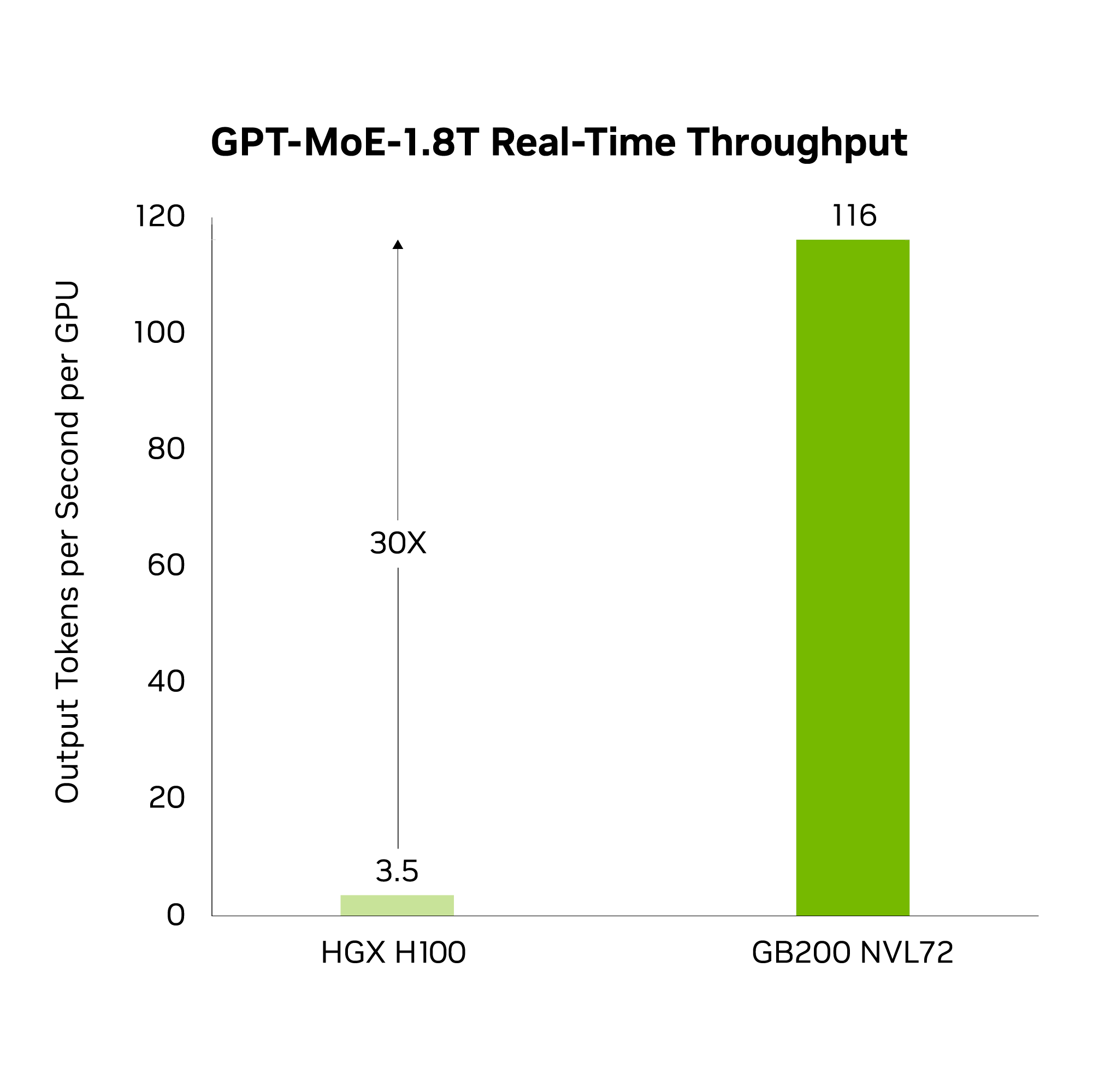

GB200 NVL72, raf ölçekli bir tasarımda 36 Grace CPU ve 72 Blackwell GPU’yu birleştirir. GB200 NVL72, sıvı soğutmalı, raf ölçekli bir çözüm olup, tek bir devasa GPU gibi çalışan 72 GPU’luk bir NVLink alanı sunar ve gerçek zamanlı trilyon parametreli büyük dil modeli çıkarımını 30 kat daha hızlı gerçekleştirir.

NVIDIA GB200 NVL72’nin ana bileşeni olan GB200 Grace Blackwell Süperçipi, iki yüksek performanslı NVIDIA Blackwell Tensor Core GPU ve bir NVIDIA Grace CPU’yu, iki Blackwell GPU’ya bağlamak için NVIDIA NVLink-C2C ara bağlantısını kullanarak birleştirir.

Üst Düzey Performansı Deneyimleyin

LLM Çıkarımı

30X

vs. NVIDIA H100 Tensor Core GPU

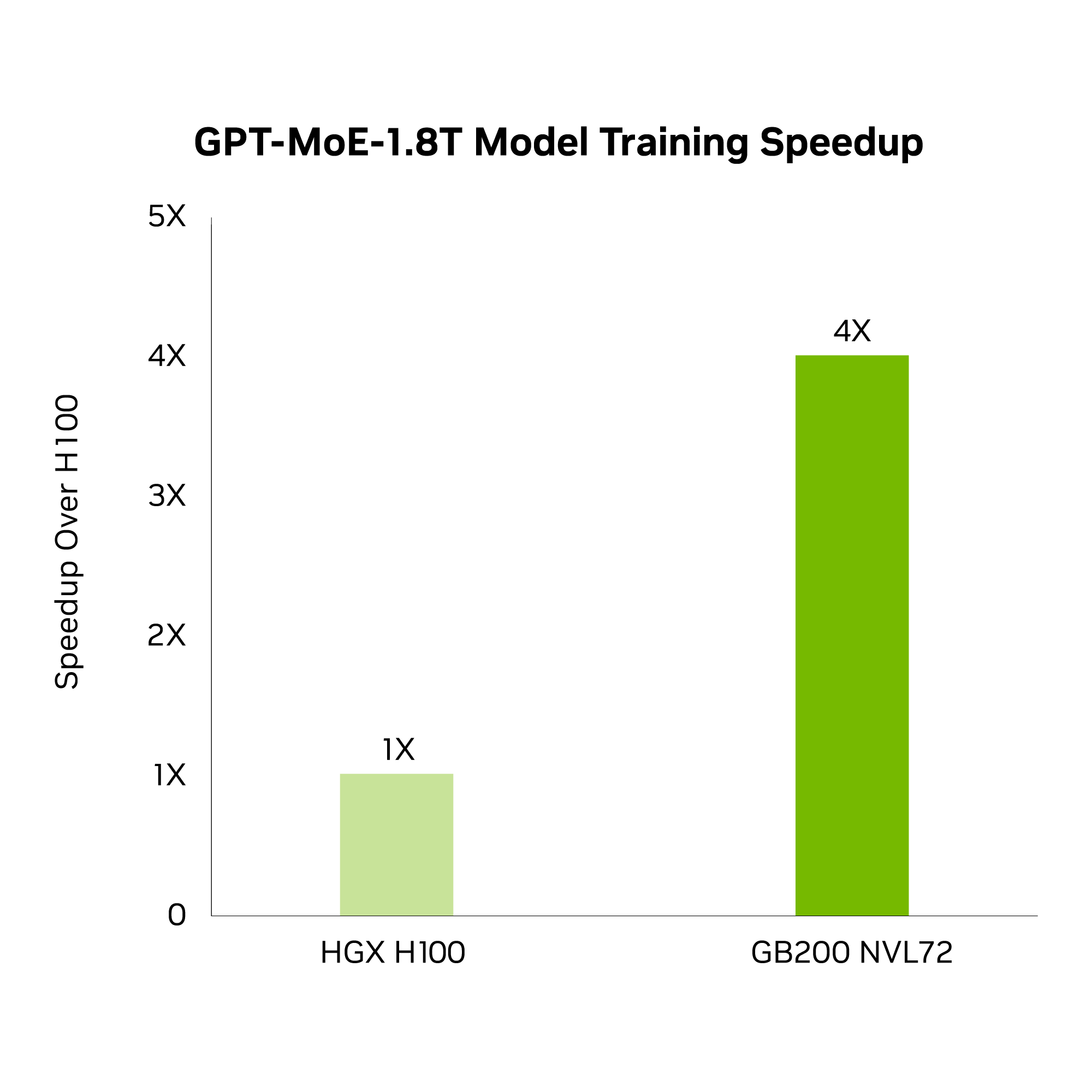

LLM Eğitimi

4X

vs. H100

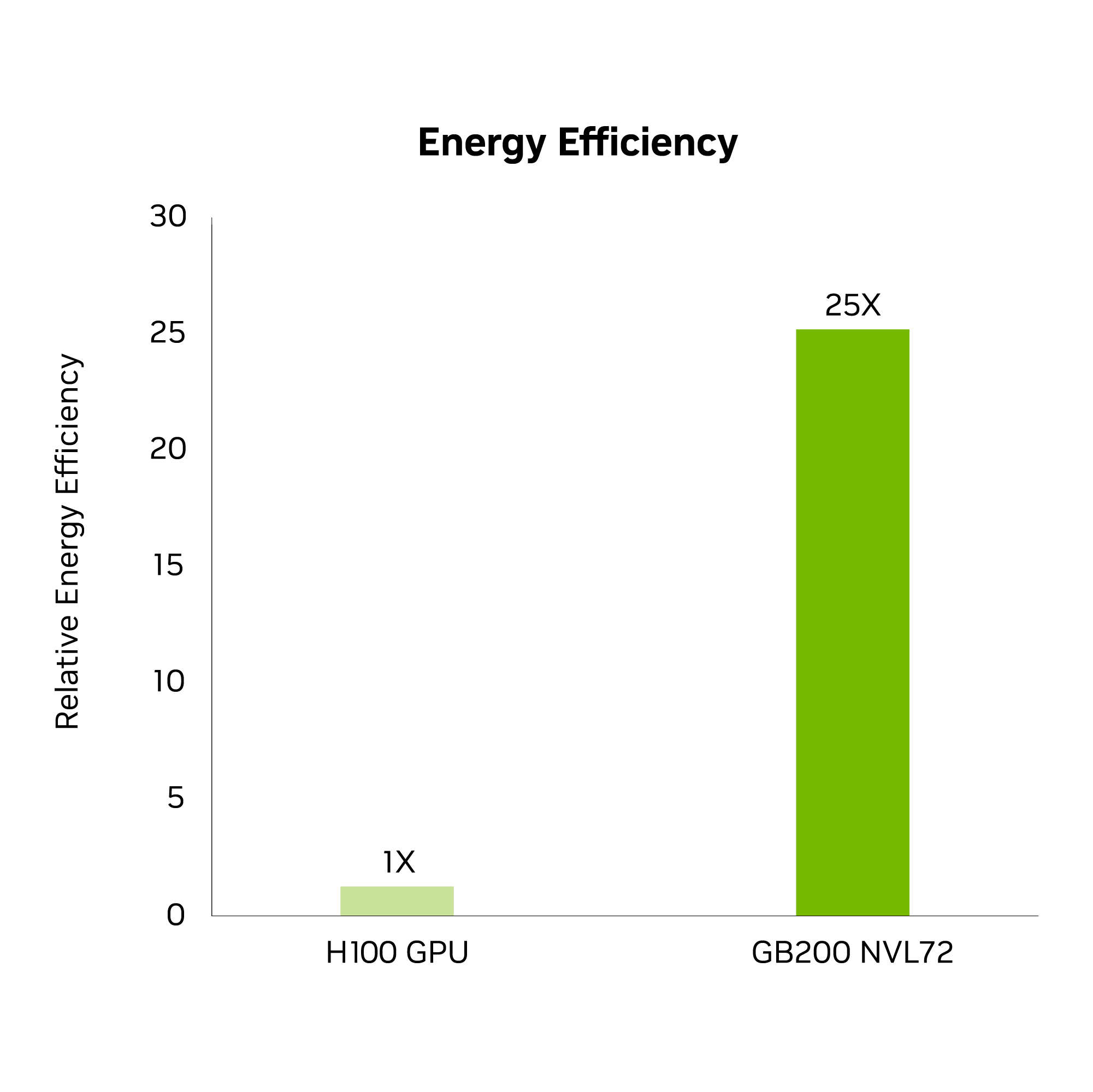

Enerji Verimliliği

25X

vs.H100

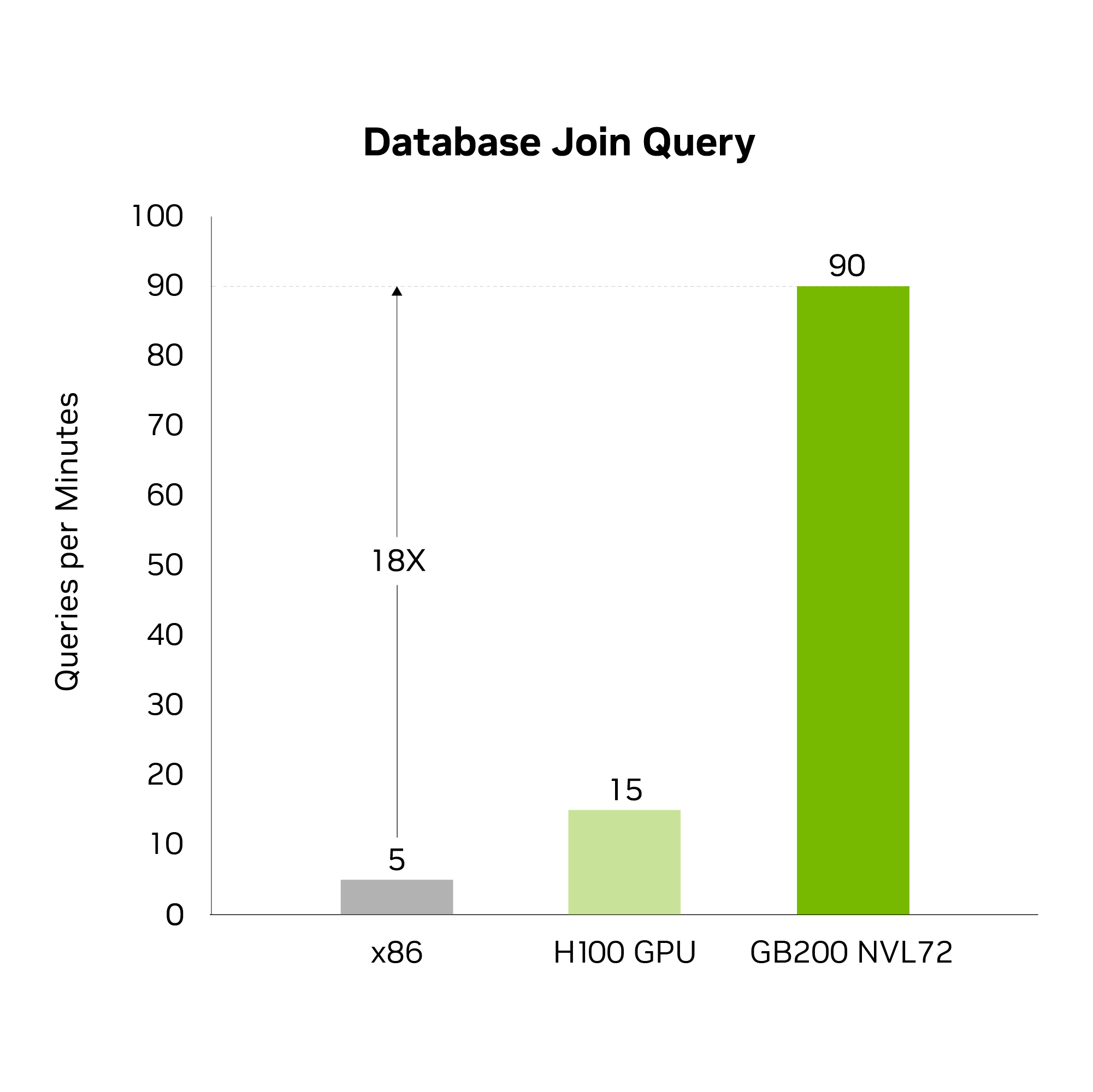

Veri İşleme

18X

vs. CPU

Gerçek Zamanlı LLM Çıkarımı

GB200 NVL72, en son nesil Transformer Motoru ile yenilikçi yetenekler sunar ve FP4 AI’yi etkinleştirir. Beşinci nesil NVIDIA NVLink ile birleştiğinde, trilyon parametreli dil modelleri için gerçek zamanlı LLM çıkarımı performansını 30 kat daha hızlı hale getirir. Bu gelişme, yüksek doğruluk ve daha büyük işlem hacmi sağlayan yeni microscaling formatlarını tanıtan yeni nesil Tensor Çekirdekleri sayesinde mümkün olmuştur. Ek olarak, GB200 NVL72, iletişim darboğazlarını aşabilen tek bir devasa 72-GPU’luk bir raf oluşturmak için NVLink ve sıvı soğutma kullanır.

Büyük Ölçekli Eğitim

GB200 NVL72, FP8 hassasiyetine sahip daha hızlı ikinci nesil Transformer Motorunu içerir ve bu da büyük dil modellerinin ölçekli eğitimini 4 kat daha hızlı hale getirir. Bu atılım, GPU’dan GPU’ya 1.8 terabayt/saniye (TB/s) bağlantı sağlayan beşinci nesil NVLink, InfiniBand ağı ve NVIDIA Magnum IO yazılımı ile desteklenir.

Enerji Verimli Altyapı

Sıvı soğutmalı GB200 NVL72 rafları, bir veri merkezinin karbon ayak izini ve enerji tüketimini azaltır. Sıvı soğutma, hesaplama yoğunluğunu artırır, kullanılan zemin alanını azaltır ve büyük NVLink domain mimarileriyle yüksek bant genişliği, düşük gecikmeli GPU iletişimini kolaylaştırır. NVIDIA H100 hava soğutmalı altyapıya kıyasla, GB200 aynı güçte 25 kat daha fazla performans sunarken su tüketimini azaltır.

Veri İşleme

Veritabanları, işletmeler için büyük miktarda veriyi işleme, işleme ve analiz etmede kritik roller oynar. GB200, yüksek bant genişlikli bellek performansı, NVLink-C2C ve NVIDIA Blackwell mimarisindeki özel sıkıştırma motorlarından yararlanarak, CPU’ya kıyasla önemli veritabanı sorgularını 18 kat hızlandırır ve 5 kat daha iyi toplam sahip olma maliyeti (TCO) sunar.

Teknolojik Yenilikler

Blackwell Mimarisi

NVIDIA Blackwell mimarisi, hızlandırılmış hesaplamada çığır açan ilerlemeler sunarak benzersiz performans, verimlilik ve ölçekle yeni bir hesaplama çağını güçlendiriyor.

NVIDIA Grace CPU

NVIDIA Grace CPU, yapay zeka, bulut ve HPC uygulamalarını çalıştıran modern veri merkezleri için tasarlanmış çığır açan bir işlemcidir. Günümüzün önde gelen sunucu işlemcilerine göre 2 kat daha fazla enerji verimliliğiyle olağanüstü performans ve bellek bant genişliği sağlar.

Beşinci Nesil NVLink

Exascale hesaplamanın ve trilyon parametreli yapay zeka modellerinin tam potansiyelinin ortaya çıkarılması, bir sunucu kümesindeki her GPU arasında hızlı, kesintisiz iletişim gerektirir. Beşinci nesil NVLink, trilyonlarca ve multi trilyonlarca parametreli yapay zeka modelleri için hızlandırılmış performansı ortaya çıkaran, ölçeği büyütülmüş bir ara bağlantıdır.

NVIDIA Networking

Exascale hesaplamanın ve trilyon parametreli yapay zeka modellerinin tam potansiyelinin ortaya çıkarılması, bir sunucu kümesindeki her GPU arasında hızlı, kesintisiz iletişim gerektirir. Beşinci nesil NVLink, trilyonlarca ve multi trilyonlarca parametreli yapay zeka modelleri için hızlandırılmış performansı ortaya çıkaran, ölçeği büyütülmüş bir ara bağlantıdır.

GB200 NVL72 Özellikleri

| GB200 NVL72 | GB200 Grace Blackwell Superchip | |

|---|---|---|

| Konfigürasyon | 36 Grace CPU : 72 Blackwell GPU | 1 Grace CPU : 2 Blackwell GPU |

| FP4 Tensor Çekirdeği | 1,440 PFLOPS | 40 PFLOPS |

| FP8/FP6 Tensor Çekirdeği | 720 PFLOPS | 20 PFLOPS |

| INT8 Tensor Çekirdeği | 720 POPS | 20 POPS |

| FP16/BF16 Tensor Çekirdeği | 360 PFLOPS | 10 PFLOPS |

| TF32 Tensor Çekirdeği | 180 PFLOPS |

5 PFLOPS |

| FP32 | 6,480 TFLOPS | 180 TFLOPS |

| FP64 | 3,240 TFLOPS | 90 TFLOPS |

| GPU Bellek Bant Genişliği | 13.5 TB HBM3e’e kadar | 576 TB/s | 384 GB HBM3e | 16 TB/s’e kadar |

| NVLink Bant Genişliği | 130 TB/s | 3.6 TB/s |

| CPU Çekirdek Sayısı | 2,592 Arm Neoverse V2 çekirdekleri | 72 Arm Neoverse V2 Çekirdekleri |

| CPU Bellek | Bant Genişliği | 17 TB LPDDR5X’e kadar | 18.4 TB/s’e kadar | 480GB LPDDR5X’e kadar| 512 GB/s’e kadar |