Yapay Zeka Devriminin Altyapısı

Yapay zeka, HPC ve veri merkezi iş yükleri için tasarlanmış profesyonel GPU sunucularına, NVIDIA DGX AI Compute Systems Partneri OpenZeka güvencesiyle sahip olun.

GPU SUNUCULARI

GPU sunucuları; çoklu ekran kartı desteğiyle yüksek hesaplama gücü sunan ve bu sayede yapay zeka, HPC ve veri işleme gibi yoğun iş yüklerini hızlı ve verimli şekilde gerçekleştiren sunuculardır. SXM tabanlı DGX ve HGX sistemleri; NVLink ve NVSwitch teknolojileri sayesinde düşük gecikme ve yüksek bant genişliği sunarak büyük ölçekli yapay zeka eğitimlerinde en yüksek performansı sağlar. PCIe tabanlı çözümler ise daha uygun maliyet ve geniş uyumluluk sunan alternatiflerdir. SXM mimarisi, ChatGPT, Claude, Gemini ve LLaMA gibi modern büyük dil modellerinin arkasındaki temel GPU altyapısını oluşturur.

| DGX Sunucular | HGX Sunucular | PCIe Sunucular | |

|---|---|---|---|

| Tanım | NVIDIA’nın uçtan uca optimize ettiği; GPU, CPU, bellek, depolama ve ağ ile birlikte sunulan GPU sunucuları | OEM üreticilerin, NVIDIA’nın SXM GPU ve NVSwitch altyapısının üzerine; CPU, bellek, depolama ve ağ bileşenlerini ekleyerek sunduğu esnek GPU sunucuları | Standart PCIe GPU kartlarının kullanıldığı, uygun maliyetli ve uyumlu sunucular |

| Üretici | NVIDIA | OEM üreticiler (HGX platformu NVIDIA tarafından sağlanır) | OEM üreticiler (Dell, HP, Supermicro, Gigabyte vb.) |

| Performans | GPU’lar birbirleri ile doğrudan iletişim kurdukları için düşük gecikme ve yüksek bant genişliğiyle maksimum performans sağlanır. | GPU’lar birbirleri ile doğrudan iletişim kurdukları için düşük gecikme ve yüksek bant genişliğiyle maksimum performans sağlanır. | GPU’lar PCIe veri yolu üzerinden iletişim kurdukları için performans DGX ve HGX çözümlerine kıyasla nispeten daha düşük kalır. |

| Esneklik | NVIDIA tüm donanımı hazır ve sabit konfigürasyonla gönderdiği için esneklik düşüktür. | OEM üreticiler CPU, RAM, depolama ve ağ bileşenlerini farklı kombinasyonlarda sunabilir. GPU sayısı da modele göre değişebilir (ör. 4 veya 8 SXM GPU) | PCIe tabanlı yapısı sayesinde GPU’lar kolayca eklenip çıkarılabilir ve sistem ihtiyaçlara göre esnek biçimde ölçeklenebilir. |

| Ölçeklenebilirlik | NVSwitch + InfiniBand ile binlerce GPU’ya kadar | NVSwitch + InfiniBand ile binlerce GPU’ya kadar | Genellikle tek sunucu içinde 4–8 GPU ile sınırlı |

| Kullanım Alanı | Büyük dil modelleri, HPC, ileri seviye araştırmalar | Büyük dil modelleri, HPC, ileri seviye araştırmalar ve kurumlara özel çözümler | Orta ölçekli eğitim, çıkarım, veri analitiği, görselleştirme |

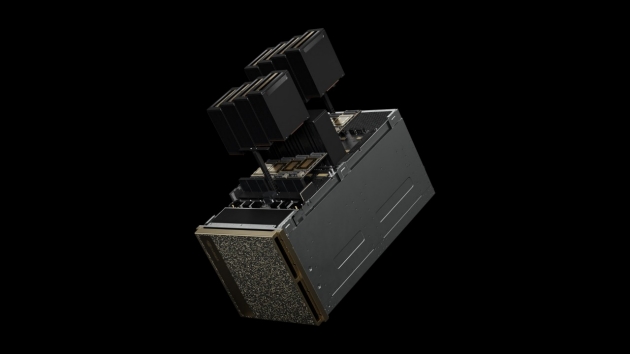

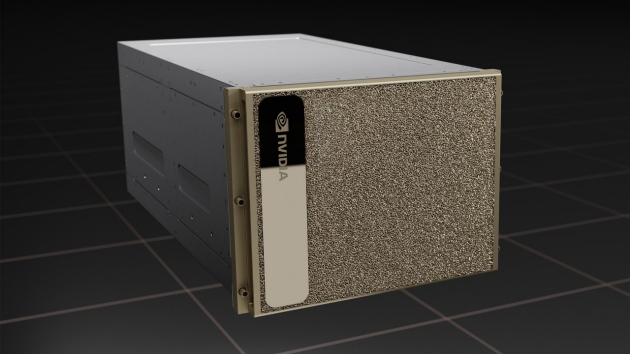

DGX SUNUCULAR

DGX sunucuları; NVIDIA’nın tüm bileşenleri bir arada sunduğu, yapay zeka ve HPC için optimize edilmiş kurumsal GPU sistemleridir. Maksimum performans ve kolay kurulum avantajıyla büyük modeller için idealdir.

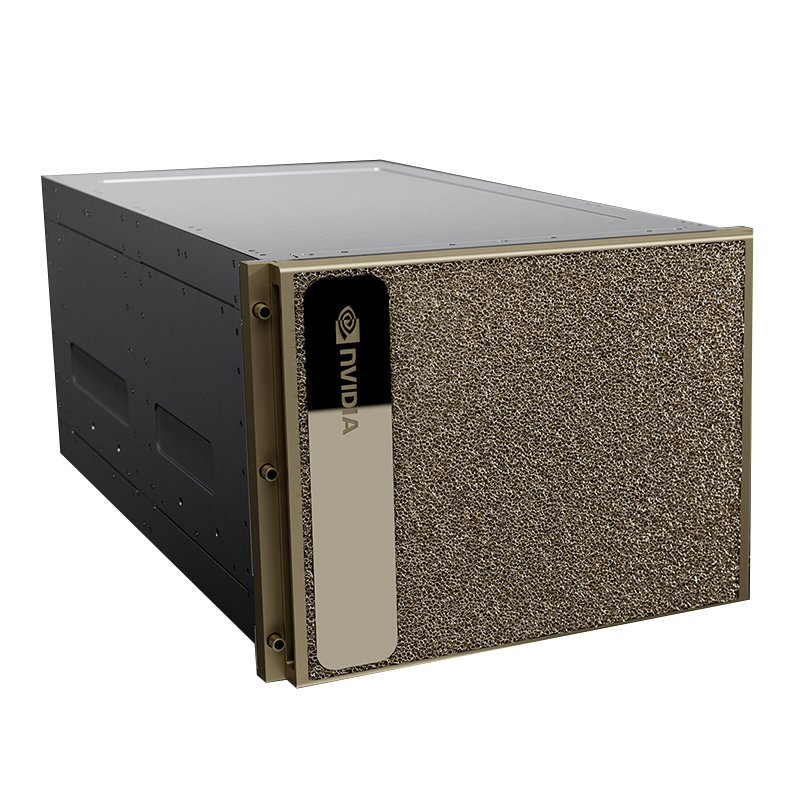

HGX SUNUCULAR

HGX sunucuları; NVIDIA’nın sağladığı HGX platformunun OEM üreticiler tarafından sunucu altyapısına entegre edilmesiyle oluşturulan; yapay zeka eğitimi, HPC ve veri analitiği gibi farklı iş yüklerine uyarlanabilen esnek ve yüksek performanslı GPU sistemleridir.

| HGX B300 | HGX B200 | HGX H200 | ||

|---|---|---|---|---|

| 4-GPU | 8-GPU | |||

| Form Factor | 8x NVIDIA Blackwell Ultra SXM | 8x NVIDIA Blackwell SXM | 4x NVIDIA H200 SXM | 8x NVIDIA H200 SXM |

| FP4 Tensor Core | 144 PFLOPS | 108 PFLOPS | 144 PFLOPS | 72 PFLOPS | 16 PFLOPS | 32 PFLOPS |

| TF32 Tensor Core | 18 PFLOPS | 18 PFLOPS | 4 PFLOPS | 8 PFLOPS |

| Total Memory | Up to 2.1 TB | 1.4 TB | 564 GB HBM3e | 1.1 TB HBM3e |

| Networking Bandwidth | 1.6 TB/s | 0.8 TB/s | 0.4 TB/s | 0.8 TB/s |

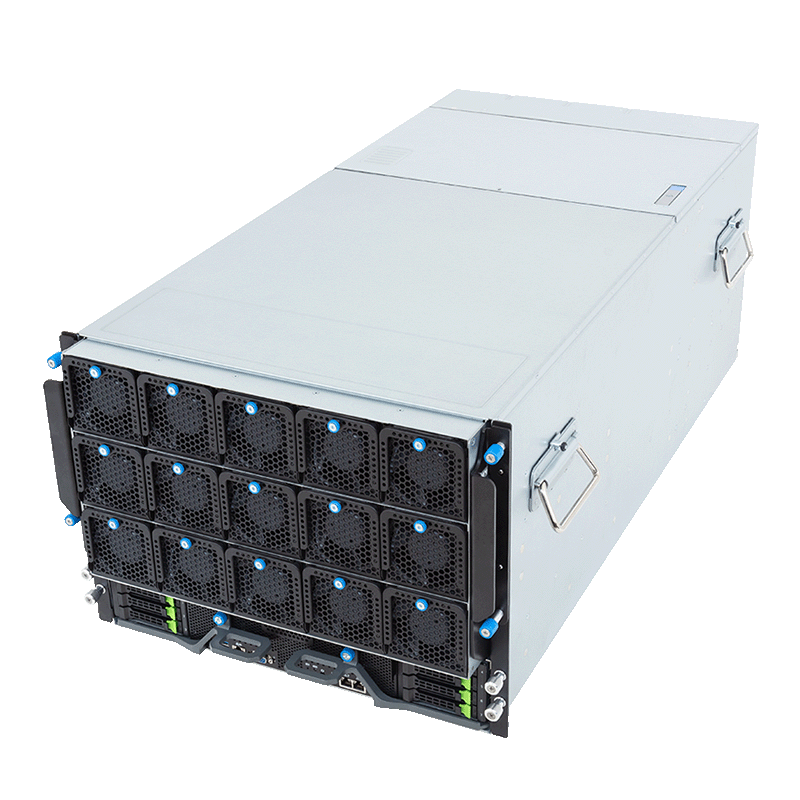

PCIe SUNUCULAR

PCIe sunucuları; NVIDIA’nın PCIe tabanlı GPU kartlarını kullanan, yüksek uyumluluk ve maliyet verimliliği sunan esnek GPU sunucularıdır. Orta ölçekli yapay zeka eğitimi, çıkarım, veri analitiği ve işleme iş yükleri için dengeli bir performans sağlar.