Dünyanın en Güçlü Grafik Kartı

NVIDIA H200 Tensor Core GPU, eşsiz performansı ve bellek yetenekleri ile üretken yapay zeka ve yüksek performanslı hesaplama (HPC) iş yüklerine güç katıyor. HBM3e ile donatılmış ilk GPU olarak, H200’ün daha yüksek ve daha hızlı belleği, üretken yapay zeka ve büyük dil modellerinin (LLM’lerin) hızlanmasını sağlarken HPC iş yükleri için bilimsel hesaplama alanını ilerletiyor.

Üst Düzey Performansı Deneyimleyin

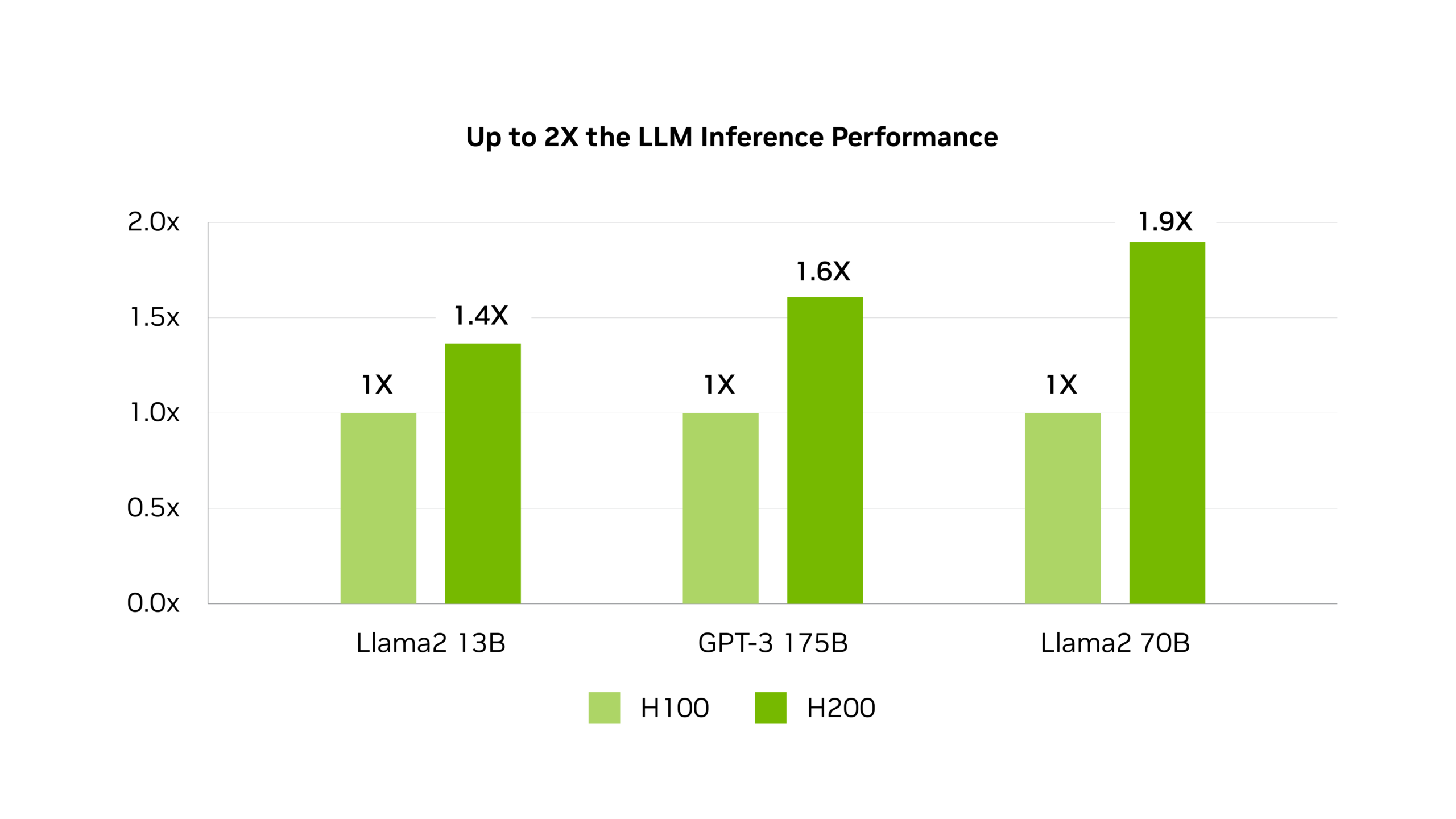

Llama2 70B Çıkarımı

1.9X

Daha Hızlı

GPT-3 175 Çıkarımı

1.6X

Daha Hızlı

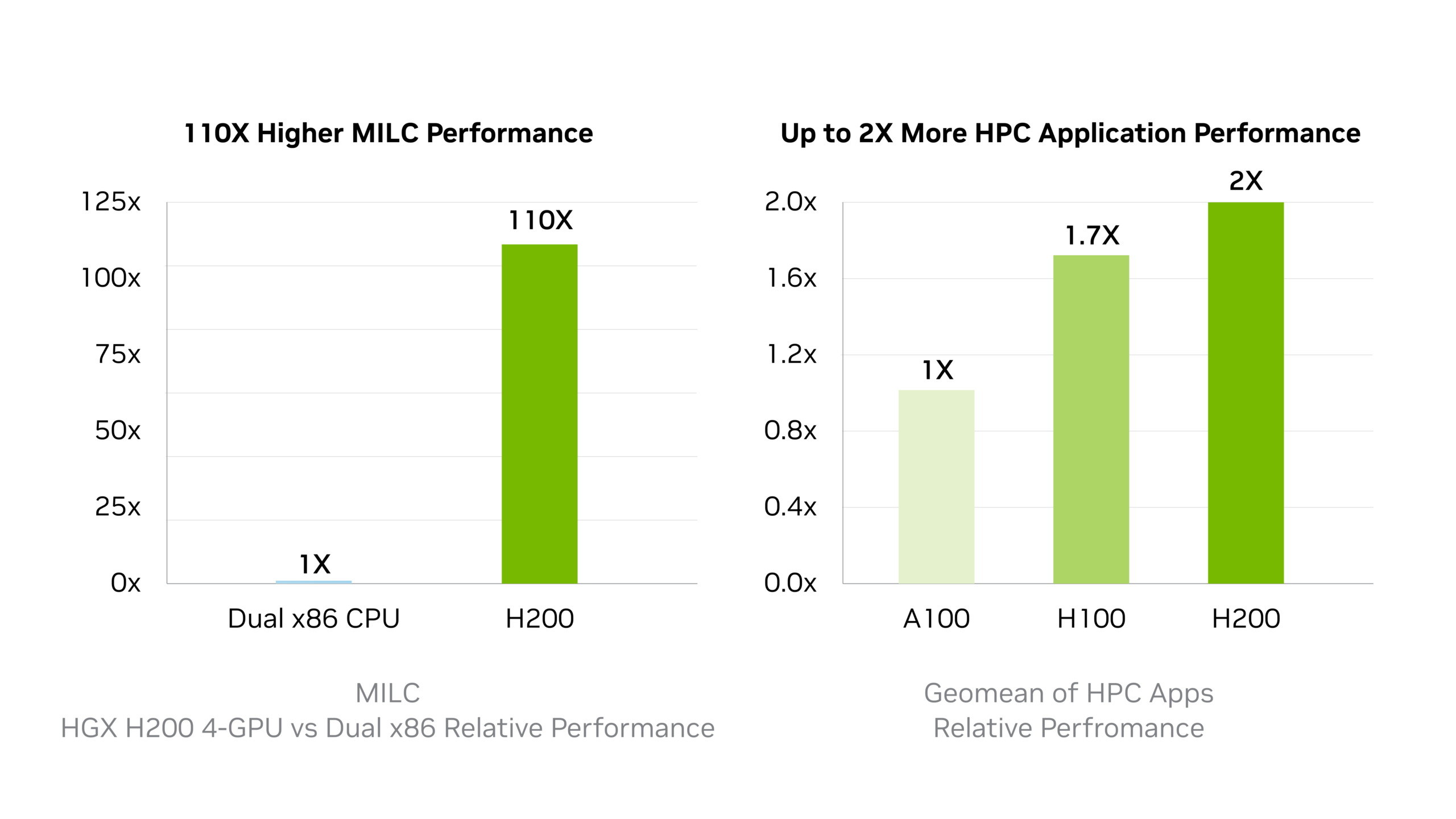

Yüksek Başarımlı Hesaplama

110X

Daha Hızlı

DERİN ÖĞRENME PERFORMANSI

NVIDIA Hopper mimarisi üzerine kurulu olan NVIDIA H200, 4.8 terabayt/saniye hızında 141 gigabayt (GB) HBM3e bellek sunan ilk GPU’dur. ( NVIDIA H100 Tensor Core GPU’nun neredeyse iki katı kapasitede ve %1.4 daha fazla bellek bant genişliğine sahip olması anlamına geliyor.)H200’ün daha büyük ve hızlı belleği, üretken yapay zeka ve LLM’leri hızlandırırken, HPC iş yükleri için bilimsel hesaplama alanını daha iyi enerji verimliliği ve daha düşük toplam sahip olma maliyeti ile ilerletiyor.

Değerlerde değişiklik olabilir.

Llama2 13B: ISL 128, OSL 2K | Verim | H100 1x GPU BS 64 | H200 1x GPU BS 128

GPT-3 175B: ISL 80, OSL 200 | x8 H100 GPU’lar BS 64 | x8 H200 GPU’lar BS 128

Llama2 70B: ISL 2K, OSL 128 | Verim | H100 1x GPU BS 8 | H200 1x GPU BS 32.

Yüksek Performanslı LLM Çıkarımlarını Hızlandırın

H200, Llama2 gibi LLM’leri işlerken H100 GPU’lara kıyasla çıkarım hızını 2 katına kadar artırır.

HPC İş Yüklerini Hızlandırın

HPC uygulamaları için bellek bant genişliği, karmaşık işleme engellerini azaltarak daha hızlı veri transferine olanak tanıdığı için büyük önem taşır. Simülasyonlar, bilimsel araştırmalar ve yapay zeka gibi bellek yoğun HPC uygulamaları için, H200’ün yüksek bellek bant genişliği, verilerin etkili bir şekilde erişilip işlenmesini sağlar. Bu durum CPU’lara kıyasla sonuçlara ulaşma süresini 110 kat daha hızlı hale getirir.

Değerlerde değişiklik olabilir.

HPC MILC-veri kümesi NERSC Apex Medium | HGX H200 4-GPU | çift Safir Rapids 8480

HPC Uygulamaları- CP2K: H2O-32-RI-dRPA-96points veri kümesi | GROMACS: STMV veri kümesi | SİMGE: veri kümesi r2b5 | MILC: veri kümesi NERSC Apex Medium | Chroma: veri kümesi HMC Medium | Quantum Espresso: AUSURF112 veri kümesi | 1x H100 | 1x H200.

Değerlerde değişiklik olabilir.

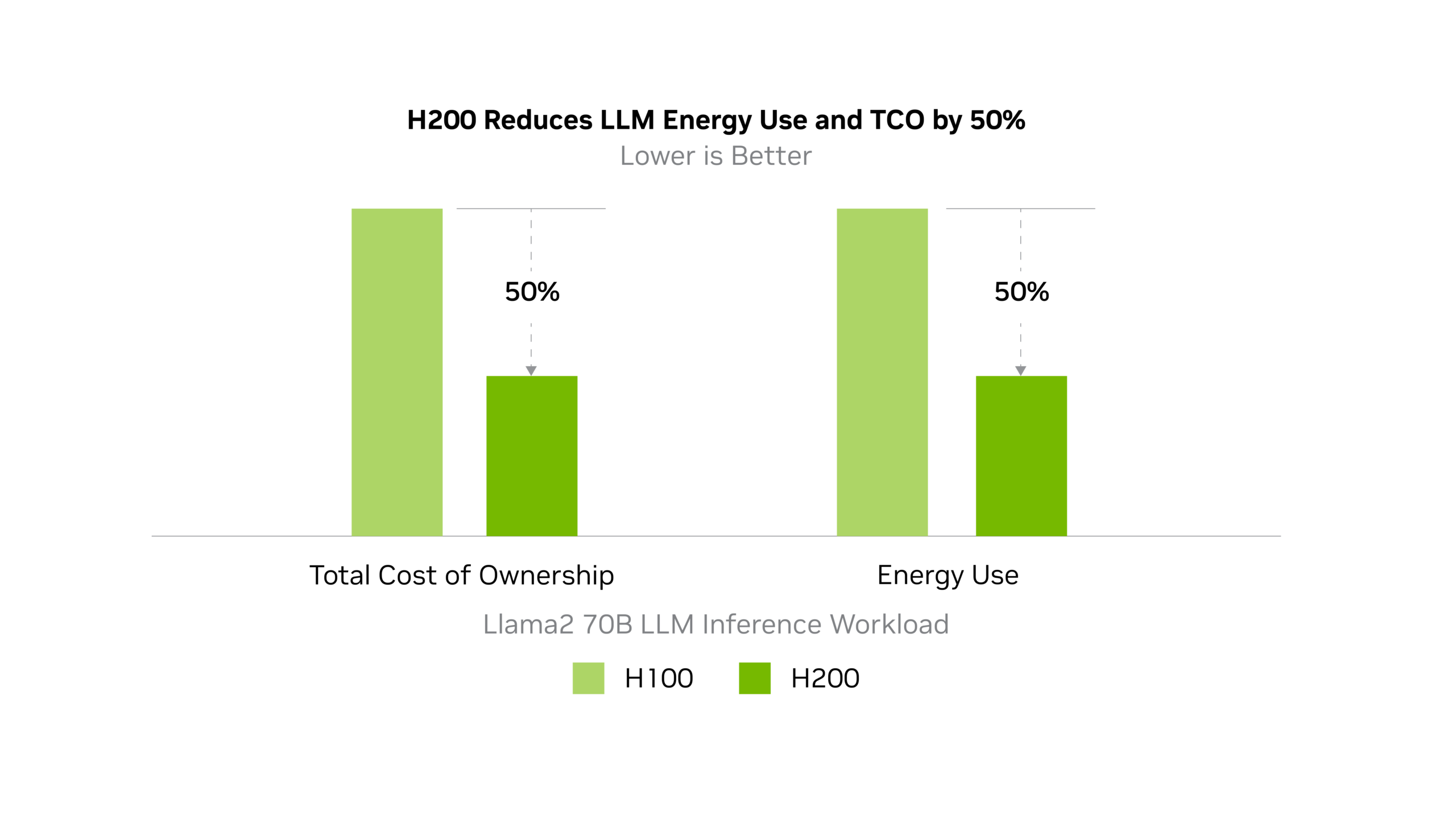

Llama2 70B: ISL 2K, OSL 128 | Verim | H100 1x GPU BS 8 | H200 1x GPU BS 32

Enerjiyi ve Toplam Sahip Olma Maliyetini Azaltın

H200’nün tanıtımıyla birlikte enerji verimliliği ve TCO (toplam sahip olma maliyeti) yeni seviyelere ulaşıyor. Bu öncü teknoloji, H100 ile aynı güç profili içinde eşsiz bir performans sunuyor. Hızlı olmanın yanı sıra çevre dostu olan yapay zeka fabrikaları ve süper bilgisayar sistemleri, AI ve bilimsel topluluğu ileri taşıyan ekonomik bir avantaj sunuyor.

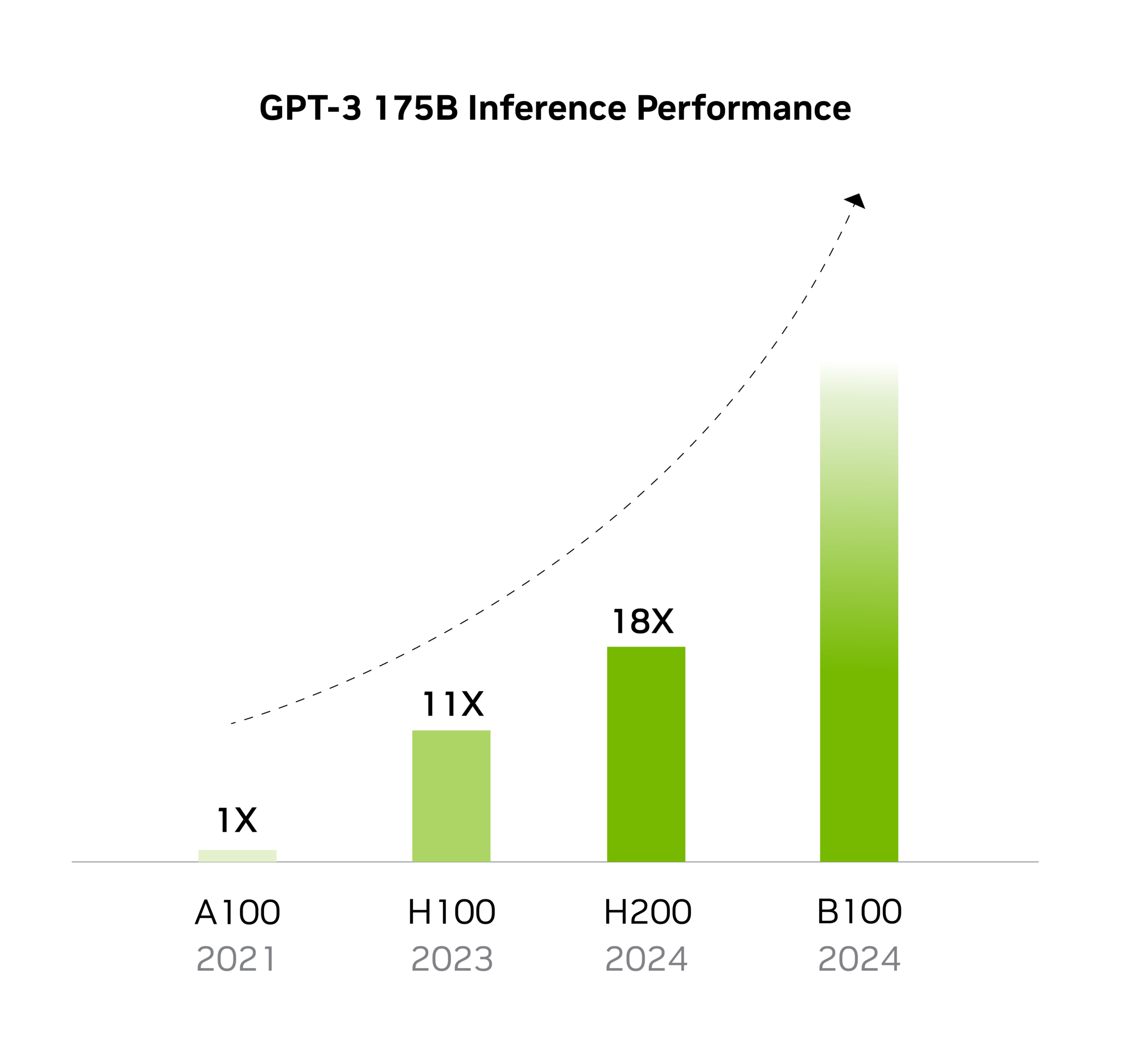

Tek düğümlü HGX ölçülen performans | A100 Nisan 2021 | H100 TensorRT-LLM Ekim 2023 | H200 TensorRT-LLM Ekim 2023

Özellikler

| Form Faktör | H200 SXM | H200 NVL |

|---|---|---|

| FP64 | 34 TFLOPS | 30 TFLOPS |

| FP64 Tensor Çekirdeği | 67 TFLOPS | 60 TFLOPS |

| FP32 | 67 TFLOPS | 60 TFLOPS |

| TF32 Tensor Çekirdeği | 989 TFLOS | 835 TFLOPS |

| BFLOAT16 Tensor Çekirdeği | 1979 TFLOPS | 1671 TFLOPS |

| FP16 Tensor Çekirdeği | 1979 TFLOPS | 1671 TFLOPS |

| FP8 Tensor Çekirdeği | 3958 TFLOPS | 3341 TFLOPS |

| GPU Belleği | 141 GB | 141 GB |

| GPU Bellek Bant Genişliği | 4.8 TB/s | 4.8 TB/s |

| Decoder | 7 NVDEC 7 JPEG |

7 NVDEC 7 JPEG |

| TDP Gücü | 700W’a kadar | 600W’a kadar |

| Multi-Instance GPU(MIG) | 7 MIG’e kadar, her biri @18GB | 7 MIG’e kadar, her biri @16.5GB |

| Form Faktörü | SXM | PCIe Dual-slot-air-cooled |

| Ara Bağlantı | NVIDIA NVLink 900GB/s PCIe Gen5: 128GB/s | 2- or 4-way NVIDIA NVLink bridge: 900GB/s per GPU PCIe Gen5: 128GB/s |

| Sunucu Opsiyonları | NVIDIA HGX H200 partneri ve 4 veya 8 GPU’lu NVIDIA Sertifikalı Sistemler™ | NVIDIA MGX™ H200 NVL ortağı ve 8 adede kadar GPU’lu NVIDIA Sertifikalı Sistemler |

| NVIDIA AI Enterprise | Ayrıyeten | Dahil |