NVIDIA HGX AI SÜPER BİLGİSAYARI

Dünyanın en güçlü uçtan uca AI hesaplama platformu

NVIDIA HGX AI SÜPER BİLGİSAYARI

En güçlü uçtan uca AI hesaplama platformu

Yapay Zeka ve Yüksek Performanslı Hesaplama için Tasarlandı

Yapay zeka, karmaşık simülasyonlar ve devasa veri kümeleri; son derece hızlı bağlantılarla birbirine bağlanan birden fazla GPU ve tamamen hızlandırılmış bir yazılım yığını gerektirir.

NVIDIA HGX™ platformu, NVIDIA GPU’larının tüm gücünü, NVIDIA NVLink™, NVIDIA ağ teknolojilerini ve optimize edilmiş yapay zeka ile yüksek performanslı bilişim (HPC) yazılım yığınlarını bir araya getirerek en yüksek uygulama performansını sağlar ve her veri merkezi için en hızlı içgörü elde etme sürecini sağlar.

Hızlandırışmış Uçtan Uca Hesaplama Platformu

NVIDIA HGX B300, NVIDIA Blackwell Ultra GPU’larını yüksek hızlı ara bağlantılarla entegre ederek veri merkezlerini hızlandırılmış hesaplama ve üretken yapay zekada yeni bir çağa taşıyor. Önceki nesle kıyasla 11 kata kadar daha yüksek çıkarım (inference) performansı sunan bu NVIDIA Blackwell tabanlı HGX sistemleri, en zorlu üretken yapay zeka, veri analitiği ve yüksek performanslı bilgi işlem (HPC) iş yükleri için tasarlanmış üstün ölçeklenebilir hızlandırma platformudur.

NVIDIA HGX, en yüksek yapay zeka performansı için 800 gigabit/saniyeye (Gb/s) kadar hızlara ulaşan NVIDIA Quantum-X800 InfiniBand ve Spectrum™-X Ethernet ile gelişmiş ağ seçenekleri sunar. Ayrıca, bulut ağ iletişimi, bileşen bazlı depolama, sıfır güvenlik (zero-trust security) ve hiperscale yapay zeka bulutlarında GPU işlem esnekliği sağlamak için NVIDIA BlueField®-3 veri işleme birimlerini (DPU) de içerir.

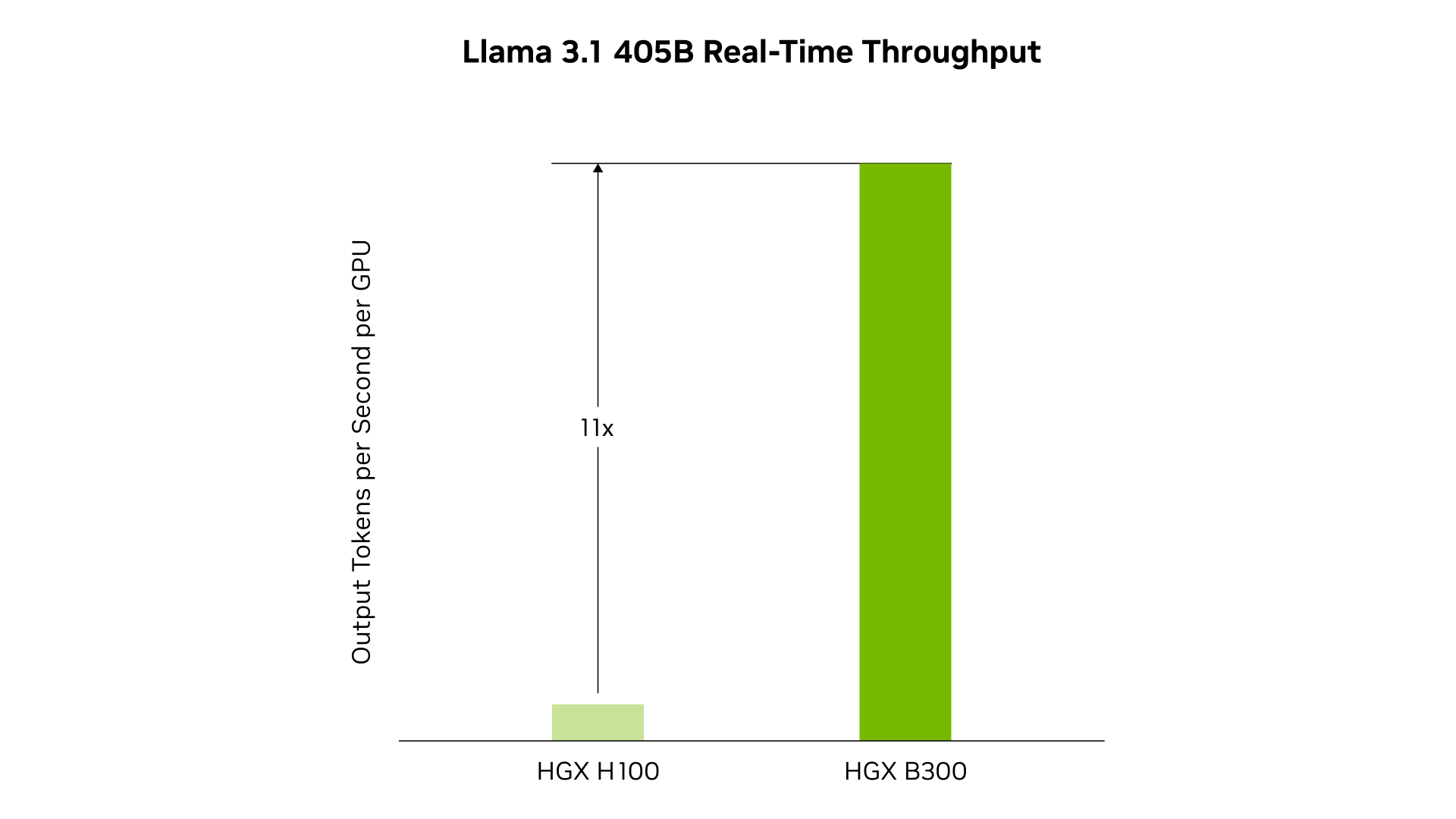

Yapay Zeka Akıl Yürütme Çıkarımı: Performans ve Çok Yönlülük

Tahmini performans değişebilir. Jetondan jetona gecikme (TTL) = 20 ms gerçek zamanlı, ilk jeton gecikmesi (FTL) = 5 sn, giriş dizisi uzunluğu = 32.768, çıkış dizisi uzunluğu = 1.028, 1x sekiz yollu HGX H100 GPU hava soğutmalı ile 1x sekiz yollu HGX B300 hava soğutmalı GPU performans karşılaştırması; ayrıştırılmış çıkarım kullanılarak sunulmuştur.

Yeni Nesil Büyük Dil Modelleri ile Gerçek Zamanlı Çıkarım

HGX B300, Llama 3.1 405B gibi modellerde önceki NVIDIA Hopper™ nesline kıyasla çıkarım (inference) performansında 11 kata kadar artış sağlar. İkinci nesil Transformer Engine, özel Blackwell Tensor Core teknolojisini TensorRT™-LLM yenilikleriyle birleştirerek büyük dil modellerinin (LLM) çıkarım süreçlerini hızlandırır.

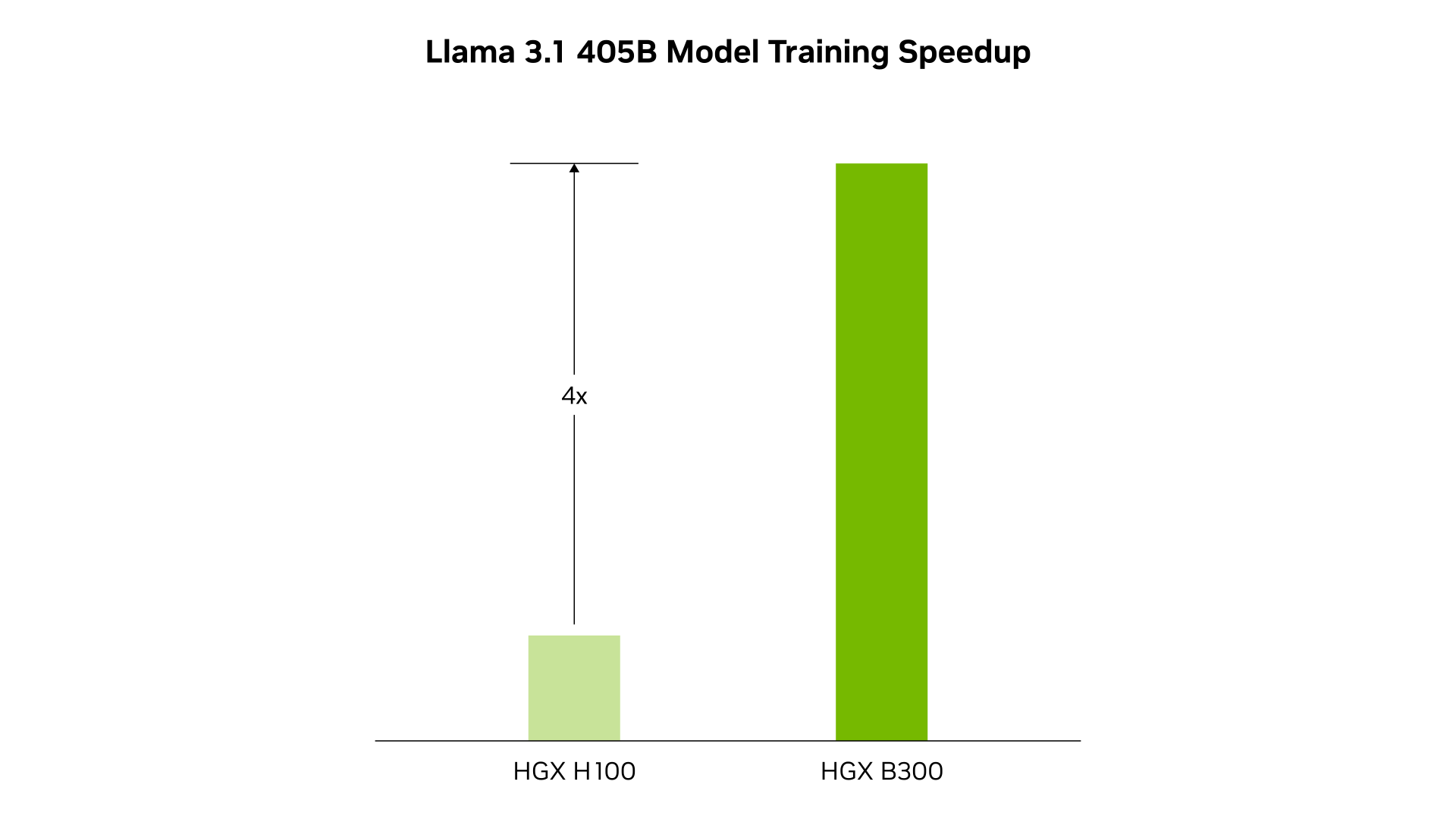

Yapay Zeka Eğitimi: Performans ve Ölçeklenebilirlik

Tahmini performans değişiklik gösterebilir. 1x sekiz yollu HGX H100 ile 1x sekiz yollu HGX B300, GPU başına performans karşılaştırması.

Sonraki Seviye Eğitim Performansı

8-bit floating point (FP8) ve yeni hassasiyetleri destekleyen ikinci nesil Transformer Engine, Llama 3.1 405B gibi büyük dil modellerinde 4 kata kadar daha hızlı eğitim imkânı sunar. Bu atılım; 1,8 TB/sn GPU-GPU bağlantı hızına sahip beşinci nesil NVLink, InfiniBand ağ teknolojileri ve NVIDIA Magnum IO™ yazılımıyla tamamlanmaktadır. Tüm bu bileşenler birlikte, kurumsal ölçekte verimli ölçeklenebilirlik ve geniş GPU hesaplama kümeleri için ideal altyapıyı sağlar.

NVIDIA HGX ÖZELLİKLERİ

NVIDIA HGX, dört veya sekiz H200 veya H100 GPU’lu veya sekiz Blackwell GPU’lu tekli anakartlarda mevcuttur. Donanım ve yazılımın bu güçlü kombinasyonları, benzeri görülmemiş AI süper bilgisayar performansının temelini oluşturur.

| HGX B300 | HGX B200 | |

|---|---|---|

| Form Faktör | 8x NVIDIA Blackwell Ultra SXM | 8x NVIDIA Blackwell GPU |

| FP4 Tensor Çekirdeği | 144 PFLOPS | 105 PFLOPS | 144 PFLOPS | 72 PFLOPS |

| FP8/FP6 Tensor Çekirdeği | 72 PFLOPS | 72 PFLOPS |

| INT8 Tensor Çekirdeği | 2 POPS | 72 POPS |

| FP16/ BF16 Tensor Çekirdeği | 36 PFLOPS | 36 PFLOPS |

| TF32 Tensor Çekirdeği | 18 PFLOPS | 18 PFLOPS |

| FP32 | 600 TFLOPS | 600 TFLOPS |

| FP64/ FP64 Tensor Çekirdeği | 10 TFLOPS | 296 TFLOPS |

| Total Bellek | 2.3 TB'a kadar | 1.4 |

| NVLink | 5.Nesil | 5.Nesil |

| NVIDIA NVSwitch | NVLink 5 Switch | NVLink 5 Switch |

| NVSwitch GPU-to-GPU Bandwidth | 1.8 TB/s | 1.8TB/s |

| Toplam Bant Genişliği | 14.4 TB/s | 14.4 TB/s |

| Networking Bant Genişliği | 1.6 TB/s | 0.8 TB/s |

| Attention Performansı | 2X | 1X |

| HGX H200 | ||

|---|---|---|

| 4-GPU | 8-GPU | |

| Form Faktör | 4x NVIDIA H200 SXM | 8x NVIDIA H200 SXM |

| FP8 Tensor Çekirdeği | 16 PFLOPS | 32 PFLOPS |

| INT8 Tensor Çekirdeği | 16 POPS | 32 POPS |

| FP16/BF16 Tensor Çekirdeği | 8 PFLOPS | 16 PFLOPS |

| TF32 Tensor Çekirdeği | 4 PFLOPS | 8 PFLOPS |

| FP32 | 270 TFLOPS | 540 TFLOPS |

| FP64 | 140 TFLOPS | 270 TFLOPS |

| FP64 Tensor Çekirdeği | 270 TFLOPS | 540 TFLOPS |

| Bellek | 564GB HBM3 | 1.1TB HBM3 |

| GPU Bant Genişliği | 19GB/s | 38 GB/s |

| NVLink | 4. Nesil | 4. Nesil |

| NVIDIA NVSwitch | - | 3. Nesil |

| NVSwitch GPU-to-GPU Bandwidth | - | 900GB/s |

| Toplam Bant Genişliği | 3.6TB/s | 7.2TB/s |

| HGX H100 | ||

|---|---|---|

| 4-GPU | 8-GPU | |

| Form Faktör | 4x NVIDIA H100 SXM | 8x NVIDIA H100 SXM |

| FP8 Tensor Çekirdeği | 16 PFLOPS | 32 PFLOPS |

| INT8 Tensor Çekirdeği | 16 POPS | 32 POPS |

| FP16/BF16 Tensor Çekirdeği | 8 PFLOPS | 16 PFLOPS |

| TF32 Tensor Çekirdeği | 4 PFLOPS | 8 PFLOPS |

| FP32 | 270 TFLOPS | 540 TFLOPS |

| FP64 | 140 TFLOPS | 270 TFLOPS |

| FP64 Tensor Çekirdeği | 270 TFLOPS | 540 TFLOPS |

| Bellek | 320GB HBM3 | 640GB HBM3 |

| GPU Bant Genişliği | 13GB/s | 27GB/s |

| NVLink | 4. Nesil | 4. Nesil |

| NVIDIA NVSwitch | - | 3. Nesil |

| NVSwitch GPU-to-GPU Bandwidth | - | 900GB/s |

| Toplam Bant Genişliği | 3.6TB/s | 7.2TB/s |