NVIDIA TRITON INFERENCE SERVER

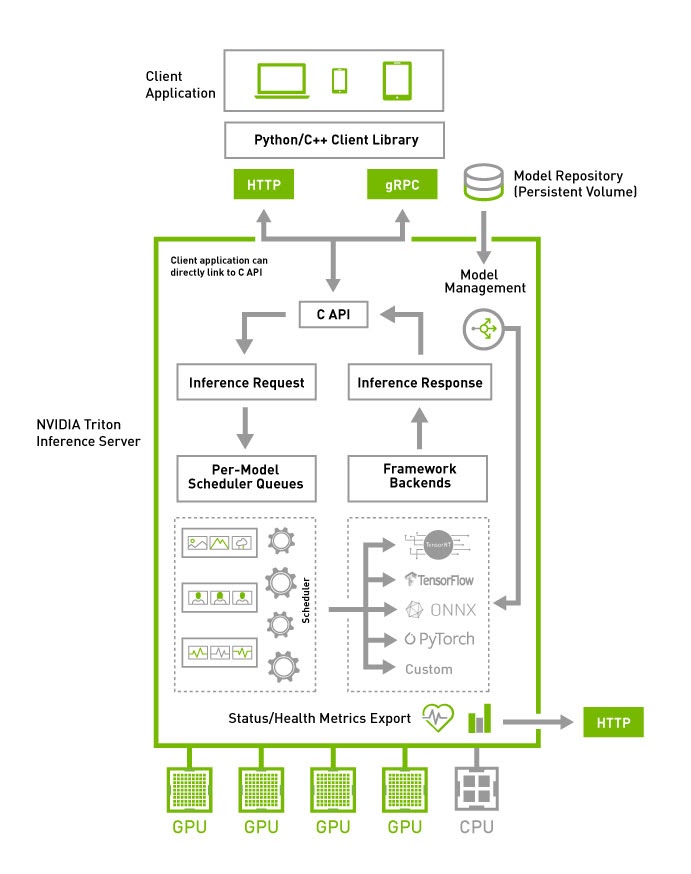

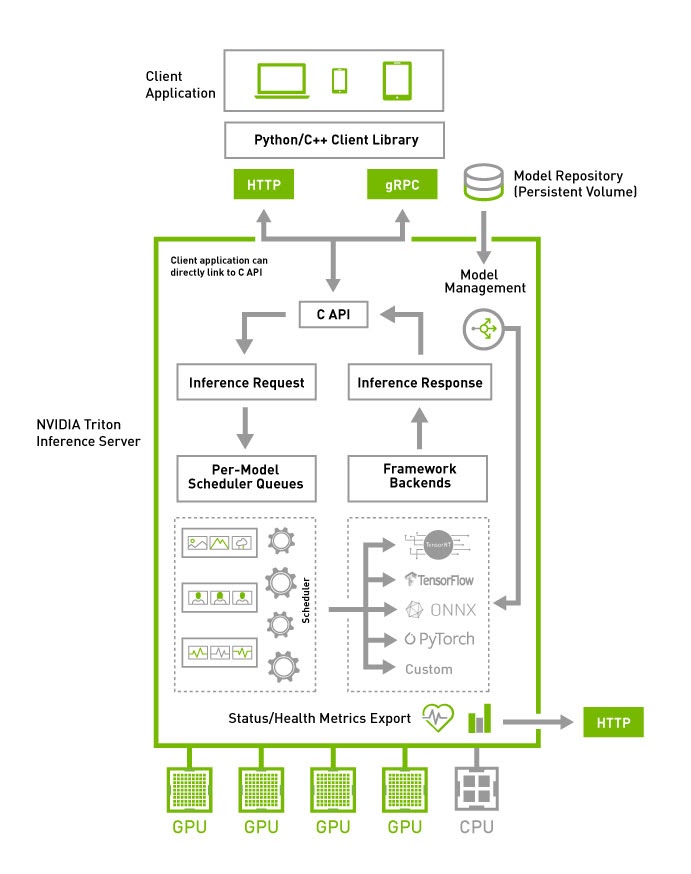

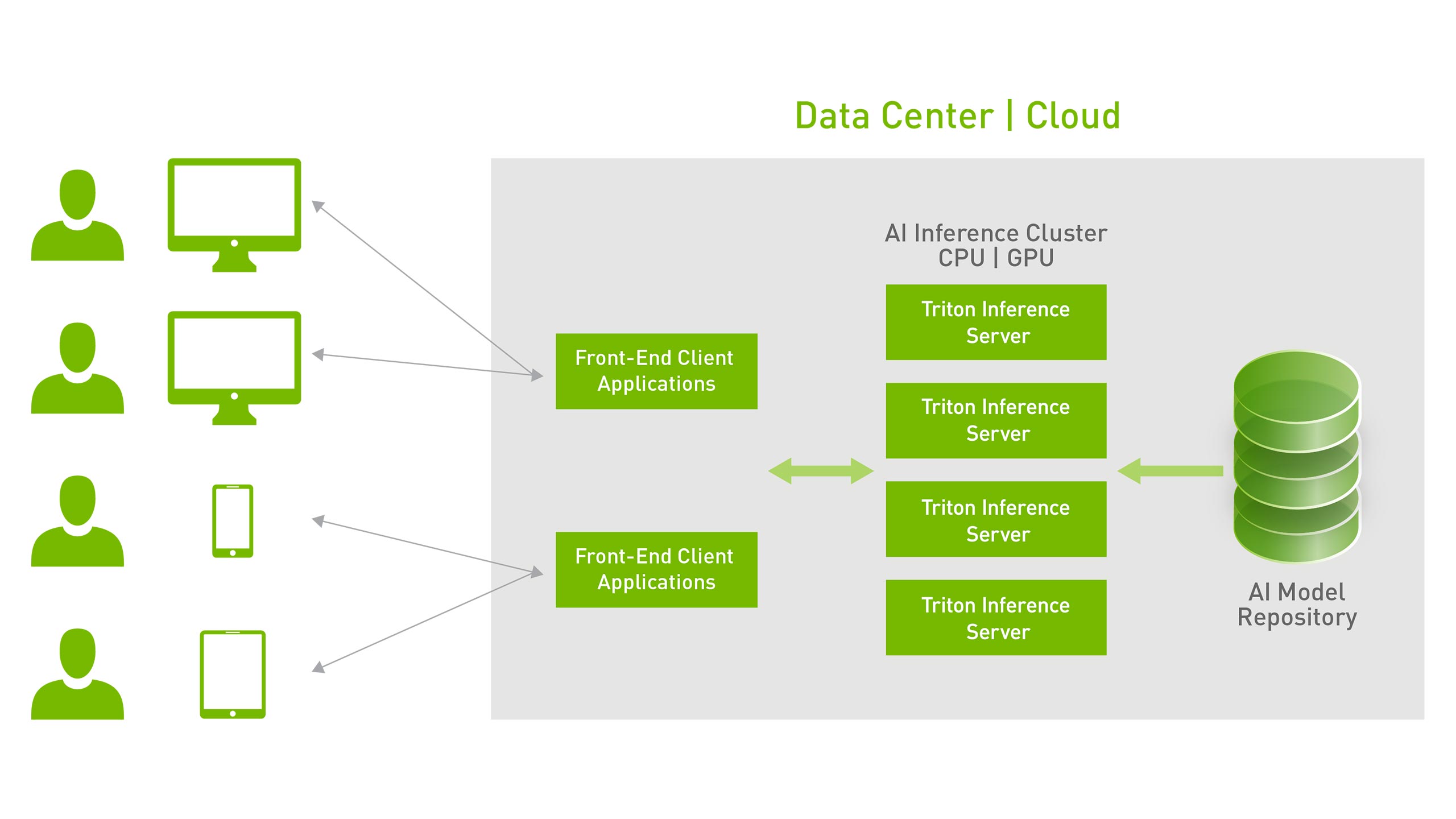

NVIDIA Triton™ Inference Server, ürünler için hızlı ve ölçeklenebilir AI sağlar. Açık kaynak çıkarım sağlama yazılımı olan Triton Inference Server, geliştiricilerin herhangi bir kütüphaneden (TensorFlow, NVIDIA TensorRT® Pytorch, ONNX, XGBoost, Python ve daha fazlası) GPU veya CPU tabanlı(bulutta, veri merkezinde veya uçta) bir altyapıda eğittiği AI modellerini çalıştırmasını sağlayarak AI çıkarımını kolaylaştırır.

Çoklu Kütüphane Desteği

Triton Inference Server, TensorFlow, TensorRT, PyTorch, MXNet, Python, ONNX, RAPIDS FIL (XGBoost, scikit-learn vb. kullanımı için), OpenVINO, özel C++ ve daha birçok büyük kütüphaneyi destekler. Triton, AI araştırmacılarının ve veri bilimcilerin, projeleri için doğru kütüphaneyi seçme özgürlüğü sağlar.

Yüksek Performanslı Çıkarım

Triton, verimi ve kullanılabilirliği en üst düzeye çıkarmak için modelleri GPU’larda eşzamanlı olarak çalıştırır. x86 ve ARM CPU tabanlı çıkarımı destekler. Dinamik gruplama, model analizörü, model topluluğu ve ses akışı gibi özellikler sunar.

DevOps ve MLOps için Tasarlandı

Triton, orkestrasyon ve ölçekleme için Kubernetes ile entegre olur, izleme sistemleri için Prometheus ölçümlerini dışa aktarır, canlı model güncellemelerini destekler. Tüm büyük genel bulut makine öğrenimi (ML) ve Kubernetes platformlarında kullanılabilir. Triton, üretimde model dağıtımlarını standartlaştırmaya yardımcı olur.

Model Dağıtımını Kolaylaştırın

NVIDIA Triton Inference Server, aşağıdaki adımları gerçekleştirerek model çalıştırılmasını hızlandırır:

- Bütün büyük derin öğrenme ve makine öğrenmesi kütüphane backendlerini destekler.

- Aynı veya farklı kütüphanelerden birden fazla modeli aynı anda tek bir GPU veya CPU üzerinde çalıştırabilir. Triton, çoklu GPU’lu sunucuda kullanımı artırmak için otomatik olarak her modelin her GPU’da bir örneğini oluşturur.

- Gerçek zamanlı çıkarım için çıkarım hizmetini optimize etme, GPU/CPU kullanımını en üst düzeye çıkarmak için toplu çıkarım ve ses veri akışı girişi için yerleşik destekle akış çıkarımı yapar.

- Triton ayrıca, diyalog tabanlı AI gibi uçtan uca çıkarım gerçekleştirmek için birden fazla model gerektiren kullanım durumlarımda model grubunu da destekler.

- Maksimum gecikme kısıtlamaları altında yüksek aktarım hızı ve kullanım için girdi isteklerinin dinamik olarak gruplandırılması.

- Çıkarım sunucusunu yeniden başlatmadan veya uygulamayı bozmadan canlı olarak modeller güncellenebilir.

- Model analizörü, performansı en üst düzeye çıkarmak için otomatik olarak optimum model yapılandırmasını bulur.

- Büyük modeller için çoklu GPU ve çok düğümlü çıkarımı destekler.

NVIDIA Triton Inference Server, aşağıdaki adımları gerçekleştirerek model çalıştırılmasını hızlandırır:

- Bütün büyük derin öğrenme ve makine öğrenmesi kütüphane backendlerini destekler.

- Aynı veya farklı kütüphanelerden birden fazla modeli aynı anda tek bir GPU veya CPU üzerinde çalıştırabilir. Triton, çoklu GPU’lu sunucuda kullanımı artırmak için otomatik olarak her modelin her GPU’da bir örneğini oluşturur.

- Gerçek zamanlı çıkarım için çıkarım hizmetini optimize etme, GPU/CPU kullanımını en üst düzeye çıkarmak için toplu çıkarım ve ses veri akışı girişi için yerleşik destekle akış çıkarımı yapar.

- Triton ayrıca, diyalog tabanlı AI gibi uçtan uca çıkarım gerçekleştirmek için birden fazla model gerektiren kullanım durumlarımda model grubunu da destekler.

- Maksimum gecikme kısıtlamaları altında yüksek aktarım hızı ve kullanım için girdi isteklerinin dinamik olarak gruplandırılması.

- Çıkarım sunucusunu yeniden başlatmadan veya uygulamayı bozmadan canlı olarak modeller güncellenebilir.

- Model analizörü, performansı en üst düzeye çıkarmak için otomatik olarak optimum model yapılandırmasını bulur.

- Büyük modeller için çoklu GPU ve çok düğümlü çıkarımı destekler.

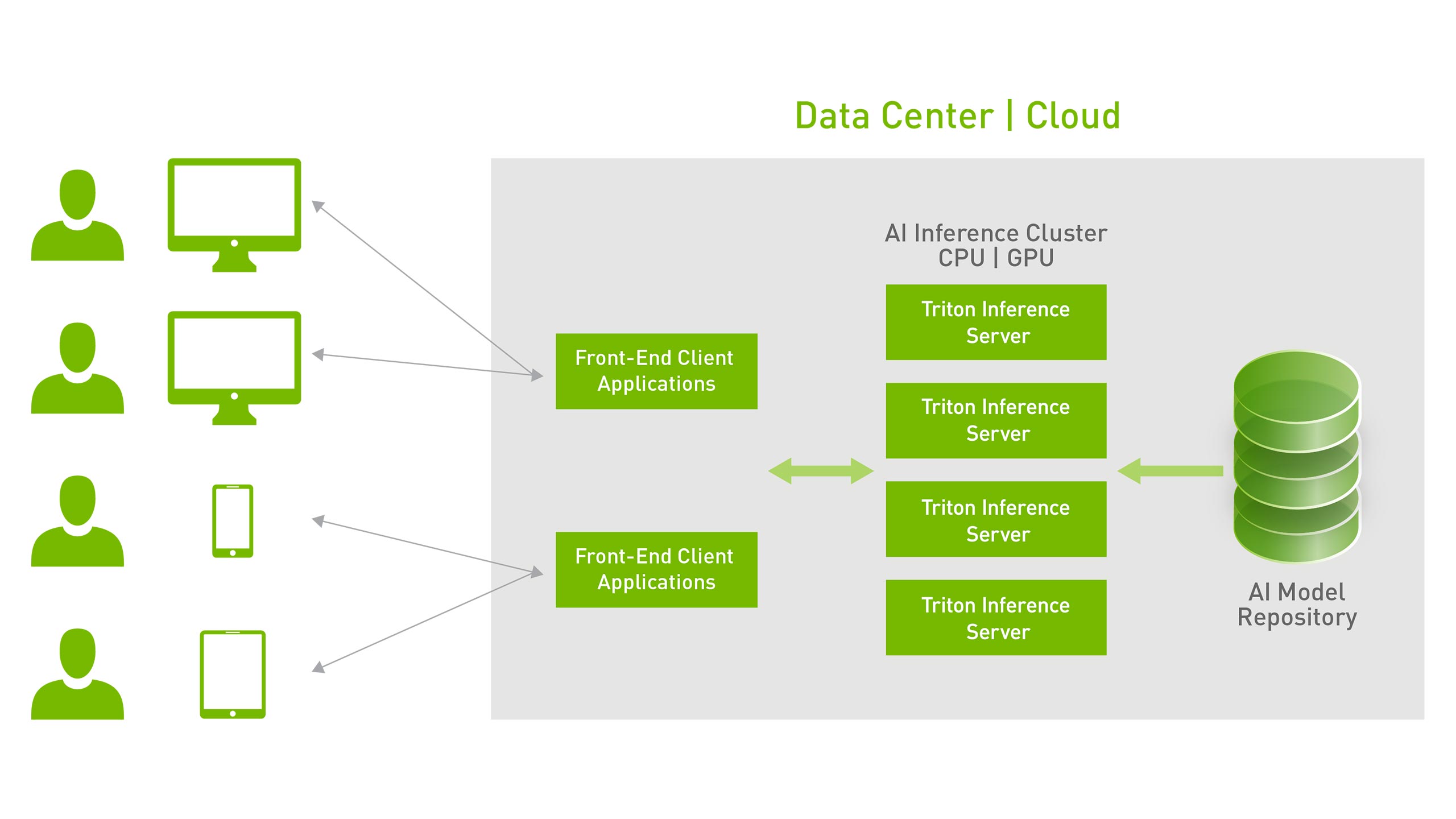

Dinamik Ölçeklenebilirlik

Docker konteyner olarak kullanılabilen Triton, orkestrasyon, metrikler ve oto-ölçeklendirme için Kubernetes ile entegre olur. Triton ayrıca uçtan uca AI iş akışı için Kubeflow ve Kubeflow veri hatlarıyla entegre olur. GPU kullanımını, gecikmeyi, bellek kullanımını ve çıkarım çıktısını izlemek için Prometheus ölçümlerini dışa aktarır. Triton ayrıca yük dengeleyiciler gibi diğer uygulamalara bağlanmak için standart HTTP/gRPC arayüzünü destekler. Herhangi bir model için artan çıkarım yüklerini işlemek için herhangi bir sayıda sunucuya kolayca ölçeklenebilir.

Triton, model kontrol API’si aracılığıyla onlarca hatta yüzlerce modele hizmet verebilir. Modeller, GPU veya CPU belleğine sığacak değişikliklere bağlı olarak çıkarım sunucusuna yüklenebilir ve çıkarım sunucusundan çıkarılabilir. Hem GPU’lar hem de CPU’larla heterojen bir kümeyi desteklemek, platformlar arasında çıkarımı standartlaştırmaya yardımcı olur ve en yüksek yükleri işlemek için herhangi bir CPU veya GPU’ya dinamik olarak ölçeklenir.

Çıkarım için En İyi Seçenek: Triton

AI her boyut ve ölçekte sektörler arası inovasyonun itici gücüdür. Bir açık kaynak yazılım çözümü olan Triton, AI çıkarım ve model dağıtımı için en iyi seçenektir. Triton, Alibaba Cloud, Amazon Elastic Kubernetes Service (EKS), Amazon Elastic Container Service (ECS), Amazon SageMaker, Google Kubernetes Engine (GKE), Google Vertex AI, HPE Ezmeral, Microsoft Azure Kubernetes Service (AKS), Azure Machine Learning ve Tencent Cloud tarafından desteklenir.

NVIDIA TRITON INFERENCE SERVER

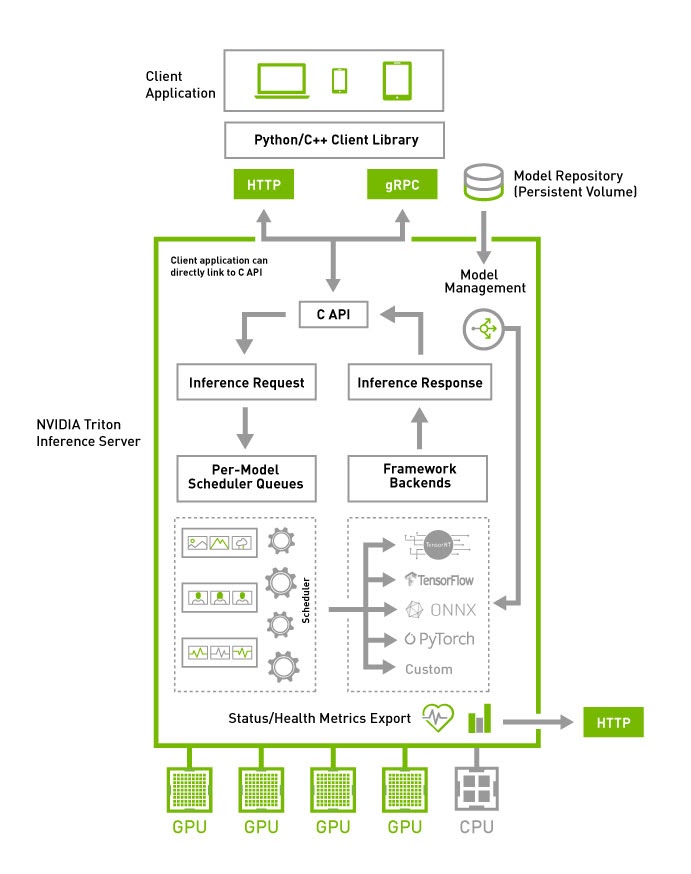

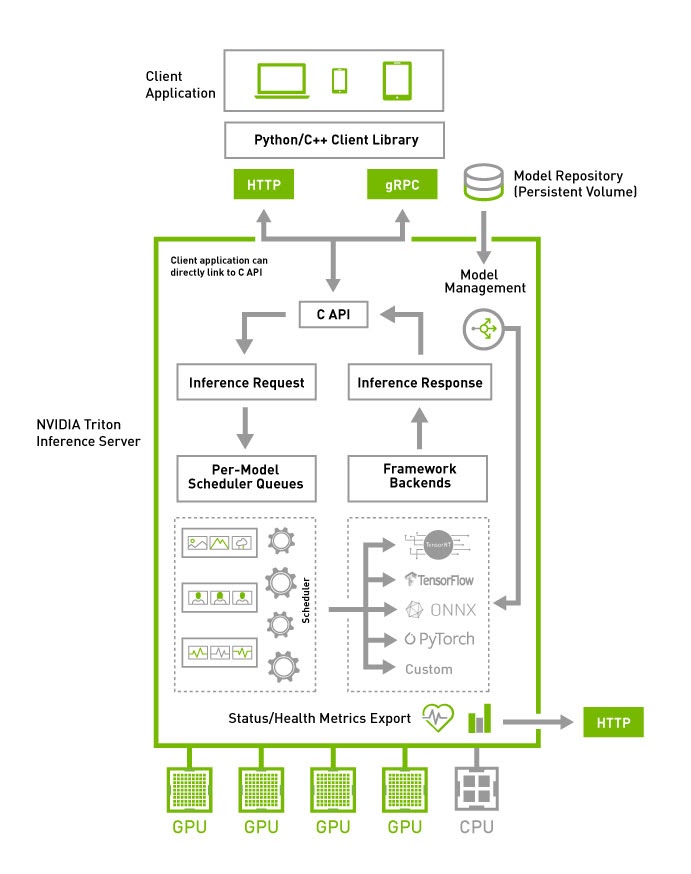

NVIDIA Triton™ Inference Server, ürünler için hızlı ve ölçeklenebilir AI sağlar. Açık kaynak çıkarım sağlama yazılımı olan Triton Inference Server, geliştiricilerin herhangi bir kütüphaneden (TensorFlow, NVIDIA TensorRT® Pytorch, ONNX, XGBoost, Python ve daha fazlası) GPU veya CPU tabanlı(bulutta, veri merkezinde veya uçta) bir altyapıda eğittiği AI modellerini çalıştırmasını sağlayarak AI çıkarımını kolaylaştırır.

Çoklu Kütüphane Desteği

Triton Inference Server, TensorFlow, TensorRT, PyTorch, MXNet, Python, ONNX, RAPIDS FIL (XGBoost, scikit-learn vb. kullanımı için), OpenVINO, özel C++ ve daha birçok büyük kütüphaneyi destekler. Triton, AI araştırmacılarının ve veri bilimcilerin, projeleri için doğru kütüphaneyi seçme özgürlüğü sağlar.

Yüksek Performanslı Çıkarım

Triton, verimi ve kullanılabilirliği en üst düzeye çıkarmak için modelleri GPU’larda eşzamanlı olarak çalıştırır. x86 ve ARM CPU tabanlı çıkarımı destekler. Dinamik gruplama, model analizörü, model topluluğu ve ses akışı gibi özellikler sunar.

DevOps ve MLOps için Tasarlandı

Triton, orkestrasyon ve ölçekleme için Kubernetes ile entegre olur, izleme sistemleri için Prometheus ölçümlerini dışa aktarır, canlı model güncellemelerini destekler. Tüm büyük genel bulut makine öğrenimi (ML) ve Kubernetes platformlarında kullanılabilir. Triton, üretimde model dağıtımlarını standartlaştırmaya yardımcı olur.

Model Dağıtımını Kolaylaştırın

NVIDIA Triton Inference Server, aşağıdaki adımları gerçekleştirerek model çalıştırılmasını hızlandırır:

- Bütün büyük derin öğrenme ve makine öğrenmesi kütüphane backendlerini destekler.

- Aynı veya farklı kütüphanelerden birden fazla modeli aynı anda tek bir GPU veya CPU üzerinde çalıştırabilir. Triton, çoklu GPU’lu sunucuda kullanımı artırmak için otomatik olarak her modelin her GPU’da bir örneğini oluşturur.

- Gerçek zamanlı çıkarım için çıkarım hizmetini optimize etme, GPU/CPU kullanımını en üst düzeye çıkarmak için toplu çıkarım ve ses veri akışı girişi için yerleşik destekle akış çıkarımı yapar.

- Triton ayrıca, diyalog tabanlı AI gibi uçtan uca çıkarım gerçekleştirmek için birden fazla model gerektiren kullanım durumlarımda model grubunu da destekler.

- Maksimum gecikme kısıtlamaları altında yüksek aktarım hızı ve kullanım için girdi isteklerinin dinamik olarak gruplandırılması.

- Çıkarım sunucusunu yeniden başlatmadan veya uygulamayı bozmadan canlı olarak modeller güncellenebilir.

- Model analizörü, performansı en üst düzeye çıkarmak için otomatik olarak optimum model yapılandırmasını bulur.

- Büyük modeller için çoklu GPU ve çok düğümlü çıkarımı destekler.

NVIDIA Triton Inference Server, aşağıdaki adımları gerçekleştirerek model çalıştırılmasını hızlandırır:

- Bütün büyük derin öğrenme ve makine öğrenmesi kütüphane backendlerini destekler.

- Aynı veya farklı kütüphanelerden birden fazla modeli aynı anda tek bir GPU veya CPU üzerinde çalıştırabilir. Triton, çoklu GPU’lu sunucuda kullanımı artırmak için otomatik olarak her modelin her GPU’da bir örneğini oluşturur.

- Gerçek zamanlı çıkarım için çıkarım hizmetini optimize etme, GPU/CPU kullanımını en üst düzeye çıkarmak için toplu çıkarım ve ses veri akışı girişi için yerleşik destekle akış çıkarımı yapar.

- Triton ayrıca, diyalog tabanlı AI gibi uçtan uca çıkarım gerçekleştirmek için birden fazla model gerektiren kullanım durumlarımda model grubunu da destekler.

- Maksimum gecikme kısıtlamaları altında yüksek aktarım hızı ve kullanım için girdi isteklerinin dinamik olarak gruplandırılması.

- Çıkarım sunucusunu yeniden başlatmadan veya uygulamayı bozmadan canlı olarak modeller güncellenebilir.

- Model analizörü, performansı en üst düzeye çıkarmak için otomatik olarak optimum model yapılandırmasını bulur.

- Büyük modeller için çoklu GPU ve çok düğümlü çıkarımı destekler.

Dinamik Ölçeklenebilirlik

Docker konteyner olarak kullanılabilen Triton, orkestrasyon, metrikler ve oto-ölçeklendirme için Kubernetes ile entegre olur. Triton ayrıca uçtan uca AI iş akışı için Kubeflow ve Kubeflow veri hatlarıyla entegre olur. GPU kullanımını, gecikmeyi, bellek kullanımını ve çıkarım çıktısını izlemek için Prometheus ölçümlerini dışa aktarır. Triton ayrıca yük dengeleyiciler gibi diğer uygulamalara bağlanmak için standart HTTP/gRPC arayüzünü destekler. Herhangi bir model için artan çıkarım yüklerini işlemek için herhangi bir sayıda sunucuya kolayca ölçeklenebilir.

Triton, model kontrol API’si aracılığıyla onlarca hatta yüzlerce modele hizmet verebilir. Modeller, GPU veya CPU belleğine sığacak değişikliklere bağlı olarak çıkarım sunucusuna yüklenebilir ve çıkarım sunucusundan çıkarılabilir. Hem GPU’lar hem de CPU’larla heterojen bir kümeyi desteklemek, platformlar arasında çıkarımı standartlaştırmaya yardımcı olur ve en yüksek yükleri işlemek için herhangi bir CPU veya GPU’ya dinamik olarak ölçeklenir.

Çıkarım için En İyi Seçenek: Triton

AI her boyut ve ölçekte sektörler arası inovasyonun itici gücüdür. Bir açık kaynak yazılım çözümü olan Triton, AI çıkarım ve model dağıtımı için en iyi seçenektir. Triton, Alibaba Cloud, Amazon Elastic Kubernetes Service (EKS), Amazon Elastic Container Service (ECS), Amazon SageMaker, Google Kubernetes Engine (GKE), Google Vertex AI, HPE Ezmeral, Microsoft Azure Kubernetes Service (AKS), Azure Machine Learning ve Tencent Cloud tarafından desteklenir.