DERİN ÖĞRENME ÇIKARIM PLATFORMU

Bulut, Veri Merkezi, Uç ve Otonom Makineler için Çıkarım Yazılımı ve Hızlandırıcılar

DERİN ÖĞRENME ÇIKARIM PLATFORMU

Bulut, Veri Merkezi, Uç ve Otonom Makineler için Çıkarım Yazılımı ve Hızlandırıcılar

DAHA HIZLI AI. DAHA AZ MALİYET.

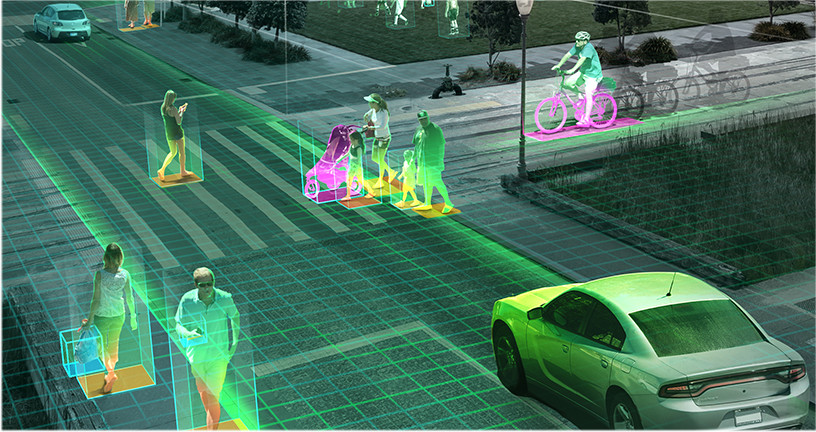

Görüntü tanıma, ses tanıma , doğal dil işleme, görsel arama ve kişiselleştirilmiş öneriler gibi karmaşık yapay zeka özellikli hizmetlere yönelik artan bir talep var. Aynı zamanda, veri kümelerinin büyümesi ve ağların daha karmaşık hale gelmesi gecikmeyi artırdığı için kullanıcı beklentilerini karşılamak güçleşiyor.

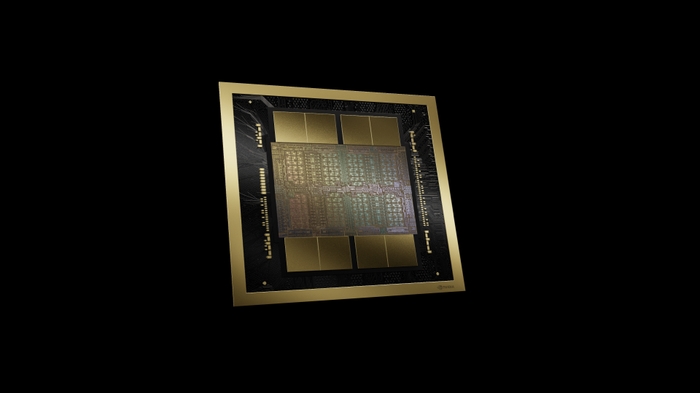

NVIDIA’nın çıkarım platformu, bulutta, veri merkezinde, uçta ve otonom makinelerde yeni nesil AI ürün ve hizmetlerine güç sağlamak için yüksek performans, verimlilik ve yanıt verme hızı sağlıyor.

DAHA HIZLI AI. DAHA AZ MALİYET.

Görüntü tanıma, ses tanıma , doğal dil işleme, görsel arama ve kişiselleştirilmiş öneriler gibi karmaşık yapay zeka özellikli hizmetlere yönelik artan bir talep var. Aynı zamanda, veri kümelerinin büyümesi ve ağların daha karmaşık hale gelmesi gecikmeyi artırdığı için kullanıcı beklentilerini karşılamak güçleşiyor.

NVIDIA’nın çıkarım platformu, bulutta, veri merkezinde, uçta ve otonom makinelerde yeni nesil AI ürün ve hizmetlerine güç sağlamak için yüksek performans, verimlilik ve yanıt verme hızı sağlıyor.

DAHA HIZLI AI. DAHA AZ MALİYET.

Görüntü tanıma, ses tanıma , doğal dil işleme, görsel arama ve kişiselleştirilmiş öneriler gibi karmaşık yapay zeka özellikli hizmetlere yönelik artan bir talep var. Aynı zamanda, veri kümelerinin büyümesi ve ağların daha karmaşık hale gelmesi gecikmeyi artırdığı için kullanıcı beklentilerini karşılamak güçleşiyor.

NVIDIA’nın çıkarım platformu, bulutta, veri merkezinde, uçta ve otonom makinelerde yeni nesil AI ürün ve hizmetlerine güç sağlamak için yüksek performans, verimlilik ve yanıt verme hızı sağlıyor.

NVIDIA TensorRT İLE NVIDIA GPU’LARIN POTANSİYELİNİ AÇIĞA ÇIKARIN

NVIDIA® TensorRT™, NVIDIA Tensor Core GPU’ların gücünü ortaya çıkarmanın anahtarı olan yüksek performanslı bir çıkarım platformudur. Yalnızca CPU platformlarına kıyasla gecikmeyi en aza indirirken 40 kata kadar daha yüksek verim sağlar. TensorRT’yi kullanarak herhangi bir yazılım çerçevesinden başlayıp üretimde eğitimli sinir ağlarını hızla optimize edebilir, doğrulayabilir ve dağıtabilirsiniz. TensorRT, NVIDIA NGC kataloğunda da mevcuttur.

NVIDIA TensorRT İLE NVIDIA GPU’LARIN POTANSİYELİNİ AÇIĞA ÇIKARIN

NVIDIA® TensorRT™, NVIDIA Tensor Core GPU’ların gücünü ortaya çıkarmanın anahtarı olan yüksek performanslı bir çıkarım platformudur. Yalnızca CPU platformlarına kıyasla gecikmeyi en aza indirirken 40 kata kadar daha yüksek verim sağlar. TensorRT’yi kullanarak herhangi bir yazılım çerçevesinden başlayıp üretimde eğitimli sinir ağlarını hızla optimize edebilir, doğrulayabilir ve dağıtabilirsiniz. TensorRT, NVIDIA NGC kataloğunda da mevcuttur.

NVIDIA TRITON INFERENCE SERVER İLE KURULUMU KOLAYLAŞTIRIN

Eskiden TensorRT Inference Server olarak bilinen NVIDIA Triton Inference Server, üretimde derin öğrenme modellerinin dağıtımını basitleştiren açık kaynaklı bir yazılımdır. Triton Inference Server, ekiplerin herhangi bir GPU veya CPU tabanlı altyapıda yerel depolama, Google Cloud Platform veya AWS S3’ten herhangi bir yazılım çerçevesinden (TensorFlow, PyTorch, TensorRT Planı, Caffe, MXNet veya özel) eğitimli AI modellerini dağıtmasına olanak tanır. Kullanımı en üst düzeye çıkarmak için birden çok modeli aynı anda tek bir GPU üzerinde çalıştırır. Düzenleme, ölçüm ve otomatik ölçeklendirme için Kubernetes ile entegre olur.

NVIDIA TRITON INFERENCE SERVER İLE KURULUMU KOLAYLAŞTIRIN

Eskiden TensorRT Inference Server olarak bilinen NVIDIA Triton Inference Server, üretimde derin öğrenme modellerinin dağıtımını basitleştiren açık kaynaklı bir yazılımdır. Triton Inference Server, ekiplerin herhangi bir GPU veya CPU tabanlı altyapıda yerel depolama, Google Cloud Platform veya AWS S3’ten herhangi bir yazılım çerçevesinden (TensorFlow, PyTorch, TensorRT Planı, Caffe, MXNet veya özel) eğitimli AI modellerini dağıtmasına olanak tanır. Kullanımı en üst düzeye çıkarmak için birden çok modeli aynı anda tek bir GPU üzerinde çalıştırır. Düzenleme, ölçüm ve otomatik ölçeklendirme için Kubernetes ile entegre olur.

ÖLÇEKLENEBİLİR DERİN ÖĞRENME ÇIKARIM PLATFORMU

Birleştirilmiş tek bir mimariyle, her derin öğrenme çerçevesindeki sinir ağları eğitilebilir, NVIDIA TensorRT ile optimize edilebilir ve ardından uçta gerçek zamanlı çıkarım için dağıtılabilir. NVIDIA DGX™ Sistemleri , NVIDIA Tensor Core GPU’lar , NVIDIA Jetson™ ve NVIDIA DRIVE™ ile NVIDIA, MLPerf karşılaştırma paketinde gösterildiği gibi uçtan uca, tamamen ölçeklenebilir bir derin öğrenme platformu sağlar.

BÜYÜK ÖLÇEKTE MALİYET TASARRUFUNUZU GÖRÜN

Sunucuları maksimum üretkenlikte tutmak için veri merkezi yöneticilerinin performans ve verimlilik arasında bir seçim yapmaları gerekebilir. Tek bir NVIDIA T4 sunucusu, derin öğrenme çıkarım uygulamaları ve hizmetleri için birden fazla ticari CPU sunucusunun yerini alabilir, enerji gereksinimlerini azaltır ve hem satın alma hem de operasyonel maliyet tasarrufu sağlar.

ÖLÇEKLENEBİLİR DERİN ÖĞRENME ÇIKARIM PLATFORMU

Birleştirilmiş tek bir mimariyle, her derin öğrenme çerçevesindeki sinir ağları eğitilebilir, NVIDIA TensorRT ile optimize edilebilir ve ardından uçta gerçek zamanlı çıkarım için dağıtılabilir. NVIDIA DGX™ Sistemleri , NVIDIA Tensor Core GPU’lar , NVIDIA Jetson™ ve NVIDIA DRIVE™ ile NVIDIA, MLPerf karşılaştırma paketinde gösterildiği gibi uçtan uca, tamamen ölçeklenebilir bir derin öğrenme platformu sağlar.

BÜYÜK ÖLÇEKTE MALİYET TASARRUFUNUZU GÖRÜN

Sunucuları maksimum üretkenlikte tutmak için veri merkezi yöneticilerinin performans ve verimlilik arasında bir seçim yapmaları gerekebilir. Tek bir NVIDIA T4 sunucusu, derin öğrenme çıkarım uygulamaları ve hizmetleri için birden fazla ticari CPU sunucusunun yerini alabilir, enerji gereksinimlerini azaltır ve hem satın alma hem de operasyonel maliyet tasarrufu sağlar.